M

mooncast

Guest

reaktive Musik -

ich zitiere:

en.m.wikipedia.org

en.m.wikipedia.org

Hier gehts um Musik die aus Umweltgeräuschen, User (Inter)aktionen und ähnlichem in Echtzeit generiert wird.

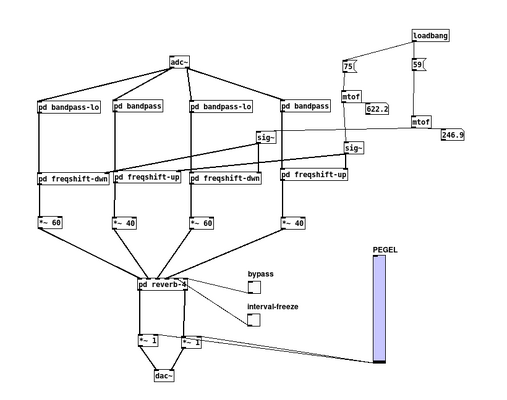

Rjdj war eine auf Pure Data bsierende App die das gemacht hat.

Was ich mich frage ist ob und wie man das Konzept wieder aufgreifen, erweitern und aus dem solipsistischem Einzelerlebnisgefängnis zu etwas Gruppeninteraktivem machen kann, dh zB die Geräuschkulisse in einem Cafe in Cafehausmusik verwandeln kann.

Ein Problem dabei ist, dass die Musik dann rückkoppelt was zu unerwünschten Ergebnissen und Problemen führt.

Das lässt sich wegen der Dispersion und den unterschiedlichen Laufzeiten der Echos im Raum auch schwer verhindern.

Vielleicht kann man den Raum vorher bzw das System vorher auf den Raum kalibrieren, aber erstens ist ein voller Raum in der Hinsicht anders als ein leerer und zweitens wird es nicht vollständig gelingen.

Welche Ideen gibts noch das Rückkoppelungsproblem in den Griff zu kriegen?

Auch ein Problem: Sprachgewirr plus Musik aus Sprachgewirr = ungute Akkustik was Sprachverständnis angeht.

Ideen dazu?

ich zitiere:

Reactive music is closely connected to generative music, interactive music, and augmented reality. Similar to music in video games, that is changed by specific events happening in the game, reactive music is affected by events occurring in the real life of the listener. Reactive music adapts to a listener and their environment by using built in sensors (e.g. camera, microphone, accelerometer, touch-screen and GPS) in mobile media players. The main difference to generative music is that listeners are part of the creative process, co-creating the music with the composer. Reactive music is also able to augment and manipulate the listeners real-world auditory environment.[3]

What is distributed in reactive music is not the music itself, but software that generates the music.[4]

RjDj - Wikipedia

Hier gehts um Musik die aus Umweltgeräuschen, User (Inter)aktionen und ähnlichem in Echtzeit generiert wird.

Rjdj war eine auf Pure Data bsierende App die das gemacht hat.

Was ich mich frage ist ob und wie man das Konzept wieder aufgreifen, erweitern und aus dem solipsistischem Einzelerlebnisgefängnis zu etwas Gruppeninteraktivem machen kann, dh zB die Geräuschkulisse in einem Cafe in Cafehausmusik verwandeln kann.

Ein Problem dabei ist, dass die Musik dann rückkoppelt was zu unerwünschten Ergebnissen und Problemen führt.

Das lässt sich wegen der Dispersion und den unterschiedlichen Laufzeiten der Echos im Raum auch schwer verhindern.

Vielleicht kann man den Raum vorher bzw das System vorher auf den Raum kalibrieren, aber erstens ist ein voller Raum in der Hinsicht anders als ein leerer und zweitens wird es nicht vollständig gelingen.

Welche Ideen gibts noch das Rückkoppelungsproblem in den Griff zu kriegen?

Auch ein Problem: Sprachgewirr plus Musik aus Sprachgewirr = ungute Akkustik was Sprachverständnis angeht.

Ideen dazu?