der Typ ist exakt so, wie ich mir ein Unigewächs vorstelle. Jemand, der nur an einer Uni existieren kann.

Vielleicht liege ich falsch, ich hab mir nur 7 minuten angesehen, dann hatte ich genug. Ich würde aber trotzdem

eine Wette eingehen, daß der nur zwischen zu Hause, Hörsaal und Mensa pendelt. Dabei tolle Ideen hat, die

aber nicht zu konkreten Lösungen führen.

Was das Konzept angeht: wie gesagt, hab das Video nur überflogen, aber mir schien, seine Argumentation

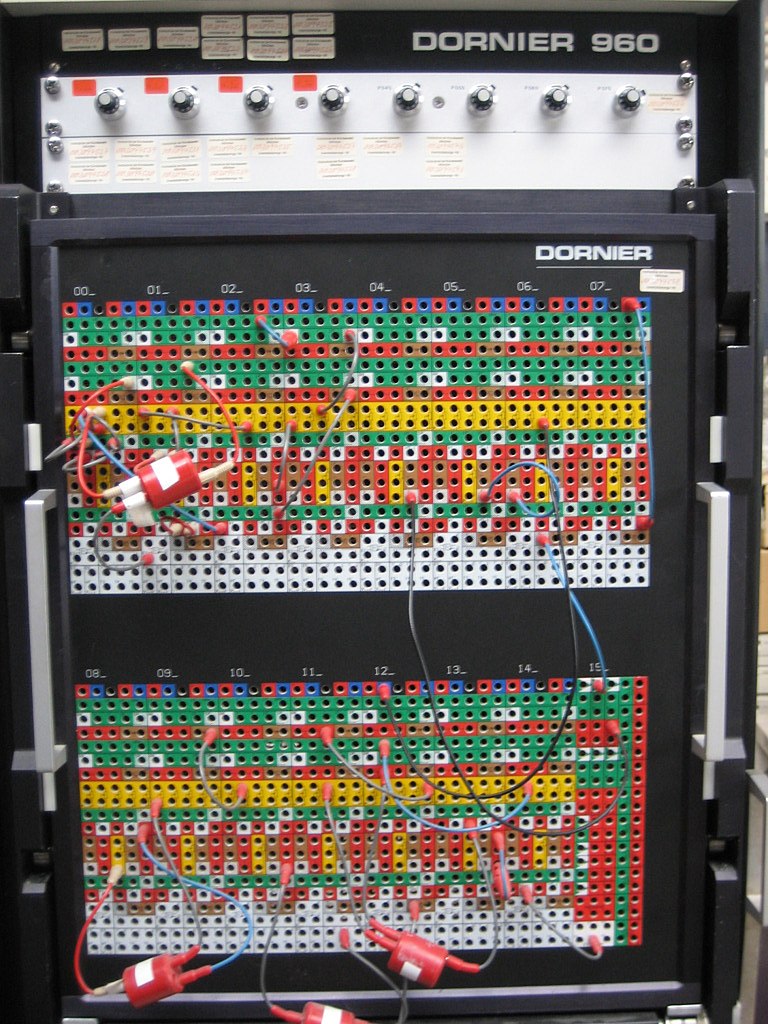

FÜR seinen komischen Analogrechner bestand darin, über Digitalrechner herzuziehen.

Vielleicht kann mir jemand, der sich das Video vollständig angesehen hat, folgende Fragen beantworten:

1. was zum Beispiel kann ich mit einem Analogrechner schneller berechnen als mit einem digitalen?

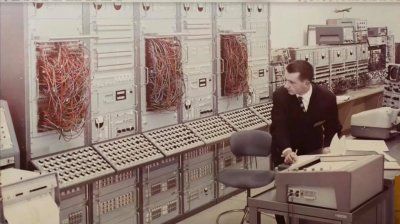

2. wie wäre der jeweilige Programmieraufwand für Analog-/Digitalrechner? Wenn ich mit Kabeln programmiere,

muß ich z.B. auch jeden Rechner einzeln programmieren. Ich kann aber innerhalb von Sekunden ein Programm auf tausend

Digitalrechnern installieren.

3. wie zum Teufel DEBUGGE ich ein Programm auf einem Analogrechner?

Mir scheint allein die Idee sehr akademisch. Wie ein Quantencomputer: wir arbeiten an einer Lösung, wissen aber noch

nicht, für welches Problem.

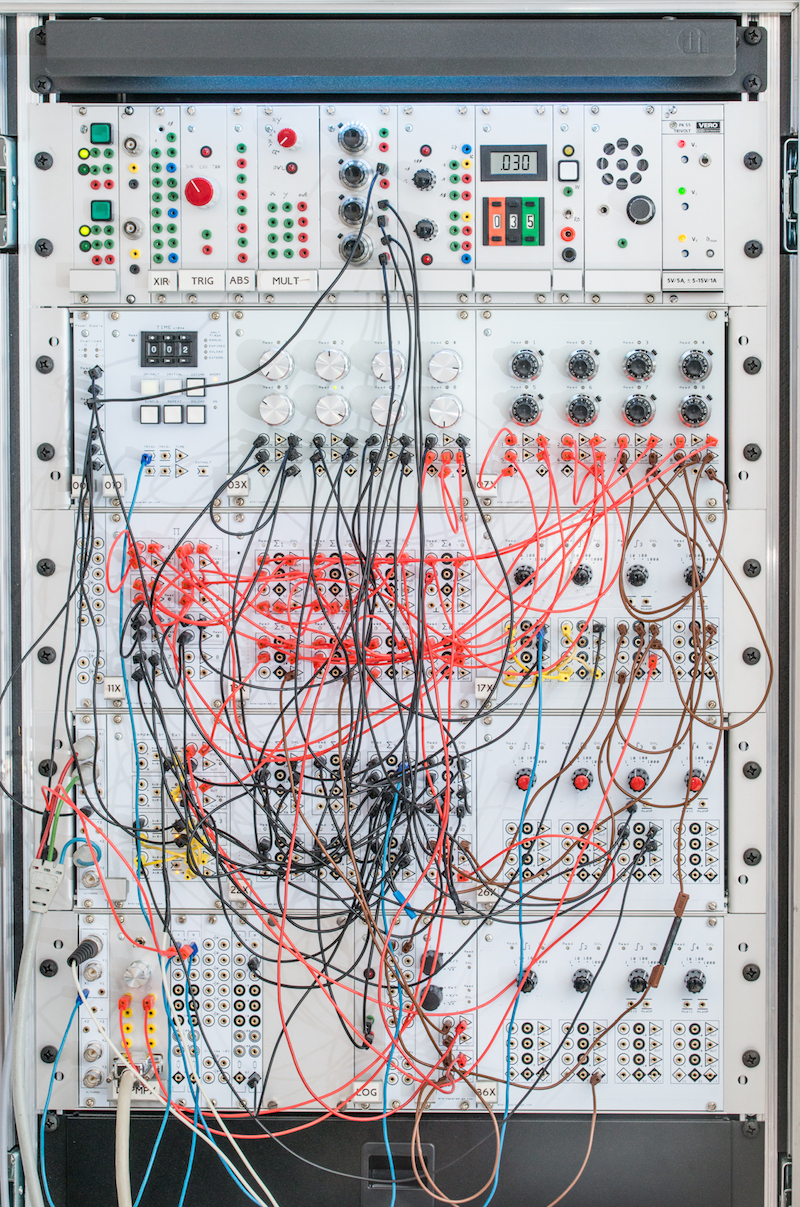

Ja, die LEute hauen dir Zeug um die Ohren und du kannst es nicht prüfen, er hätte genau so gut einen Minimoog hinstellen können, ich hätt es genau so gut gefunden oder irgendein Modular - sieht ja auch so aus - ist ja auch irgendwie nicht weit weg. Comparator und so - kennen wir ja auch. Sogar was die machen. Aber Mathe konnte ich nicht parsen, da bin ich langsam. Und so funktioniert natürlich auch Eso und VT, weil es so eine schöne Abkürzung ist - ich würde bei dem ver2feln, es gern hören weil es inspiriert - aber ich würde niemals was damit machen können. Weil… tja, ich halt nicht weiss wie man das alles sinnvoll macht - er scheint es aber zumindest zu wissen.

Natürlich trollt er uns mit dem Shit - ich finds trotzdem super auf der Inspirationsebene und da lass ich dann nichts kommen - Auf dem CCC / 3XC3 lass ich mir sowas gern erzählen - weil ... klar.

Analogrechner können nichts, sind nicht flexibel - sie können nur eine Sache und das ist natürlich klar und auch ihm.

Ich würde sagen - es ist eben auch eine Sichtsache aber - ich finde es könnte zu einer Ästhetik reifen die mit sowas bestimmten Leuten - vermutlich eher Studenten Dinge zeigen könnte, so wie man mit dem Oszilloskop Sounds etwas nachvollziehen kann bzw. mit dem Spectrum Analyzer. Debug ist ggf. einfacher, weil du weniger machen kannst. Das ist ja nicht BASIC wo man eigentlich jedes Problem bauen kann. Kaffeemaschine oder Spiel, Matheproblem oder Oszillator. Ich hab Basic geliebt deshalb. Das ist von MS.

Aber daran sieht man auch wie das so ist wenn man über KI redet - da wird unfassbar viel getriggert - aber KI ist heute genau so großes Blasengespräch und hey, noch kein Auto fährt autonom, noch kein OS ist schlau genug mir alles abzunehmen und keine KI versteht auch nur den Sinn eines Halbsatzes zusammen mit einem zweiten anderen Halbsatz. Wer das Gegenstück hat schaut Quarks und Co über KI / Machine Learning - Faszinierend, aber eigentlich unfassbarer Bulllshit. Aaaaber - es ist für Probleme durchaus da - für ML und KI fallen mir viele gute Lösungen ein, sei es auch nur Erkennungshilfen und sowas für Raussuchen aus riesigen Mengen. Das könnten sie und Zusammenhänge herstellen - manchmal auch zwischen Dingen die keine Zusammenhänge haben. Sowas find ich aber auch faszinierend, so wie die wirkliche Logik. Die die man in Philsophie lernt, 1-2 Semester. Vulkanier können es, wir so halb. Kirk gewinnt, Spock nicht. Naja..

Schachcomputer, Go spielen und so ist halt noch was anderes - Musiker ersetzen wäre noch was.

Aber es gibt Probleme die man mit Teilen solcher Ideen lösen helfen kann, oder veranschaulichen. Deshalb find ich es irgendwie doch gut, brilliant sogar hier und da.

mehr Inspiration

https://www.google.com/search?q=ana..._jkuAL&bih=1161&biw=2249#imgrc=EGYqoe_VRLGQoM sieht leider auch echt super aus - ich steh aber auf 50's Zeugs

Da ist dieser analoge Chip von 2005

https://dl.acm.org/doi/book/10.5555/1104333 als PDF

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.113.3740&rep=rep1&type=pdf

Die Folien vom Bernd sind hier

https://docplayer.org/60377430-Rechnen-ohne-algorithmen.html