Was mich ja jetzt mal interessieren würde, was passiert, wenn man ein Modell absichtlich falsch trainiert. Also zB eines, damit absichtlich total falsche Körperformen entstehen. Und was passiert, wenn man ein Base-Modell einfach nur mit einem Foto trainiert, entsteht dann digitale Glitch-Art oder wie kann man sich das vorstellen?

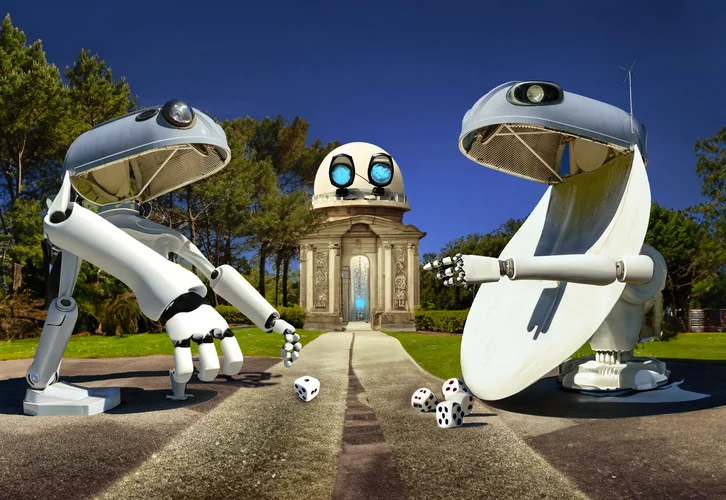

Bisher habe ich nur wenig Durchgänge gemacht, aber ich zeige mal ein paar Sachen als Beispiel.

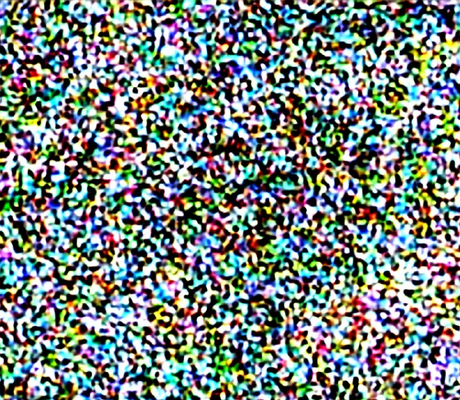

Stable Diffusion fängt mit einem verrauschtem Bild an. Ein anderer Teil schaut sich das an und vergleicht das Ergebnis mit der Eingabe, dem Prompt. Passt das nicht, wird das Bild nochmal angepasst. Das geht solange hin und her, bis ein 'richtiges' Bild entstanden ist, vereinfacht gesagt.

Das sind Bilder in verschiedenen Stufen der Entwicklung. (Anmerkung: Würde man den Bing Generator abbrechen können wie manche vermuten, würde das genau so unscharf aussehen je nachdem wie weit er schon gerechnet hat.)

Nun stell dir vor, das ganze ist eine Matrize vielen Feldern. Jedes Feld hat ein 'Gewicht' zwischen 0 und 1. Die Trainingsbilder werden nun dem Modell gezeigt und jetzt werden die Gewichte angepasst. Das spielt sich weit im Nachkommabereich ab.

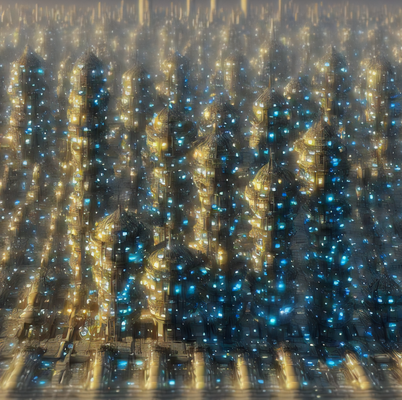

Will man zuviel, passiert genau das selbe wie in der Musik, es clippt und|oder das Gewicht schlägt um. Es werden dann nicht nur zum Beispiel einfach Körperteile verformt, sondern man sieht z.B. Artefakte im Bild.

Ebenso kann die Sättigung raufgehen oder komische Doppelungen entstehen bei einem leichten Übertrainieren.

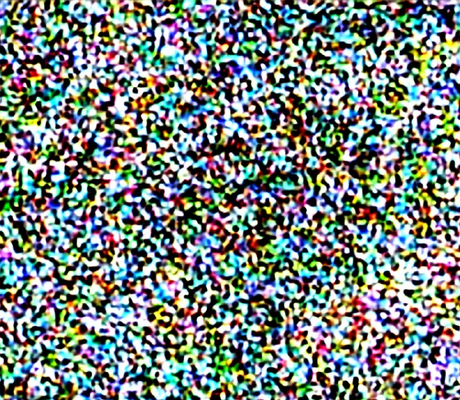

Wenn man noch weitergeht, sieht es dann so aus, das könnte man dann schon fast als Glitch Art bezeichnen:

Das geht halt soweit, das durch die übermäßige Gewichteanpassung am Ende nur noch Rauschen rauskommt.

Mein langfristiges Ziel ist, ein Basismodel so zu 'löschen', das bei jeglicher Eingabe nur noch Rauschen entsteht, quasi einmal mit dem Magneten über die VHS Kasette. Danach möchte ich das Modell selber mit eigenen Bilder trainieren (Feintuning) um zum einen Copyrightverletzungen vorzubeugen und zum anderen tatsächlich Copyright auf dem Output zu halten, die Ausgabe basiert zu 100% dann auf eigenen Bildern.

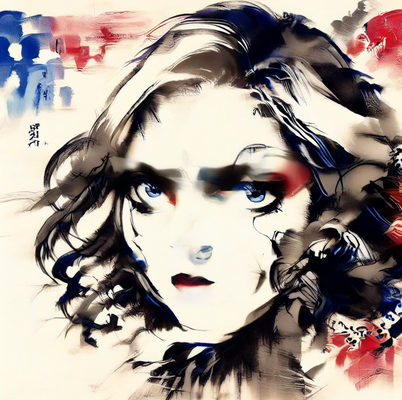

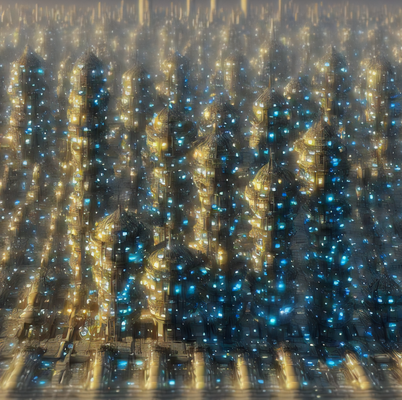

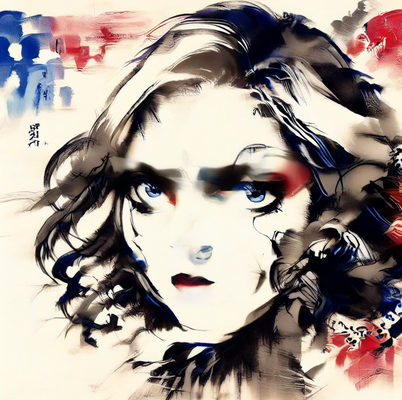

Das Ink Training (Bilder im vorletzten Post) oder das Sparkify Training (letzter Post) ist vom Basismodell komplett losgelöst und wird per Huckepack auf ein bestehendes Modell aufgesetzt (nennt sich LoRa). Der Dateninhalt basiert damit zu 100% auf eigenen Bildern.

Mit ein Grund warum ich selber niemals Künstlernamen oder irgendwelche Brands benutze, um Bilder zu generieren ala 'in style of picasso' oder 'bladerunner cinematic scene'. Würde ich selber auch nicht wollen.

Hätte ich 60k €, würde ich mir 2 fette Nvidia Karten kaufen und die Nummer von Grund auf selber anlegen, aber eine RTX4090 ist nur Spielzeug in dem Bereich. Für 100000 Bilder müsste ich den Pc einen ganzen Monat rechnen lassen. Die bestehenden Basismodelle wurden mit bis zu 5600000000 aus dem LAION Datensatz trainiert.

Disclaimer: Das ganze ist mathematisch schon interessanter Stoff und ich bin nur Anwender. Wer Fehler findet, bitte berichtigen, so haben alle was davon.