Scherer

...

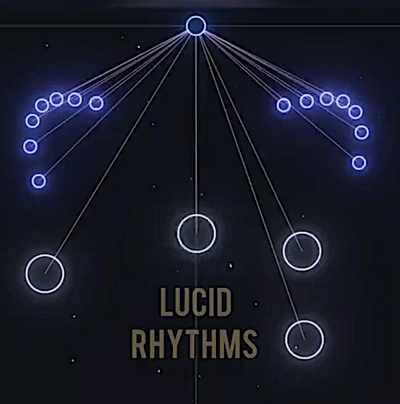

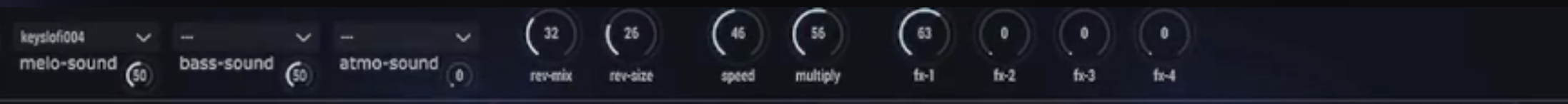

Kennt jemand Tools, Effekte, Synths oder Plug-ins, mit denen sich Sound visualisieren lässt? Und zwar so, dass die Elemente des Videos “auf den Sound hin arbeiten”.

Schwer mit Worten zu erklären, daher hier Video ein als Beispiel:

Die Optik “reagiert” nicht einfach auf Töne oder Frequenzen wie die meisten Visualiser, sondern kündigt sie an.

Ich habe schon alle möglichen NI Reaktor-Ensembles durchsucht und konnte paar Sachen finden, aber nichts, was annähernd hübsch aussieht. Freue mich daher über jeden Tipp & Hinweis.

Schwer mit Worten zu erklären, daher hier Video ein als Beispiel:

Die Optik “reagiert” nicht einfach auf Töne oder Frequenzen wie die meisten Visualiser, sondern kündigt sie an.

Ich habe schon alle möglichen NI Reaktor-Ensembles durchsucht und konnte paar Sachen finden, aber nichts, was annähernd hübsch aussieht. Freue mich daher über jeden Tipp & Hinweis.