App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Neueste KI zur Bilderzeugung

- Ersteller Lois

- Erstellt am

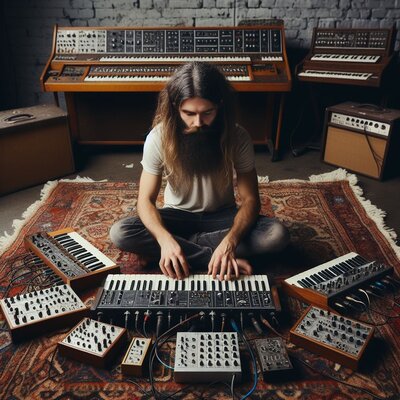

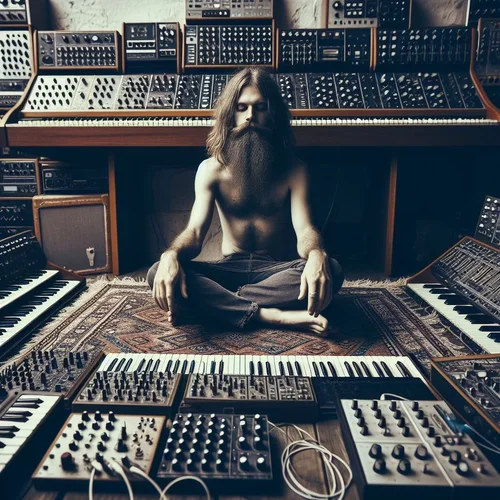

elabtronx

||||||||||

Da empfehle ich bei der Gelegenheit doch glatt mal den Kanal von Marius Leicht.. ; )

...damals entdeckt durch diesen clip

...damals entdeckt durch diesen clip

Zuletzt bearbeitet:

einseinsnull

[nur noch PN]

Ab wann beginnt die Grenze das es als "von KI erzeugt" gilt?

sowas interessiert im regelfall nur leute, die ein kommerzielles interesse daran haben sich immer möglichst dicht am alleräußerten rand der legalität zu bewegen, so frei nach dem motto "ist doch scheißegal ob das uns gehört oder ob wir nur so tun als ob, die hauptsache der kunde kann uns deswegen nicht verklagen".

aber so richtig spannend ist ja eher die andere seite, nämlich wenn schon die KI software selbst mithilfe von inhalten dritter gemacht wurden (bilddatenbanken).

Ist es von KI erzeugt wenn ich ein eigenes Bild nehme und lasse von KI nur ein kleines Detail ändern/hinzufügen?

was erwartest du: drittinstanzliche rechtsprechung, die klarstellt, dass pro 1 million pixel mindestens 91375 geändert werden müssen?

das urheberrecht ist eh geschichte, weil es niemand mehr beachtet und es nur mehr missbraucht wird als es irgendwas schützt.

die ganzen KI NFT-projekte müsste von rechtswegen die bafin morgen alle einkassieren, denn das ist alles betrug. und selbst dort, wo dabei steht, was ist es ist, ist es ein ziemlich unseriöser scheiß. die leute brignen es ja selbst in der "KI" unterrubrik noch fertig im contract zu behaupten, sie hätten die rechte an den inhalten.

einseinsnull

[nur noch PN]

apropos urheberrecht: mickey mouse is ja seit diesem monat gemeinfrei (90 jahre alt)

das könnte jetzt zu einer regelrechten KI mickey mouse comics welle führen!

Golden-Moon

Ambient...to the sky and back

Ich erwarte gar nichts. Ich wurde wahrscheinlich nicht richtig verstanden (nicht böse gemeint).was erwartest du

Das waren nur theoretische Fragen die definitiv aufkommen werden wenn KI-Bilder kommerziell genutzt werden sollen. Ich für meinen Teil habe das nicht vor

ollo

||||||||||||

apropos urheberrecht: mickey mouse is ja seit diesem monat gemeinfrei (90 jahre alt)

das könnte jetzt zu einer regelrechten KI mickey mouse comics welle führen!

Das gilt aber nur für die uralte Schwarz-Weiß Micky Maus.

Wikipedia sagt zum Beispiel:

Nach den ursprünglichen gesetzlichen Regelungen der USA wäre Mickey Mouse heute kein urheberrechtlich geschütztes Werk mehr. Die Verlängerung des Schutzes wurde jedoch durch eine Gesetzesänderung ermöglicht, den sogenannten Sonny Bono Copyright Term Extension Act. Seit dem 1. Januar 2024 ist die erste Version von Micky Maus sowie die erste Version von Minnie Maus aus dem Kurzfilm Steamboat Willie (1928) in den Vereinigten Staaten gemeinfrei und darf von jedem verwendet werden, wobei jedoch die kommerzielle Nutzung der Figuren eingeschränkt ist. In den meisten europäischen Ländern ist die Figur weiterhin urheberrechtlich geschützt.

Das waren nur theoretische Fragen die definitiv aufkommen werden wenn KI-Bilder kommerziell genutzt werden sollen. Ich für meinen Teil habe das nicht vor

Bei Bing heißt es, zumindest als ich das noch genutzt habe, dass es nicht kommerziell benutzt werden darf. Leonardo.ai sagt, dass man es ganz klar kommerziell nutzen darf.

Bei Stable Diffusion lokal auf dem Rechner wird es kompliziert. Jedes Model hat seine eigenen Lizenzvereinbarungen. Vieles ist frei, einige schreiben, dass man bei kommerzieller Nutzung den Ersteller des Models anschreiben muss. Und andere Modelle sind ganz klar mit copyrightgeschütztem Material feingetuned worden. Also zum Beispiel ein Model was Bart Simpson super generiert oder eines was mit Fotos von einem bekannten Model trainiert wurde. Daher nutze ich vorallem Modelle, die es auch bei Leonardo gibt, damit sollte man also auf der sicheren Seite sein.

Ansonsten stellt sich natürlich die Frage, inwieweit ein vermeintlicher Klänger überhaupt rausbekommt, mit welcher KI ein Bild erstellt wurde.

Im Moment ist das alles noch ziemlich wilder Westen, man sollte eben keine Sachen nutzen, die klar gegen Copyrights verstoßen. Donald Duck wie weiter oben oder sowas wie Darth Vader ist natürlich Tabu, egal ob man das komplett selber gemalt hat oder mit KI.

Zuletzt bearbeitet:

Golden-Moon

Ambient...to the sky and back

Mit dem vorgeschriebenen unsichtbaren Wasserzeichen für KI-generierte Bilder:Ansonsten stellt sich natürlich die Frage, inwieweit ein vermeintlicher Klänger überhaupt rausbekommt, mit welcher KI ein Bild erstellt wurde.

"Das unsichtbare digitale Wasserzeichen entspricht den C2PA-Spezifikationen und bestätigt die Zeit und das Datum der ursprünglichen Erstellung."

Gibt bestimmt auch andere aber das ist das was Bing verwendet.

einseinsnull

[nur noch PN]

Ich erwarte gar nichts. Ich wurde wahrscheinlich nicht richtig verstanden (nicht böse gemeint).

Das waren nur theoretische Fragen die definitiv aufkommen werden wenn KI-Bilder kommerziell genutzt werden sollen. Ich für meinen Teil habe das nicht vor

ja ist schon klar, aber auch auf der ebene gibt es vermutlich keine allgemeingültige antwort.

in gewisser hinsicht ist es lustig, wie man jetzt bei kommerziellen content-erstellern und -verkäufern jeder art hin- und hergerissen ist zwischen den vor- und nachteilen, die durch die quasi-public-domainisierung von jeglichem ehemals geschützem inhalt entstehen.

und das obwohl doch eigentlich alles beim alten bleibt: alles, was ich kommerziell nutzen darf obwohl ich keine rechte daran habe, kann ich meinem kunden nicht mehr exclusiv verkaufen oder verleasen. oder generell in irgendeiner form gegenüber drtiten behaupten, dass ich rechte daran hätte. weils ja nicht stimmt. was ja neben dem lizenzmodell des KI anbieters (was natürlich theoretisch selbst auch wieder falsch und angreifbar sein kann) vor allem gar kein schöpferisches werk ist.

dennoch versucht man in kleinkapitalistenkreisen krampfhaft die neuen möglichkeiten mithilfe automatisch generierten contents den eigenen umsatz zu steigern. sozusagen bevor die kunden demnächst in massen herausfinden, dass sie das dann eigentlich auch genausogut selbst machen könnten.

irgendwie erscheint es mir naheliegender - wenn man denn schon in geschäftsmodellen denkt - die neue technik einfach in den eigenen workflow zum erstellen schöpferischer werke einzubauen.

ollo

||||||||||||

Mit dem vorgeschriebenen unsichtbaren Wasserzeichen für KI-generierte Bilder:

"Das unsichtbare digitale Wasserzeichen entspricht den C2PA-Spezifikationen und bestätigt die Zeit und das Datum der ursprünglichen Erstellung."

Gibt bestimmt auch andere aber das ist das was Bing verwendet.

Dafür müsste aber jeder Dienst mitziehen und man müsste das Bild dann auch unbearbeitet lassen. Wenn das Wasserzeichen direkt im Bild versteckt ist, reicht ja schon etwas Bearbeitung mitunter aus und das fehlt oder ist nicht mehr zu lesen. Wenn es in irgendwelchen Metadaten steckt, mache ich halt einen Screenshot davon und dann sind die auch nicht mehr vorhanden.

Jedenfalls denke ich mir als Laie das so. Aktuell ist es echt wilder Westen, was natürlich seine Vorteile hat, weil man es als User einfach ausprobieren und nutzen kann, natürlich kann damit aber auch böswillig richtig schlimmes Zeug veranstaltet werden.

Aktuell macht es halt einfach Spaß Bilder just for fun privat zu basteln, bei kommerzieller Nutzung also als zB Youtube Bild für die eigene Musik würde ich mehr Arbeit reinstecken, damit alles abgesichert und okay ist, soweit man das abschätzen kann.

Soljanka

|||||||||||||

Heute waren dann wieder ein paar Boost aufgeladen. Nachdem ich die durchgerattert habe geht wieder nichts mehr bei Bing.

hm… Ich hab ein bisschen die Schnauze voll, von der Kacke.

Edit: Zumal ich auch mit den Ergebnissen nur bedingt zufrieden bing.

hm… Ich hab ein bisschen die Schnauze voll, von der Kacke.

Edit: Zumal ich auch mit den Ergebnissen nur bedingt zufrieden bing.

Zuletzt bearbeitet:

Golden-Moon

Ambient...to the sky and back

J

Juergi

|

Hi ihr KI-Freaks,

gibts schon eine Möglichkeit zum Beispiel Fussballer einer Mannschaft in die Trikots ihrer ärgsten Gegner zu montieren?

LG, Juergi

gibts schon eine Möglichkeit zum Beispiel Fussballer einer Mannschaft in die Trikots ihrer ärgsten Gegner zu montieren?

LG, Juergi

Golden-Moon

Ambient...to the sky and back

J

Juergi

|

A, Cool. Ja, so die Richtung.

Hatte das mal mit sehr anfängerhaften Versuchen in D@ll-E versucht. Das ging auch nur so halb. Gesichter und Embleme waren nicht so wirklich erkennbar.

Ab nem gewissen Detailgrad mochte er/sie dann auch nicht mehr.

Möchte damit ein paar Leute ärgern. So was wie H@rry K@ne im Trikot von 186O.

Hatte das mal mit sehr anfängerhaften Versuchen in D@ll-E versucht. Das ging auch nur so halb. Gesichter und Embleme waren nicht so wirklich erkennbar.

Ab nem gewissen Detailgrad mochte er/sie dann auch nicht mehr.

Möchte damit ein paar Leute ärgern. So was wie H@rry K@ne im Trikot von 186O.

S

Synthwaver

Back to Upside Down

Es gibt auch schon AI Porno Generatoren. Für Traumfrauen und so.Hi ihr KI-Freaks,

gibts schon eine Möglichkeit zum Beispiel Fussballer einer Mannschaft in die Trikots ihrer ärgsten Gegner zu montieren?

LG, Juergi

einseinsnull

[nur noch PN]

Dafür müsste aber jeder Dienst mitziehen

das werden sie müssen, wenn es der gesetzgeber vorschreibt, oder wollen, wenn sie selbst einen vorteil darin sehen.

und man müsste das Bild dann auch unbearbeitet lassen. Wenn das Wasserzeichen direkt im Bild versteckt ist, reicht ja schon etwas Bearbeitung mitunter aus und das fehlt oder ist nicht mehr zu lesen.

richtig. ein wasserzeichen oder ein meta tag bekommt man weg, indem man einfach den inhalt in eine neue datei kopiert.

wenn irgendwas nicht dazu geeignet ist rechteverletzungen automatisch im netz zu finden, dann das.

Möchte damit ein paar Leute ärgern.

Es gibt auch schon AI Porno Generatoren.

leute ärgern - pornos gucken - geld verdienen.

dann kommt lange nichts und dann kommen katzen, hunde, aliens und autos.

das ist das, was 90% der leute heute vom internet erwarten und weswegen die konzerne auch dumm wären, wenn sie den leuten dafür nicht das geld aus der tasche ziehen würden.

diejenigen, die das alles total "erschreckend" finden, was man damit alles machen kann, sind dann auch die ersten, die für 30 bilder pro monat ein 10 euro abo abschließen und das, was sie angeblich so schlimm finden letztlich möglich machen.

Golden-Moon

Ambient...to the sky and back

ollo

||||||||||||

Golden-Moon

Ambient...to the sky and back

VEB Synthesewerk

Thomas B. aus SAW

8

8ikjhgtzuk456789

Guest

Ich kann mich da nur fragen: wofür steht das I in KI? Ignoranz?das führt ohne detailierteren prompt zu sehr lustigen Ergebnissen:

Golden-Moon

Ambient...to the sky and back

Das nennt sich AI Hallicunation.Ich kann mich da nur fragen: wofür steht das I in KI? Ignoranz?

Golden-Moon

Ambient...to the sky and back

Also das beste was ich dahingehend hinbekomme ist:A, Cool. Ja, so die Richtung.

Hatte das mal mit sehr anfängerhaften Versuchen in D@ll-E versucht. Das ging auch nur so halb. Gesichter und Embleme waren nicht so wirklich erkennbar.

Ab nem gewissen Detailgrad mochte er/sie dann auch nicht mehr.

Möchte damit ein paar Leute ärgern. So was wie H@rry K@ne im Trikot von 186O.

Ist aber nur 50%KI und 50% meine "Fähigkeit".

kybernaut_01

No Fate!

Was macht B.I.C. in diesem Fall?Ich habe mal bei Stable Diffusion "pole dance woman" oder "pole dancing woman" ausprobiert, das führt ohne detailierteren prompt zu sehr lustigen Ergebnissen:

Anhang anzeigen 201534Anhang anzeigen 201535

Smai-Lee

|||

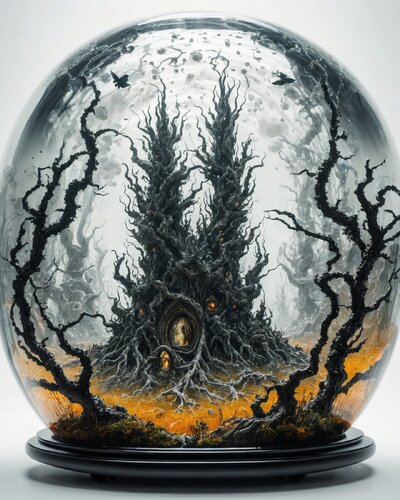

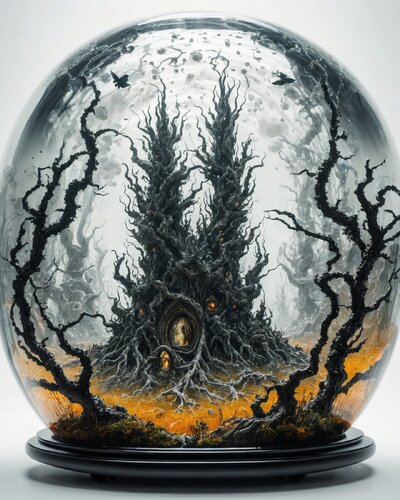

So, hat etwas länger gedauert als beabsichtigt, aber KI Training funktioniert jetzt zuverlässig. Da lagen doch ein paar Brocken im Weg. Ich versuche den Weg hier mal grob ohne viel Techtalk zu skizzieren. Als Ausgangspunkt diente mir eine Serie vom April letzten Jahres an der ich lange gesessen habe, einen bestimmten Stil in A1111 zu erzeugen (schwarz-rot mag ich gerne).

Davon ausgehend habe ich in ComfyUI 283 weitere Bilder erzeugt mit einer Auflösung von 1024x1024 für das finale Training:

Diese wurden dann sortiert, auf 106 Bilder reduziert und mit automatischen Beschriftungen versehen. Taggui funktioniert ganz ok. Diese Bildbeschreibungen mussten anschliessend händisch nachbearbeitet, falsche Zuordnungen gestrichen und ab und zu auch mal erweitert werden.

Für das Training habe ich Koyha_SS benutzt wie im letztzen Post schon geschrieben. Diese Bilder und Beschreibungen werden nun im Lernprozess der KI mehrfach gezeigt. Jede Runde ändert die Gewichte im Modell etwas mehr. Jede Version wird abgespeichert damit man später sich genau die Richtige rauspicken kann. Richtig heißt in diesem Fall, weder übertrainiert /erzeugt erst Haloränder und später einfach Chaos) noch zu wenig Einfluss auf die Bildgenerierung.

Jetzt geht es an das Testen. Hier ein paar Beispiele mit abgestuftem Einfluss:

1. female face

2. dancer

3. village, car, alien with rifle

Hier nun verschiedene Bilder mit wechselndem Einfluss, die damit entstanden sind:

Was ich bisher gemerkt habe, die Bildbeschreibungen und die Auswahl der Trainingsbilder sind auf jeden Fall die halbe Miete. Dazu kommt, die Parameterauswahl wie Lernrate oder Anzahl der Dimensionen sind nicht trivial, es spielt sich z.B. die Lernrate im Bereich von 0.0000001 bis 0.0001 ab, das ist ein recht großer Bereich. Diese wiederum wird von anderen Parametern beeinflusst. Kurz gesagt, ich nehme an, es gibt kein richtiges Patentrezept. Zum Styletraining findet man nur sehr wenig Informationen; Faceswap und Personen Tutorials gibt es massig genug (Warum wohl?^^)

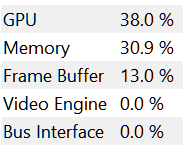

Als Basismodell habe ich SDXL mit einer Basisauflösung von 1024x1024 benutzt. Die VRAM Auslastung lag bei 23GB, also ganz knapp an den 24GB meiner Karte.

SD 1.5 braucht da weniger Speicher, man kann dort auch mit 512x512 trainieren, allerdings habe ich das verworfen.

Hier mal gesammelt die Links:

A1111 als Einstieg - ComfyUI modulare Bilderzeugung - Kohya_ss Training - Taggui Bilder taggen

Davon ausgehend habe ich in ComfyUI 283 weitere Bilder erzeugt mit einer Auflösung von 1024x1024 für das finale Training:

Diese wurden dann sortiert, auf 106 Bilder reduziert und mit automatischen Beschriftungen versehen. Taggui funktioniert ganz ok. Diese Bildbeschreibungen mussten anschliessend händisch nachbearbeitet, falsche Zuordnungen gestrichen und ab und zu auch mal erweitert werden.

Für das Training habe ich Koyha_SS benutzt wie im letztzen Post schon geschrieben. Diese Bilder und Beschreibungen werden nun im Lernprozess der KI mehrfach gezeigt. Jede Runde ändert die Gewichte im Modell etwas mehr. Jede Version wird abgespeichert damit man später sich genau die Richtige rauspicken kann. Richtig heißt in diesem Fall, weder übertrainiert /erzeugt erst Haloränder und später einfach Chaos) noch zu wenig Einfluss auf die Bildgenerierung.

Jetzt geht es an das Testen. Hier ein paar Beispiele mit abgestuftem Einfluss:

1. female face

2. dancer

3. village, car, alien with rifle

Hier nun verschiedene Bilder mit wechselndem Einfluss, die damit entstanden sind:

Was ich bisher gemerkt habe, die Bildbeschreibungen und die Auswahl der Trainingsbilder sind auf jeden Fall die halbe Miete. Dazu kommt, die Parameterauswahl wie Lernrate oder Anzahl der Dimensionen sind nicht trivial, es spielt sich z.B. die Lernrate im Bereich von 0.0000001 bis 0.0001 ab, das ist ein recht großer Bereich. Diese wiederum wird von anderen Parametern beeinflusst. Kurz gesagt, ich nehme an, es gibt kein richtiges Patentrezept. Zum Styletraining findet man nur sehr wenig Informationen; Faceswap und Personen Tutorials gibt es massig genug (Warum wohl?^^)

Als Basismodell habe ich SDXL mit einer Basisauflösung von 1024x1024 benutzt. Die VRAM Auslastung lag bei 23GB, also ganz knapp an den 24GB meiner Karte.

SD 1.5 braucht da weniger Speicher, man kann dort auch mit 512x512 trainieren, allerdings habe ich das verworfen.

Hier mal gesammelt die Links:

A1111 als Einstieg - ComfyUI modulare Bilderzeugung - Kohya_ss Training - Taggui Bilder taggen

ollo

||||||||||||

Die VRAM Auslastung lag bei 23GB, also ganz knapp an den 24GB meiner Karte.

SD 1.5 braucht da weniger Speicher, man kann dort auch mit 512x512 trainieren, allerdings habe ich das verworfen.

Interessant, also käme ich mit meinen 12gb V-Ram da nicht weit, was ich vorher so aber auch gedacht hätte, dass das nicht ausreicht. Ich bin ja froh, dass das generieren überhaupt so gut klappt. Wie lange hat das Training denn gedauert?

Was macht B.I.C. in diesem Fall?

Wohl gar nichts wie weiter oben geschrieben wurde, weil Pole Dance wohl schon zu weit geht.

Smai-Lee

|||

Habe das Programm grade nochmal kurz angeworfen, Training in 512x512 für SD 1.5 braucht rund 31%, sollte also auf 10-12GB VRAM funktionieren. Die Zeitdauer in der kleinen Auflösung ist knapp unter einer Stunde. Ich lasse das mal jetzt durchlaufen.Interessant, also käme ich mit meinen 12gb V-Ram da nicht weit, was ich vorher so aber auch gedacht hätte, dass das nicht ausreicht. Ich bin ja froh, dass das generieren überhaupt so gut klappt. Wie lange hat das Training denn gedauert?

Das SDXL Training hat wie oben geschrieben etwas über 3.5h gedauert, also tatsächlich etwa 4x solange für die 4fache Auflösung.

Auslastung und Zeitdauer:

Mehr SDXL Bilder:

Soljanka

|||||||||||||

Noch mal zu Bing. Also ich kann da täglich meine Boosts nutzen, danach ist Feierabend.

Vielleicht ist es ja auch ganz gut so.

Vielleicht ist es ja auch ganz gut so.

Similar threads

- Antworten

- 1K

- Aufrufe

- 153K

K

- Frage

- Antworten

- 224

- Aufrufe

- 8K

- Antworten

- 90

- Aufrufe

- 6K

T

- Antworten

- 76

- Aufrufe

- 3K

X

News

-

-

-

SequencerTalk 210 - letzte vor der Superbooth mit TGM Heiner Kruse "the green man"

- Gestartet von Moogulator

- Antworten: 1

-

-

-

-

Happy Knobbing 2024 Modular Synthesizer Meeting - Video / Pics

- Gestartet von Moogulator

- Antworten: 3