HOLODYNE

Bester Wisser & Groove Connaisseur

Die Tatsache, dass mir der Sound von MicroWave 1 als iOS Plugin wesentlich besser gefällt als die vom Protein, bei identischen Sound Einstellungen, hat mich nicht losgelassen. Ich bin mal in die Tiefen der Audio Processing/DSP Dokumentationen gegangen und hab sie von ChatGPT auswerten und von Gemini Pro gegen prüfen lassen.

KI Inhalt:

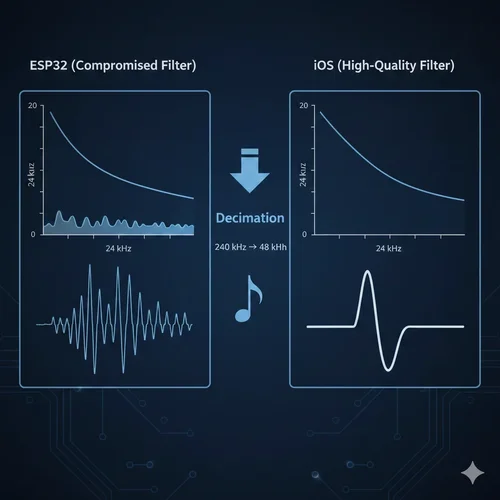

„Warum die iOS-App besser klingt als der ESP32-Synthesizer:

Die Überlegenheit des iOS-Sounds (mehr Dynamic, Glanz, Volumen) liegt an der überlegenen Rechenleistung (DSP) und dem saubereren Signalpfad des Smartphones, im Vergleich zur Embedded-Hardware des ESP32:

* Anti-Aliasing durch Oversampling:

* iOS: Die hohe CPU-Leistung erlaubt es, den Synthese-Code intern mit einer viel höheren Abtastrate (Oversampling) zu berechnen (z.B. 192 kHz). Dies verschiebt unerwünschtes Aliasing in unhörbare Bereiche, was den Klang glänzend und rein macht.

* ESP32: Muss oft mit der Standard-Abtastrate (44.1 kHz oder 48 kHz) ohne Oversampling arbeiten. Das resultierende Aliasing (Spiegelfrequenzen) führt zu einem härteren, weniger sauberen Sound.

* Sauberer Digital-Analog-Wandler (DAC) Pfad:

* iOS: Der eingebaute Audio-Stack bietet einen extrem rauscharmen, gut abgeschirmten DAC-Pfad mit optimiertem Power Management.

* ESP32: Die Audioqualität hängt stark von der Umsetzung der Platine ab. Der DAC-Ausgang ist anfällig für digitales Rauschen und Übersprechen von der ESP32-CPU und den Funkmodulen (WiFi/BT), was den Klang weniger voluminös macht.

* Präzision der Arithmetik:

* iOS: Verwendet verlustfreie Fließkomma-Arithmetik (Floating-Point), um Rundungsfehler zu vermeiden.

* ESP32: Muss eventuell Festkomma-Arithmetik (Fixed-Point) verwenden, was zu leichten Quantisierungsfehlern und Rauschen führen kann.

Kurz gesagt: Der iOS-Chip rechnet das Signal digital sauberer, und der Apple-Signalpfad wandelt es anschließend sauberer analog um.“

KI Inhalt Ende…..

Es scheint also doch nicht nur Geschmackssache zu sein, wenn die Ausführungen stimmen….

KI Inhalt:

„Warum die iOS-App besser klingt als der ESP32-Synthesizer:

Die Überlegenheit des iOS-Sounds (mehr Dynamic, Glanz, Volumen) liegt an der überlegenen Rechenleistung (DSP) und dem saubereren Signalpfad des Smartphones, im Vergleich zur Embedded-Hardware des ESP32:

* Anti-Aliasing durch Oversampling:

* iOS: Die hohe CPU-Leistung erlaubt es, den Synthese-Code intern mit einer viel höheren Abtastrate (Oversampling) zu berechnen (z.B. 192 kHz). Dies verschiebt unerwünschtes Aliasing in unhörbare Bereiche, was den Klang glänzend und rein macht.

* ESP32: Muss oft mit der Standard-Abtastrate (44.1 kHz oder 48 kHz) ohne Oversampling arbeiten. Das resultierende Aliasing (Spiegelfrequenzen) führt zu einem härteren, weniger sauberen Sound.

* Sauberer Digital-Analog-Wandler (DAC) Pfad:

* iOS: Der eingebaute Audio-Stack bietet einen extrem rauscharmen, gut abgeschirmten DAC-Pfad mit optimiertem Power Management.

* ESP32: Die Audioqualität hängt stark von der Umsetzung der Platine ab. Der DAC-Ausgang ist anfällig für digitales Rauschen und Übersprechen von der ESP32-CPU und den Funkmodulen (WiFi/BT), was den Klang weniger voluminös macht.

* Präzision der Arithmetik:

* iOS: Verwendet verlustfreie Fließkomma-Arithmetik (Floating-Point), um Rundungsfehler zu vermeiden.

* ESP32: Muss eventuell Festkomma-Arithmetik (Fixed-Point) verwenden, was zu leichten Quantisierungsfehlern und Rauschen führen kann.

Kurz gesagt: Der iOS-Chip rechnet das Signal digital sauberer, und der Apple-Signalpfad wandelt es anschließend sauberer analog um.“

KI Inhalt Ende…..

Es scheint also doch nicht nur Geschmackssache zu sein, wenn die Ausführungen stimmen….

Zuletzt bearbeitet: