ein multipanner ist ja auch die halbe miete, das machst du schon richtig.

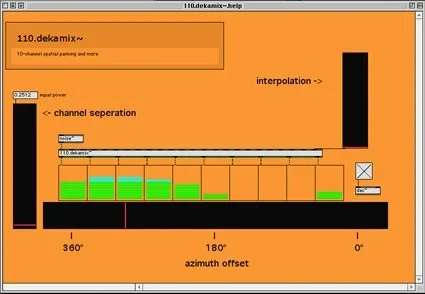

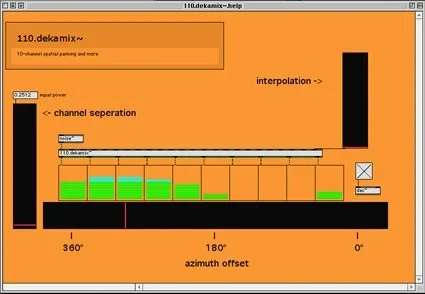

wie für 2, nur eben für 4 oder für 10, equal power panning oder auch noch breiter, und der letzte geht wieder in den ersten.

genau wie du wahrscheinlich benutze ich das auch nicht mit lautsprechern - sondern mit virtuellen lautsprechen in verschiedenen umgebungen und haue dann z.b. 10 verschiedene auralfilter (so hrtf mäßig) dahinter.

sofern die virtuellen lautsprecher alle den gleichen abstand haben, kann man auch problemlos welche noch in der tiefe verschieben (also aus einer weiter außen liegende kreislinie) - ein tiefpassfilter und ein delay ist alles was man dazu brauch, und die phasensauerei die dabei entsteht ist ja absicht weil sie in der natur auch so wäre.

scheiß auf HOA :P jetzt wo es das alles als external gibt, braucht man das eh nicht mehr selbst machen.

- ich hab mal extensions drangehängt falls du winblows bläst.

- das helpfile musst du manuell öffnen und als json.maxhelp exportieren, damit es dann auch automatisch öffnet, als v4 tut es das nicht.

- werte kleiner als "equal power" weighting sind eigentlich quatsch, keine ahnung was ich mir vor 15 jahren dabei gedacht habe. [zmap 0. 1. 0.2512 0.] is your friend.

- "interpolation" ist nur ein halbgares gimmick (als alternative dazu, gleich alles in signal zu machen, was sehr, sehr teuer wird). springst du damit langsam von einem punkt zu einem anderen, würde die bewegung (nur als) ein segment(!) in dem als kreis gedachter speaker-anordnung beschreiben.