G

GegenKlang

Fehlermacher

Hallo,

imeine Lieblingsart mir Dinge anzueignen ist die umständliche, nämlich das Rad neu zu erfinden, und dann sich fragen, ob ich das Ding "Dar" nenne oder "Bumsdings". Erst Theorie anlesen, sich ein bisschen von anderen Projekten inspirieren, dann Ärmel hochkrempeln, tüfteln, sich über die absurdesten Probleme die Haare ausreißen, sie idealerweise lösen und irgendwann stolz davor stehen mit der Gewissheit was neues erfunden zu haben, dann irgendwann erkennen, dass das gar nicht so neu ist, was man eher hätte sehen können, wenn ich ein bisschen mehr hätte von anderen Projekten inspirieren lassen, aber nein, dazu hat der Herr ja keine Zeit, muss man sich halt von anderen bloßstellen lassen, aber jeder braucht seinen Kick.

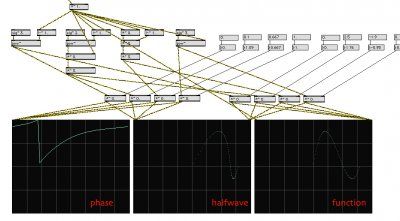

Wie auch immer, soweit bin ich noch nicht. Ich baue gerade noch was selber, einen "Text to Sound&Music"-Synthesizer mit einer eigenen Audiodefinitionssprache, und überlege dann, wie ich das Kind nennen soll, oder Teile davon, ich meine, ob das da noch ein "Bein" ist oder das schon eher in Richtung "Tentakel" geht. Also, nur mal um die Art meines Problems zu skizzieren.

Also ...

Ein Sympartial sei grob zusammengefasst eine Komponente eines komplexen Tons/Klangs, ist aber ne Ordnung höher als ein Harmonischer oder ein Teilton und sollte daher einen eigenen Begriff haben. Wie aber auch einem Teilton wird in der additiven Synthese der Komponente ein Faktor der Sollfrequenz zugewiesen sowie eine relative Maximalamplitude, wie das eben bei der AS so üblich ist. Das sind die "äußeren Eigenschaften", wie man sie mit der Wald-und-Wiesen-DFT ermitteln kann.

Der Sympartial hat aber auch Eigenschaften, bei der die DFT nicht weiterhilft, die Ergebnisse verfälscht und auch Wavelets zu ungenau sind, als sie irgendwas erhellendes aus ihnen ableiten ließen.

"Sympartial" halte ich für einen passablen Begriff. "syn" ist eine Vorsilbe gr. Ursprungs und bedeutet sowas wie "zusammen-", und Partial ist die Teiltonkomponente, der gleiche Begriff, wie er besonders in der Akustik des Klaviers und anderer perkussiver Instrumente verwendet werden, wo es keine Harmonische gibt. Ein Sympartial kann also eigenständig einen komplexen Klang hervorbringen, dem man wegen seiner relativen Statik allerdings immer einen synthetischen Ursprung nachweisen kann, er kann aber genauso gut ein einfacher Teilton sein.

Die Begriffskritik sei eröffnet. Hilft mir hoffentlich, halbwegs verständlich beschreiben zu können, vor anderen Leuten der Tonbranche, was ich hier mache.

imeine Lieblingsart mir Dinge anzueignen ist die umständliche, nämlich das Rad neu zu erfinden, und dann sich fragen, ob ich das Ding "Dar" nenne oder "Bumsdings". Erst Theorie anlesen, sich ein bisschen von anderen Projekten inspirieren, dann Ärmel hochkrempeln, tüfteln, sich über die absurdesten Probleme die Haare ausreißen, sie idealerweise lösen und irgendwann stolz davor stehen mit der Gewissheit was neues erfunden zu haben, dann irgendwann erkennen, dass das gar nicht so neu ist, was man eher hätte sehen können, wenn ich ein bisschen mehr hätte von anderen Projekten inspirieren lassen, aber nein, dazu hat der Herr ja keine Zeit, muss man sich halt von anderen bloßstellen lassen, aber jeder braucht seinen Kick.

Wie auch immer, soweit bin ich noch nicht. Ich baue gerade noch was selber, einen "Text to Sound&Music"-Synthesizer mit einer eigenen Audiodefinitionssprache, und überlege dann, wie ich das Kind nennen soll, oder Teile davon, ich meine, ob das da noch ein "Bein" ist oder das schon eher in Richtung "Tentakel" geht. Also, nur mal um die Art meines Problems zu skizzieren.

Also ...

Ein Sympartial sei grob zusammengefasst eine Komponente eines komplexen Tons/Klangs, ist aber ne Ordnung höher als ein Harmonischer oder ein Teilton und sollte daher einen eigenen Begriff haben. Wie aber auch einem Teilton wird in der additiven Synthese der Komponente ein Faktor der Sollfrequenz zugewiesen sowie eine relative Maximalamplitude, wie das eben bei der AS so üblich ist. Das sind die "äußeren Eigenschaften", wie man sie mit der Wald-und-Wiesen-DFT ermitteln kann.

Der Sympartial hat aber auch Eigenschaften, bei der die DFT nicht weiterhilft, die Ergebnisse verfälscht und auch Wavelets zu ungenau sind, als sie irgendwas erhellendes aus ihnen ableiten ließen.

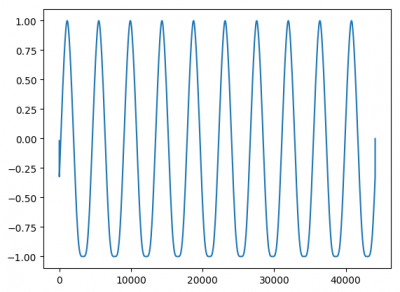

- Schwingweise, also im Prinzip Oszillatorprimitive, die auf einer einfachen mathematischen Formel beruht. Meistens Sinus, es gibt aber auch Sägezahn, Rechteck, Dreieck und ein paar zufallsbasierte für Geräusche. Meist ist es aber Sinus. Selbst bei der Geigenimitation benutze ich keine Sägezahnschwingung, weil ich dann die Klangfarbe nicht mehr so gut beeinflussen kann. In der Natur gibt es nur Sinus, die anderen Primitive sind nur Vereinfachungen.

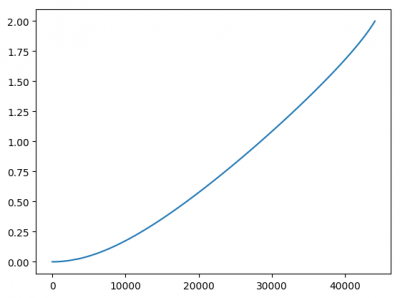

- Die "AS(B)R"-Hüllkurve, eigentlich eine Gruppe von mehreren unabhängigen Eigenschaften, die eine Attackphase, eine quasistationäre Schwingphase – oft betrachtet man den ersten Teil direkt im Anschluss nach den im Attack aufgebauten Maximum als Decay, der dann in den Sustain übergeht; da ich eh mit Bèzierkurven arbeite, die bei Bedarf auch scharfe Ecken unterstützen, ist eine solche begriffliche Trennung wenig sinnvoll –, und eine Releasephase umfasst. Außerdem gibt es zwischen Sustain- und Release noch eine optionale Boostphase, die hab ich mal programmiert in Vorausschau auf mögliche Sprachsynthesestudien, in dem ein Klang einer Silbe entspricht, aber bisher noch nicht getestet. Wenn also "ADSR" die üblichere Bezeichnung ist, meint das das gleiche, aber nicht dasselbe.

- Amplitudenmodulation, Modulationsfrequenz kann statisch sein oder sich auch linear zur Komponentenfrequenz verhalten

- Frequenzmodulation, ditto. Amplituden- und Frequenzmodulation haben viele vergleichbare Eigenschaften, denn sie basieren auf dem gleichen Prinzip.

- Waveshape, Bézierkurve auf der Projektionsebene, die orthogonal zur y-Achse der Trägerschwingung ist und die Faktorentwicklung zwischen ihrem positiven und negativen Amplitudenmaximum beschreibt. Filter in der subtraktiven Synthese basieren oft auf Waveshaping, wo es sich aber m.W. nicht um Bézierkurven, sondern um polygone Linienverläufe handelt.

- Frequenzvariation (Bézierkurve) fügt der äußeren Eigenschaft "Frequenzfaktor" Veränderlichkeit hinzu. Sollte sich im ein- bis niedrigeren zweistelligen Centbereich (1ct = 1/1200 einer Oktave auf der logarithmischen Skala) herum bewegen, je höher, desto wahrscheinlicher nimmt man Schwebungen oder gar verschiedene Töne wahr, und das beeinträchtigt den Wohlklang. Solche geringen Variationen, das verspreche ich mir davon jedenfalls, muss ich noch ausgiebiger testen, machen den Klang natürlicher. Stellt man sich den Klang räumlich schematisiert vor über die drei Achsen der Zeit, der Frequenzen und der Amplitude, so können sich sozusagen leicht "schräge" Verläufe in der Ebene ergeben, die von der Zeit- und der Frequenzachse aufgespannt wird.

"Sympartial" halte ich für einen passablen Begriff. "syn" ist eine Vorsilbe gr. Ursprungs und bedeutet sowas wie "zusammen-", und Partial ist die Teiltonkomponente, der gleiche Begriff, wie er besonders in der Akustik des Klaviers und anderer perkussiver Instrumente verwendet werden, wo es keine Harmonische gibt. Ein Sympartial kann also eigenständig einen komplexen Klang hervorbringen, dem man wegen seiner relativen Statik allerdings immer einen synthetischen Ursprung nachweisen kann, er kann aber genauso gut ein einfacher Teilton sein.

Die Begriffskritik sei eröffnet. Hilft mir hoffentlich, halbwegs verständlich beschreiben zu können, vor anderen Leuten der Tonbranche, was ich hier mache.