molemuc

maschinenlieber

bin sehr an Videos interessiert, habe oft diese Hardware Sachen angesehen,

aber ich bin da nicht drauf angesprungen. Teuer, oft kein HDMI und selber

löten mache ich eh nicht bei meinem chronischen Zeitmangel.

Auch die Software braucht Zeit und es ist im "Selbststudium" nicht

immer alles so schnell da wie es soll - und nach einem halben Jahr

fängt es wieder von vorne an.

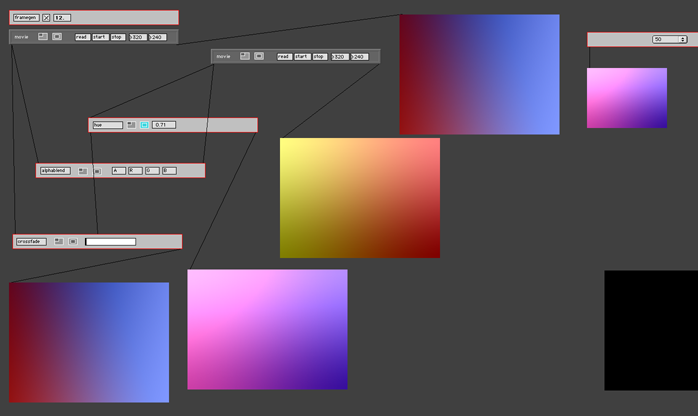

Habe es inzwischen geschafft mit vMix live Kameras in Magic als

Quelle einzubinden - im Magix dann live-bearbeiten und dann als Ausgang

wieder ins Vmix. Alles Software, und das ist schon nicht leicht.

zu wenig Zeit und mein letztes Werk setzt schon spinnweben an

weil nix nachkommt - weil immer wieder was neues ausprobiert wird.

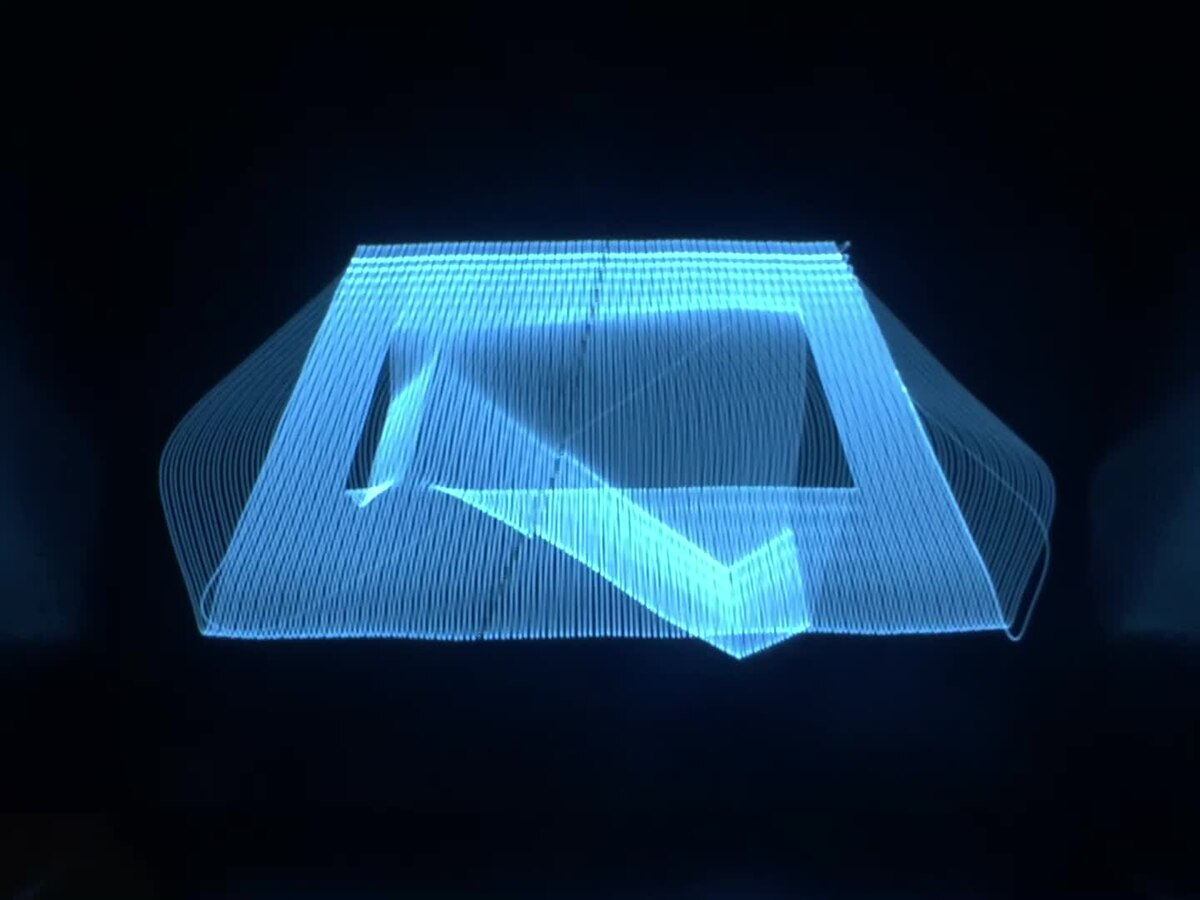

hier the last video - nicht live - sondern mühevoll nachbearbeitet:

https://youtu.be/fs4xM1cp4Cs

aber ich bin da nicht drauf angesprungen. Teuer, oft kein HDMI und selber

löten mache ich eh nicht bei meinem chronischen Zeitmangel.

Auch die Software braucht Zeit und es ist im "Selbststudium" nicht

immer alles so schnell da wie es soll - und nach einem halben Jahr

fängt es wieder von vorne an.

Habe es inzwischen geschafft mit vMix live Kameras in Magic als

Quelle einzubinden - im Magix dann live-bearbeiten und dann als Ausgang

wieder ins Vmix. Alles Software, und das ist schon nicht leicht.

zu wenig Zeit und mein letztes Werk setzt schon spinnweben an

weil nix nachkommt - weil immer wieder was neues ausprobiert wird.

hier the last video - nicht live - sondern mühevoll nachbearbeitet:

https://youtu.be/fs4xM1cp4Cs