G

GegenKlang

Fehlermacher

In diesem Thema geht es eigentlich nicht um Synthese, sondern um die Analyse. Wobei ähnlich wie bei der fourierbasierten Synthese/Analyse die beiden Richtungen eng zusammenhängen. Der Weg ist hier allerdings nicht einfach die mathematische Gegenrichtung, sondern über eine weite Strecke der gleiche.

Hab seit einiger Zeit an einem Werkzeug um die unterschiedlichen Aspekte von Klängen visuell darzustellen gearbeitet, für den Fall, dass ich ertaube oder wenn zeitweilig auf meine Ohren allein kein Verlass ist, letztens ist mir wieder mal mein linkes Ohr abgefallen (Hörsturz), ist zum Glück wieder dran dank Therapie mit Ohropax oder gleichwertigen Stöpseln und viel Wasser trinken. Wobei auch im gesunden Zustand meine Ohren nicht wirklich gut ausgebildet sind. Wer erst im Alter mit Klang- und Musiksynthese anfängt, dem entschuldigt, dass er im Zweifelsfall andere Sinne zur Rückversicherung benutzt.

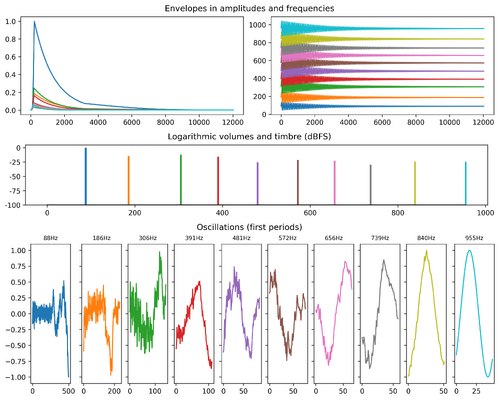

Zumindest diejenigen Klänge, die ich selber synthetisiere und von denen ich jeden dieser Aspekte unabhängig voneinander modellieren kann, da kann ich mich an einer bestimmten Stelle umentscheiden, dass ich die einzelnen Oszillationen und Hüllkurven nicht wie üblich in Audiosamples kulminieren lasse, sondern mit Matplotlib weiterverarbeite:

Hier ist das Audio dazu:

Anhang anzeigen 00189.snd.ogg

Dieser Klang wurde verwendet in meinem Beitrag zum Forumssong-Battle letztes Jahr, (für mich) genauer aus dem Log:

Audioaufnahmen, überhaupt Sounds aus anderen Quellen müssen weiterhin mit bisherigen, ungenauen Mitteln wie Spektrogrammen analysiert werden. Oder gibt es mittlerweile was in der Richtung auch für quellenagnostische Soundanalyse? Wenn ich die Theorie kapiert habe, ist das nicht möglich: Bei der mathematischen Modellierung von Klängen, die eine abstraktere Variante der physikalischen Modellierung ist, gehen im Laufe der Synthese zu viele Informationen verloren. Mehrere Layer gibt es nicht mehr, nur noch eine Reihe von Abtastwerten. In der Bildverarbeitung ist das ja auch so: Ebenen, die "nach unten" vereinigt sind, können nur noch gemeinsam als indifferenter Blob manipuliert werden

Hab seit einiger Zeit an einem Werkzeug um die unterschiedlichen Aspekte von Klängen visuell darzustellen gearbeitet, für den Fall, dass ich ertaube oder wenn zeitweilig auf meine Ohren allein kein Verlass ist, letztens ist mir wieder mal mein linkes Ohr abgefallen (Hörsturz), ist zum Glück wieder dran dank Therapie mit Ohropax oder gleichwertigen Stöpseln und viel Wasser trinken. Wobei auch im gesunden Zustand meine Ohren nicht wirklich gut ausgebildet sind. Wer erst im Alter mit Klang- und Musiksynthese anfängt, dem entschuldigt, dass er im Zweifelsfall andere Sinne zur Rückversicherung benutzt.

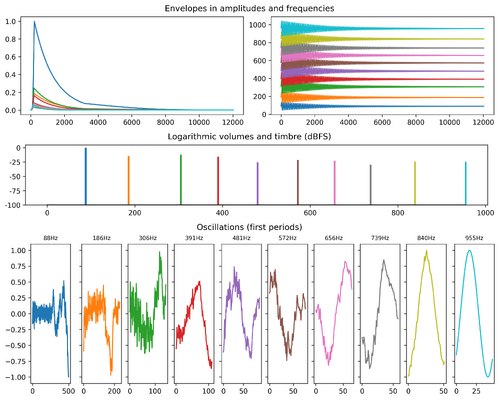

Zumindest diejenigen Klänge, die ich selber synthetisiere und von denen ich jeden dieser Aspekte unabhängig voneinander modellieren kann, da kann ich mich an einer bestimmten Stelle umentscheiden, dass ich die einzelnen Oszillationen und Hüllkurven nicht wie üblich in Audiosamples kulminieren lasse, sondern mit Matplotlib weiterverarbeite:

Hier ist das Audio dazu:

Anhang anzeigen 00189.snd.ogg

Dieser Klang wurde verwendet in meinem Beitrag zum Forumssong-Battle letztes Jahr, (für mich) genauer aus dem Log:

New note ... @0:09.12428... F#2+0k(22) ... Audioaufnahmen, überhaupt Sounds aus anderen Quellen müssen weiterhin mit bisherigen, ungenauen Mitteln wie Spektrogrammen analysiert werden. Oder gibt es mittlerweile was in der Richtung auch für quellenagnostische Soundanalyse? Wenn ich die Theorie kapiert habe, ist das nicht möglich: Bei der mathematischen Modellierung von Klängen, die eine abstraktere Variante der physikalischen Modellierung ist, gehen im Laufe der Synthese zu viele Informationen verloren. Mehrere Layer gibt es nicht mehr, nur noch eine Reihe von Abtastwerten. In der Bildverarbeitung ist das ja auch so: Ebenen, die "nach unten" vereinigt sind, können nur noch gemeinsam als indifferenter Blob manipuliert werden