nur hinten heraus perfekte Musik. Find ich absolut top, aber mir wird bei bestem Willen nicht klar, woher das immense Soundmaterial herkommt.

das ist eigentlich schon drei mal beantwortet worden, aber vielleicht nicht konkret genug.

KI automaten bestehen hauptsächlich aus einem relativ simplen mechanismus, der nichts weiter tut, als trainingmaterial danach zu analysieren wie hoch die übergangswahrscheinlichkeiten von einem wert zum nächsten sind.

nicht anders als die wikipediaartikel, die ein chatbot einst gelehrt bekam um daraus neue sätze zu basteln, was dir dann so vorkommt, als ob er denken und sprechen könnte...

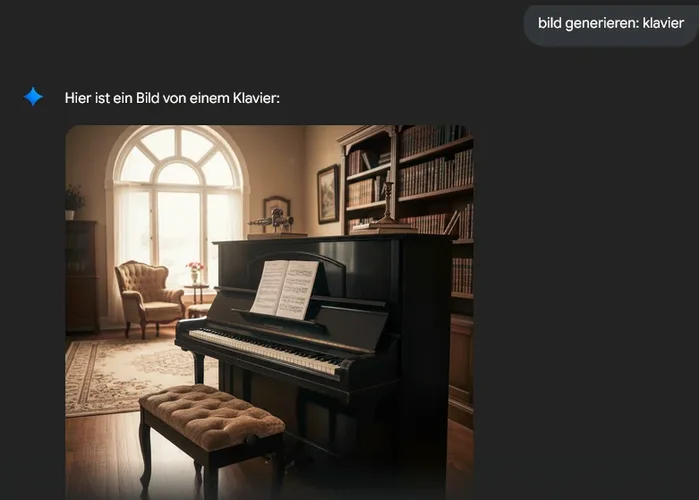

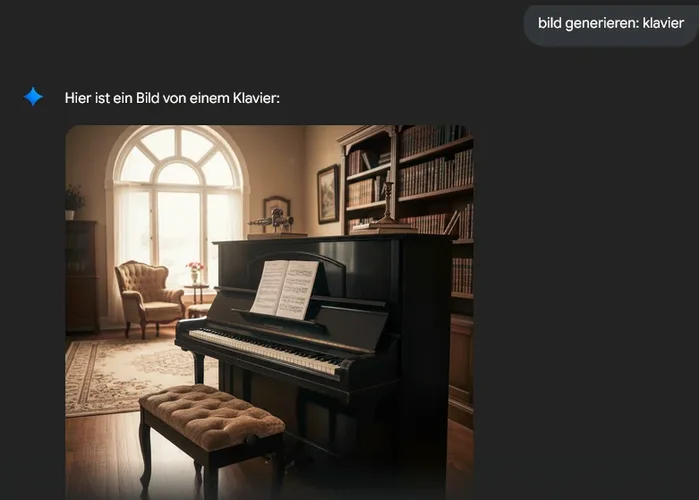

... oder ein bildgenerator, der 385,000 bilder von klavieren als futter bekam, und daher jetzt weiß, wie ein klavier aussieht und dass sie meistens in zimmern stehen und meistens fotographiert werden wenn die sonne scheint...

...weiß so ein KI automat eben auch wie ein klavier klingt, weil er zuvor tausende von samples von klavieren als futter bekam - und dazugesagt bekam (mit verschlagwortung durch klickarbeiter aus entwicklungsländern), dass es sich um sounds von klavieren handelt.

ein klaviersample besteht wie alle anderen dateien aus nichts weiter als einer reihe von binären werten, die man auch hexadezimal oder dezimal oder als buchstaben decodieren könnte, und im falle von text oder audio ist das auch tatsächlich nur eine eindimensionale reihe (während es bei bildern 2-dimensional ist und es bei finanzdaten mehrdimensional wird)

ein sampler nimmt einen klaviersound auf, der z.b. aus den werten 0.4 0.5 0.9 -0.1 0.0 -0.7 besteht, und gibt den dann so wieder. wie er reinkam.

ein KI automat bekommt 30000 verschiedene samples gefüttert, und dazu gesagt "das ist ein klavier".

wenn dann jemand darum bittet "klavier" zu erzeugen, dann stehen in der "datenbank" der KI alle diese daten in form von übergangswahrscheinlichkeiten zur verfügung, und die werden dann, sagen wir mal vereinfacht, zufällig ausgelesen, wobei für die eingabe "klavier" der weg durch das netz ein anderer ist wie für die eingabe von "klafünf".

der output ist dann tendenziell so ungefähr der durchschnitt der samplewerte aller input samples und das wird dann von dir wieder als klaviersound wahrgenommen, obwohl es aktuell immer noch ein paar fehler enthalten kann.

es ist nur die halbe warhheit, aber um dir ein grobes bild zu machen schau dir mal an, wie ein simple markov kette funktioniert (wie sie manche komponisten schon seit den achtzigern für midi verwenden)

en.wikipedia.org

der einzige teil der daran schwierig zu verstehen ist sind nur die auswirkungen der tatsache, dass heutzutage die datenmenge und die rechengeschwindigkeit so irrsinnig hoch sind, dass man sich das nicht mehr vorstellen kann.

DU erkennst ja auch, dass auf dem bild oben ein klavier ist, nicht wahr? und? kannst du auch erklären WIE du das erkennst? siehst du, und bei KI ist das genauso.