ikonoklast

|||||

Vorstellung der App bei ROLLING STONE:

www.rollingstone.com

www.rollingstone.com

Auszug (übersetzt):

"„I’m just a soul trapped in this circuitry.“ Die Stimme, die diese Texte singt, ist rau und klagend und taucht in blue notes ein. Dahinter tuckert eine einsame Akustikgitarre, die die Gesangsphrasen mit geschmackvollen Läufen untermalt. Aber hinter der Stimme steckt kein Mensch, keine Hände an der Gitarre. Tatsächlich gibt es keine Gitarre. Innerhalb von 15 Sekunden wurde dieser glaubwürdige, sogar bewegende Blues-Song vom neuesten KI-Modell eines Startups namens Suno generiert. Alles, was es brauchte, um es aus der Leere zu beschwören, war eine einfache Textaufforderung: „Solo-Akustik-Mississippi-Delta-Blues über eine traurige KI.“ Um ganz genau zu sein, ist das Lied das Werk zweier KI-Modelle in Zusammenarbeit: Sunos Modell erstellt die gesamte Musik selbst, während es ChatGPT von OpenAI aufruft, um den Text und sogar einen Titel zu generieren: „Soul of the Machine“."

Website: https://www.suno.ai/

Unter https://app.suno.ai/ kann man sich ein paar Beispiele anhören, und ich muss sagen dass ich sehr sehr überrascht bin. So ziemlich alles davon ist mainstream-radio-tauglich (IMO). Mein Favorit ist "LAND of FUZZY FACE":

"groovy 60s rock, flower power, super riff, Hendrix fuzz guitar, lo fi vocals, experimental, generetic"

app.suno.ai

app.suno.ai

Das ist extrem überzeugend (für mich jedenfalls), und das Gitarrensolo am Schluss ist ein Hammer.

NIE IM LEBEN würde ich wenn ich sowas im Radio höre darauf kommen dass das generiert ist.

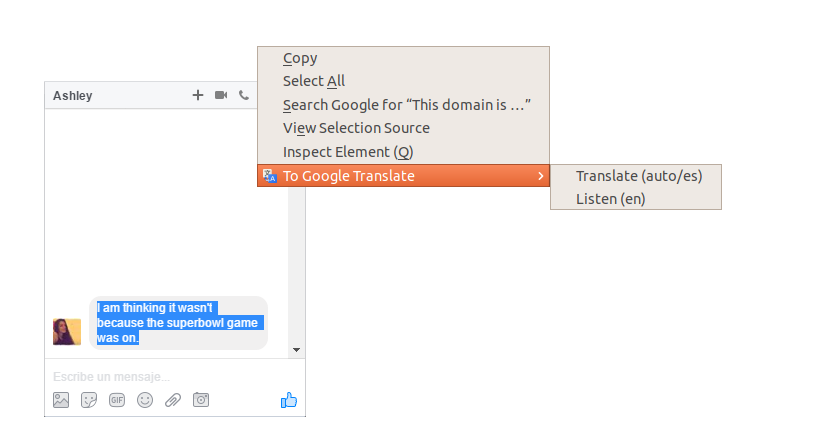

BTW: Wegen der Übersetzungen kann ich ein Firefox-Addon empfehlen: "To Google Translate"

Diese Erweiterung erweitert das Kontextmenü (rechtsklick) in Firefox. Wenn man auf den entsprechenden Menüpunkt klickt, wird der zuvor ausgewählte Text zur Übersetzung an Google Translate gesendet. Oder man wählt nichts aus und sendet die gesamte Seite an Google Translate.

addons.mozilla.org

addons.mozilla.org

A ChatGPT for Music Is Here. Inside Suno, the Startup Changing Everything

Suno AI wants everyone to be able to produce their own pro-level songs with artificial intelligence — but what does that mean for artists?

Auszug (übersetzt):

"„I’m just a soul trapped in this circuitry.“ Die Stimme, die diese Texte singt, ist rau und klagend und taucht in blue notes ein. Dahinter tuckert eine einsame Akustikgitarre, die die Gesangsphrasen mit geschmackvollen Läufen untermalt. Aber hinter der Stimme steckt kein Mensch, keine Hände an der Gitarre. Tatsächlich gibt es keine Gitarre. Innerhalb von 15 Sekunden wurde dieser glaubwürdige, sogar bewegende Blues-Song vom neuesten KI-Modell eines Startups namens Suno generiert. Alles, was es brauchte, um es aus der Leere zu beschwören, war eine einfache Textaufforderung: „Solo-Akustik-Mississippi-Delta-Blues über eine traurige KI.“ Um ganz genau zu sein, ist das Lied das Werk zweier KI-Modelle in Zusammenarbeit: Sunos Modell erstellt die gesamte Musik selbst, während es ChatGPT von OpenAI aufruft, um den Text und sogar einen Titel zu generieren: „Soul of the Machine“."

Website: https://www.suno.ai/

Unter https://app.suno.ai/ kann man sich ein paar Beispiele anhören, und ich muss sagen dass ich sehr sehr überrascht bin. So ziemlich alles davon ist mainstream-radio-tauglich (IMO). Mein Favorit ist "LAND of FUZZY FACE":

"groovy 60s rock, flower power, super riff, Hendrix fuzz guitar, lo fi vocals, experimental, generetic"

** LAND of FUZZY FACE ** (amazing result) | Suno

groovy 60s rock, flower power, super riff, Hendrix fuzz guitar, lo fi vocals, experimental, generetic song. Listen and make your own with Suno.

Das ist extrem überzeugend (für mich jedenfalls), und das Gitarrensolo am Schluss ist ein Hammer.

NIE IM LEBEN würde ich wenn ich sowas im Radio höre darauf kommen dass das generiert ist.

BTW: Wegen der Übersetzungen kann ich ein Firefox-Addon empfehlen: "To Google Translate"

Diese Erweiterung erweitert das Kontextmenü (rechtsklick) in Firefox. Wenn man auf den entsprechenden Menüpunkt klickt, wird der zuvor ausgewählte Text zur Übersetzung an Google Translate gesendet. Oder man wählt nichts aus und sendet die gesamte Seite an Google Translate.

To Google Translate â Holen Sie sich diese Erweiterung für ð¦ Firefox (de)

Laden Sie To Google Translate für Firefox herunter. Klicke rechts auf einen Textbereich und anschlieÃend auf das Ãbersetzen-Icon daneben, um diesen zu übersetzen oder in deiner Sprache anzuhören.

Ja, ich weiss. Google. Mir wurscht. Das Plugin hat mein Leben viel einfacher gemacht. Und ob Google jetzt auch noch weiss was ich mir übersetzen lasse ... da kommts auch nicht mehr drauf an. Bombenbauanleitungen würde ich mir aber vielleicht doch nicht übersetzen lassen

Zuletzt bearbeitet: