M

mooncast

Guest

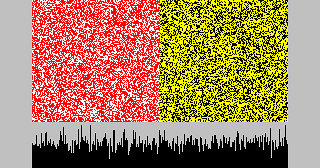

Der Algorithmus soll jeder natürlichen Zahl einen Zufallswert zuordnen

so dass die Folge natürlicher Zahlen quasi weisses Rauschen mit reproduzierbarer Sequenz ergibt.

Dabei ausgeschlossen sind rekursive Methoden, Listen und Methoden die auf modulo

durch Sättigung / Overflow basieren, als zB n * m + k ohne explizites Modulo geht nicht,

ein Lookup der Ziffernfolge einer transzendenten Zahl auch nicht.

Der Grund dafür ist dass es

1. plattformunabhängig sein muss und das nicht überall geht

2. maximal 3 Operationen brauchen soll

Die Folge beginnt mit 0, zusätzlicher Offest Seed ist denkbar aber muss ohne gehen,

der Grund ist dass es nacher möglich sein soll per Seed beliebig in die Folge zu springen.

Die Sequenz kann begrenzt sein dh sich wiederholen, sollte aber mindestens 2^16 Werte in Folge haben.

Ich habs mit xor shifts versucht aber das funktioniert damit offenbar nicht so gut,

wenn die Bits nicht gefüllt sind und man das nicht rekursiv anwendet...

Zufällige Binärfolgen gehen auch nicht, bzw nur zur Not.

hat jemand ne Idee?

so dass die Folge natürlicher Zahlen quasi weisses Rauschen mit reproduzierbarer Sequenz ergibt.

Dabei ausgeschlossen sind rekursive Methoden, Listen und Methoden die auf modulo

durch Sättigung / Overflow basieren, als zB n * m + k ohne explizites Modulo geht nicht,

ein Lookup der Ziffernfolge einer transzendenten Zahl auch nicht.

Der Grund dafür ist dass es

1. plattformunabhängig sein muss und das nicht überall geht

2. maximal 3 Operationen brauchen soll

Die Folge beginnt mit 0, zusätzlicher Offest Seed ist denkbar aber muss ohne gehen,

der Grund ist dass es nacher möglich sein soll per Seed beliebig in die Folge zu springen.

Die Sequenz kann begrenzt sein dh sich wiederholen, sollte aber mindestens 2^16 Werte in Folge haben.

Ich habs mit xor shifts versucht aber das funktioniert damit offenbar nicht so gut,

wenn die Bits nicht gefüllt sind und man das nicht rekursiv anwendet...

Zufällige Binärfolgen gehen auch nicht, bzw nur zur Not.

hat jemand ne Idee?