...so, dann höre ich mit dem fragen erst mal auf und trage stattdessen was bei.

ist zwar 15 jahre alt und nicht selbst erfunden, passt aber ganz gut hier dazu: der PAF.

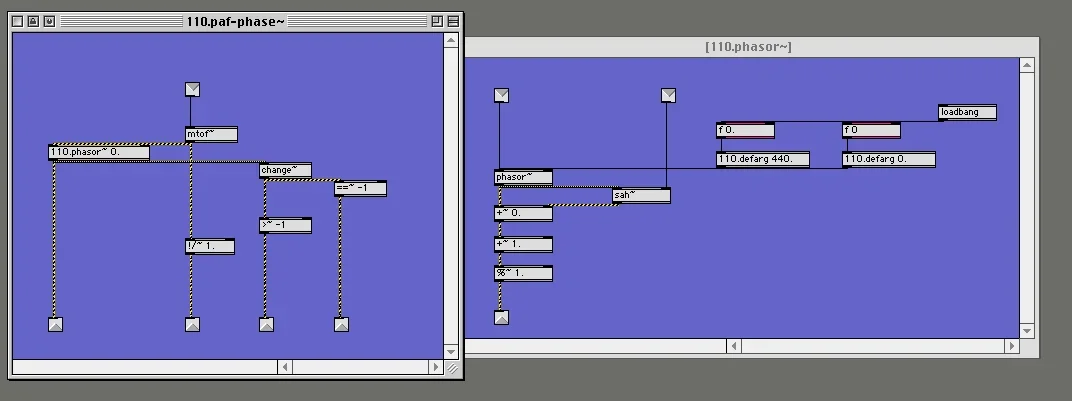

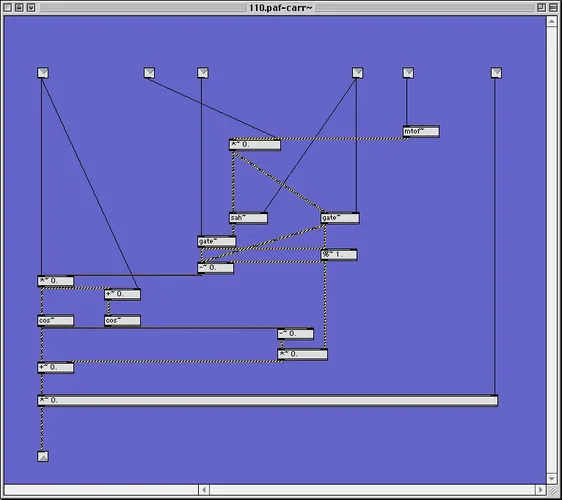

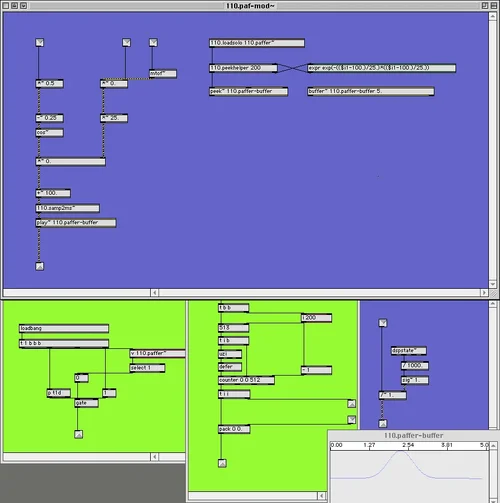

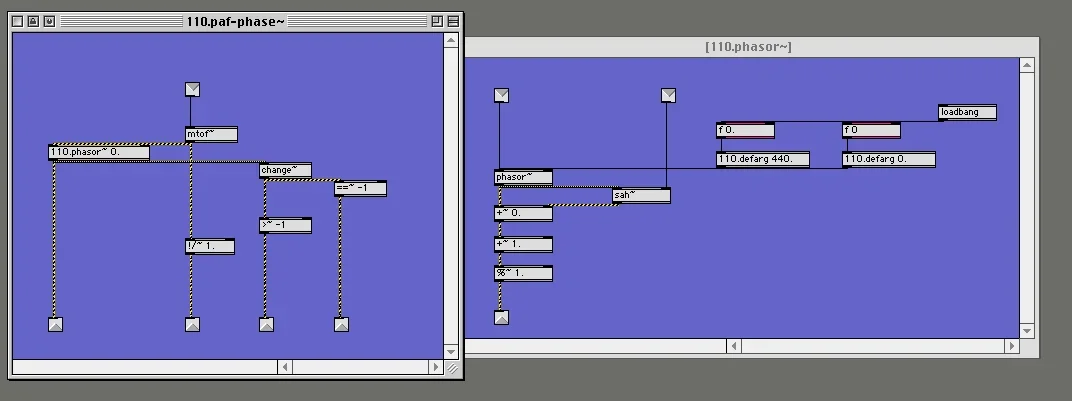

meine paf implementation basiert mehr oder weniger auf dem pd patch von miller puckette - für max musste aber leider das ein oder andere geändert werden - und außerdem habe ich das ding

modularisiert - das mache ich immer gerne mit allem, was das zulässt.

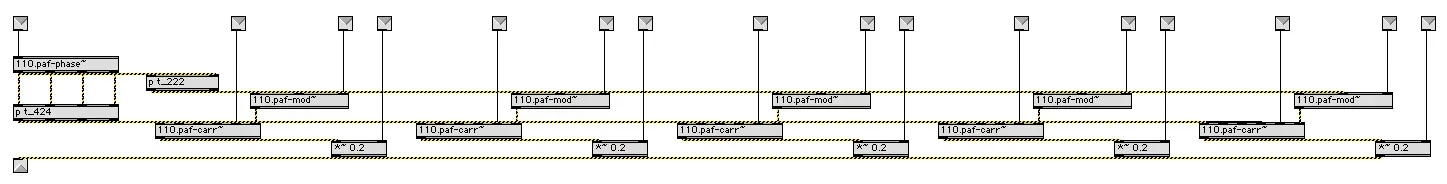

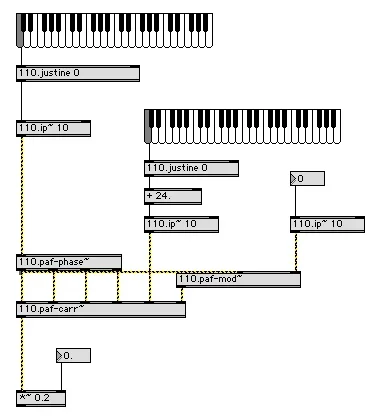

so besteht der paf generator jetzt aus 3 teilen, nämlich

dem

phasen akkumulator, der ein paar andere signale zusätzlich ausgibt, die später (mehrfach) woanders gebraucht werden

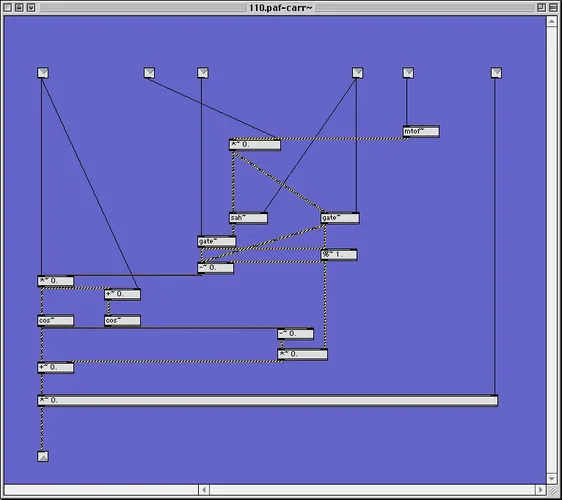

dem

carrier, der alles enthält, was

nicht für die erzeugung des formanten gebraucht wird

und dem

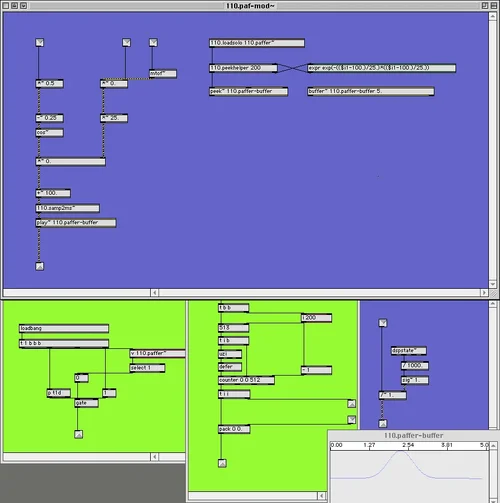

modulator, der für die bildung des formanten zuständig ist. nachdem ich diverse andere windows fürs waveshaping ausprobiert habe, bin ich zurück zur bell curve von miller gekommen. warum die am besten funktioniert ist mir allerdings ein rätsel.

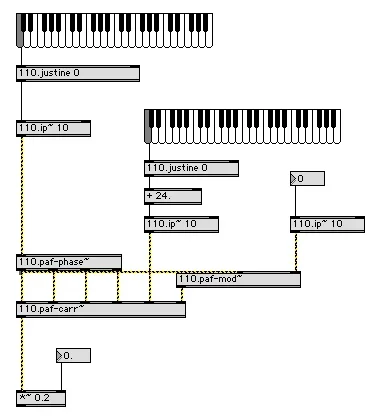

die einzelteile werden dann später so wie hier zusammengesetzt. die formanten, sofern man sie mit midi notenwerten anspielen will, sind typischerweise in reiner stimmung gestimmt, und der grundton nicht.

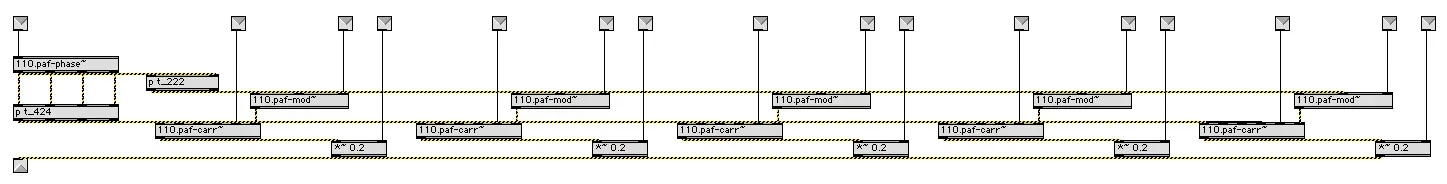

und natürlich hat die

modularisierung wie alles aus dem hause 110 einen grund: denn dadurch sparen wir jetzt ein bischen rechenarbeit, wenn wir mehrere formanten brauchen:

mit ~128 oder mehr formanten sind dann resyntheseverfahren damit möglich, so wie sie es einst an der ircam mithilfe teurer hardware gebaut hatten, und die sich von allen anderen dadurch unterscheiden, dass man mithilfe des

bandbreite parameters lustige abkürzungen finden kann.

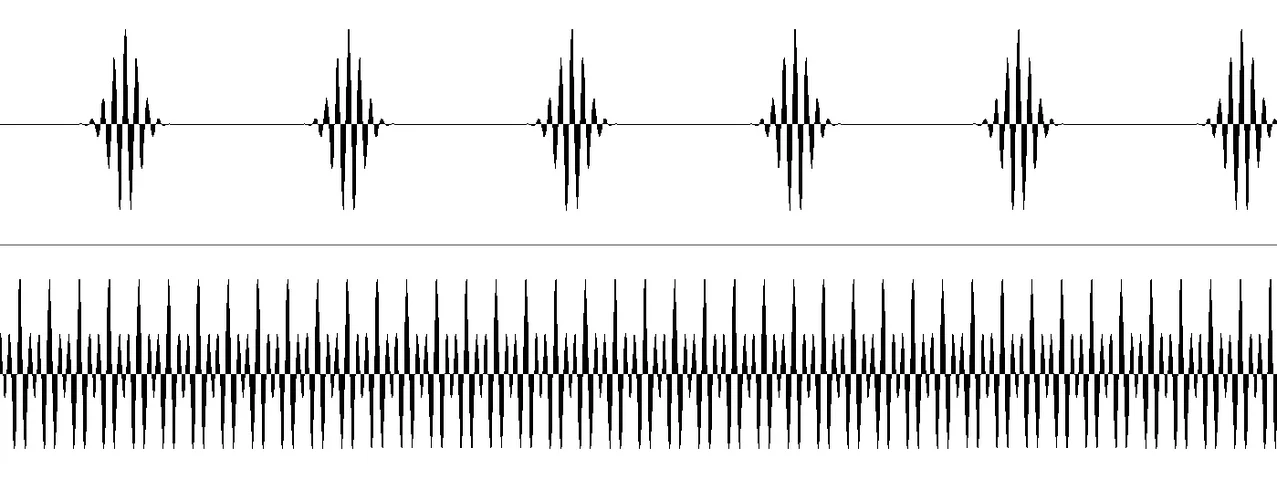

hörbeispiel 1 - erst der gleiche grundton mit sich bewegenden formanten, dann umgekehrt.

Anhang anzeigen paf01.MP3

hörbeispiel 2 - ein grundton mit 5 parallelen formanten

Anhang anzeigen paf2.MP3

hörbeispiel 3 - 5 formanten, alle bandbreiten ändern sich von 6 oktaven nach 1 oktave

Anhang anzeigen paf3.MP3

hörbeispiel 4 - eine kleine klickklak sequenz mit 10 attractors, die alle formantfrequenzen und bandbreiten modulieren.

Anhang anzeigen paf4.MP3