Hm, stimmt, Reactable hat, wie Knete, bleibende Positionen. Wie wär's mit Objekten entsprechend den Reactable-Pucks, die an je 3 schrägen Seilen hängen? Mit Aufwickelspulen, Zugkraftsensoren und Schrittmotoren können die Seile gerade eben gespannt und so das Objekt in Position gehalten werden, auch außerhalb in der Mittelachse. Alle 3 Wickel werden gebremst, sobald ich das Objekt loslasse, ausgelöst durch einen Berührungssensor. Schade, dass so nicht jedes beliebige Herumschieben geht, wenn man mehrere Objekte hat, denn irgendwann müssten sich dafür Seile kreuzen.MrAdmiral schrieb:3Dimensionalen Reactable ?

Mit so Luftdüsen oder irgendwas, die die Elemente in der Luft halten.So Siemens Lufthaken halt.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Wie muss ein Synthesizer eigentlich arbeiten?

- Ersteller Moogulator

- Erstellt am

Ja, und die Gesten dann in einem LiveLooper-Programm speichern und loopen.Zotterl schrieb:... kann man sehr lebendige Filterverlaeufe erstellen, ...

Brain-Interface ist vielleicht gar nicht so utopisch, es könnte etwa so gehen:

Wir nehmen 1. ein EEG-System ( z. B. ), 2. einen Synthese- bzw. Kompositionsalgorithmus mit viel "Eigenleben" und 3. einen Software-Lernmechanismus. Letzteren trainieren wir mit manuellen Zufriedenheitsmeldungen des Hörers und gleichzeitig(!) mit den EEG-Daten. Auf diese Weise erlernt das System, welche Hirnstrommuster und parallel dazu welche Kompositionsvorschriften mit "musikalisch positiv" zu assoziieren sind. Genauso lernt es auch "musikalisch negativ", später vielleicht sogar feinere Differenzierungen. Und wegen der genannten Gleichzeitigkeit lernt es indirekt auch die Querbeziehungen zwischen dem Hirnströmewissen und dem Kompositionswissen. Nach erfolgtem Training koppelt man diese zwei parallel trainierten Teilsysteme, und von da an macht das Ding automatisch die Wunschmusik unseres verdrahteten Hörers. Wobei Live-Weitertrainieren nicht ausgeschlossen ist.

Dann verkoppeln wir die Lernmechanismen verschiedener Benutzer online als Soziales Netzwerk...

Keine Musiker mehr nötig, keine Komponisten, auch deren Lehrer nicht mehr. Und auch das Verständnis von Musik und wie man sie macht, können wir dann wegschmeißen, denn die Welt-Musikmaschine beherrscht das ja, und die hat auch nichts verstanden... ups! ;)

Wir nehmen 1. ein EEG-System ( z. B. ), 2. einen Synthese- bzw. Kompositionsalgorithmus mit viel "Eigenleben" und 3. einen Software-Lernmechanismus. Letzteren trainieren wir mit manuellen Zufriedenheitsmeldungen des Hörers und gleichzeitig(!) mit den EEG-Daten. Auf diese Weise erlernt das System, welche Hirnstrommuster und parallel dazu welche Kompositionsvorschriften mit "musikalisch positiv" zu assoziieren sind. Genauso lernt es auch "musikalisch negativ", später vielleicht sogar feinere Differenzierungen. Und wegen der genannten Gleichzeitigkeit lernt es indirekt auch die Querbeziehungen zwischen dem Hirnströmewissen und dem Kompositionswissen. Nach erfolgtem Training koppelt man diese zwei parallel trainierten Teilsysteme, und von da an macht das Ding automatisch die Wunschmusik unseres verdrahteten Hörers. Wobei Live-Weitertrainieren nicht ausgeschlossen ist.

Dann verkoppeln wir die Lernmechanismen verschiedener Benutzer online als Soziales Netzwerk...

Keine Musiker mehr nötig, keine Komponisten, auch deren Lehrer nicht mehr. Und auch das Verständnis von Musik und wie man sie macht, können wir dann wegschmeißen, denn die Welt-Musikmaschine beherrscht das ja, und die hat auch nichts verstanden... ups! ;)

blumenhofen

..

Ja, kann ich 100% bestätigen.qrx schrieb:in der Luft rumfuchteln ist ergonomisch kacke

ich schraub so lange an sounds rum, da fallen mir die arme ab bevor ich da bin was ich hören wollte

sowas gibt immer tolle 3 Minuten demos, sieht cool aus, in der praxis aber nur für Kleinigkeiten wirklich zu gebrachen

Hab schon mal überlegt, meine Arme in Stoffschlaufen zu hängen, von denen ein Seil zur Decke, über eine Rolle, zu einem Gegengewicht geht. -- schweb --

DanReed

|||||

Geht auch anders:Jens Groh schrieb:Hab schon mal überlegt, meine Arme in Stoffschlaufen zu hängen, von denen ein Seil zur Decke, über eine Rolle, zu einem Gegengewicht geht. -- schweb --

Auch interessant,währe eine Synthesizer Variante vom ARCADE Emulator MAME!

http://www.mameworld.info/

Sowas würde Plugins obsolet machen und die Exakte Emulation hätte den Vorteil,das man seine Synthesizer-Schätzchen platzsparend,softwaremäßig lagern und horten kann!

Durch Hacks könnte man dann z.B. einem emulierten "Roland Jupiter-8" 16 oder mehr Stimmen verpassen,je nachdem wie viel der Rechner packt!

Auch könnte so mancher sich aus Geld und oder Platzgründen,eher von seinem geliebten Wegbegleiter trennen,da er ihn ja immer noch als Exakte Emulation spielen kann!

Verschiedene Möglichkeiten der grafischen Darstellung währen möglich und auch Hacks wie gesagt,die soundtechnisch Sachen machbar werden lassen,würden den Reiz am Soundschrauben dieser Emulationen den althergebrachten VSTs den Rang ablaufen!

Und ich glaube das dies sogar heutzutage möglich währe,da ein Arcade-Automat und ein Synthesizer im Grunde ein und das selbe sind,Elektronische Bauteile die Emuliert werden!

Hexenwerk währe das bestimmt nicht!

Nur müsste man fähige Leute finden die was davon verstehen!

Dazu am besten noch einen Hardware Controller,mit Keyboard und vieeeelenen Knöpfen zum rumschrauben (Statt Joystick wie beim MAME),damit auch die Haptik nicht zu kurz kommt und das Schrauben Spaß macht!

Oder ne Hardware dazu entwickeln,wo man dann die Emulationen wie beim Aira System 1 einlädt,aber so viele wie man will und nicht nur einen!

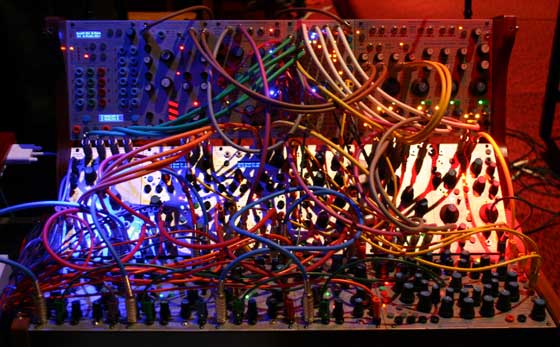

So könnte man auch Euroracks oder Ähnliches abspeicherbar Emulieren,nix mehr mit Foto der Verkabelung machen,oder schnell aufnehmen den Sound,der sonst verloren währe nach der nächsten Session!

Das würde den Sammeltrieb,der in uns Männern schlummert,extrem befriedigen!

AMEN!

http://www.mameworld.info/

Sowas würde Plugins obsolet machen und die Exakte Emulation hätte den Vorteil,das man seine Synthesizer-Schätzchen platzsparend,softwaremäßig lagern und horten kann!

Durch Hacks könnte man dann z.B. einem emulierten "Roland Jupiter-8" 16 oder mehr Stimmen verpassen,je nachdem wie viel der Rechner packt!

Auch könnte so mancher sich aus Geld und oder Platzgründen,eher von seinem geliebten Wegbegleiter trennen,da er ihn ja immer noch als Exakte Emulation spielen kann!

Verschiedene Möglichkeiten der grafischen Darstellung währen möglich und auch Hacks wie gesagt,die soundtechnisch Sachen machbar werden lassen,würden den Reiz am Soundschrauben dieser Emulationen den althergebrachten VSTs den Rang ablaufen!

Und ich glaube das dies sogar heutzutage möglich währe,da ein Arcade-Automat und ein Synthesizer im Grunde ein und das selbe sind,Elektronische Bauteile die Emuliert werden!

Hexenwerk währe das bestimmt nicht!

Nur müsste man fähige Leute finden die was davon verstehen!

Dazu am besten noch einen Hardware Controller,mit Keyboard und vieeeelenen Knöpfen zum rumschrauben (Statt Joystick wie beim MAME),damit auch die Haptik nicht zu kurz kommt und das Schrauben Spaß macht!

Oder ne Hardware dazu entwickeln,wo man dann die Emulationen wie beim Aira System 1 einlädt,aber so viele wie man will und nicht nur einen!

So könnte man auch Euroracks oder Ähnliches abspeicherbar Emulieren,nix mehr mit Foto der Verkabelung machen,oder schnell aufnehmen den Sound,der sonst verloren währe nach der nächsten Session!

Das würde den Sammeltrieb,der in uns Männern schlummert,extrem befriedigen!

AMEN!

Moogulator

Admin

Klingt komisch, aber sowas wie Reaktable ist für mich eher eine Show und bessere Musikbox, aber kein Instrument, dafür fehlen einige Möglichkeiten, die es dazu machen. Das ist übrigens nicht "gegen" das Ding, aber es ist bestimmt genau deshalb noch nicht so richtig überall im Einsatz.

Aber mein Ziel ist sicher auch nicht Emulation - nur guter Klang - das ist schon sehr wichtig.

MAME ist Spiel - nicht Musik oder Instrument, obwohl ich das mag, ist ja quasi Kindheit™ mit Power-Knopf.

Aber mein Ziel ist sicher auch nicht Emulation - nur guter Klang - das ist schon sehr wichtig.

MAME ist Spiel - nicht Musik oder Instrument, obwohl ich das mag, ist ja quasi Kindheit™ mit Power-Knopf.

Moogulator

Admin

Zotterl schrieb:Der Cube kann natürlich auch im Huellkurvenmodus sein, so das man

komplexe EGs kreieren und snapshotten kann.

Im Filtermodus - der natürlich weit über das normale Cutoffzeugs hinaus

geht - kann man sehr lebendige Filterverlaeufe erstellen, oder je nach

Rechnerleistung livefiltern.

Das wäre mir zu wirr, ich stehe total auf klare Konzepte die absehbar sein, nur dann kann man gezielt Musik damit machen. Das wäre hier nicht gegeben.

Keine Sorge, ich kann keine Synths bauen, außer Tyrell hab ich noch nichts direkt gemacht und gecodet hat ihn ja Urs. Das soll hier ja eher helfen, dass die uns unsere Wünsche ablesen lernen, damit die wissen was nach Vintage und Co kommt.

Moogulator

Admin

blumenhofen schrieb:Was ich mir wünschen würde ist ein Synth der die Sounds durch sample eingang erstellt. Also nehmen wir an mir gefällt in einem Lied ein Sound gut sampelt man das ab. Nun wird aber nicht das Sample verwendet sondert es wird ein richtiger Synthsound errechnet. Also nicht auf Samplebasis.

Das hier wäre so eine Idee, die man als Hersteller angehen könnte. Nicht leicht, aber machbar, man muss andere Sachen ausrechnen (Hihats oder sowas und Stimmen) und dann den Klang verstehen und neu synthetisieren.

Nächster Schritt dann: Diesen Sound mehr noch so zu machen wie er ist, also zu übertreiben und dann Anfasser zu machen, die den entsprechend formen. Auch und gerade mit Samples, eigentlich hat der Neuron sowas lt. Werbung sein können oder wollen, war aber was anderes. Total anders.

Der Lernmechanismus von oben könnte dann den Sound so übersetzen, dass jemand der sagt - DER Sound ist doch nicht aggressiv, DAS ist aggressiv - rüberreich..

Wenn diese Systeme wissen was für wen "aggressiv" ist könnte der dieses ggf. optimieren für diese Person.

Bei Tastaturen brauche ich keine fancy-Cubes sondern einfach nur die Fläche ist der Controller - Tasten haben schonmal eine Länge und eine Breite, also 2 Dimensionen. Evo hat das weitgehend schon mal verstanden und eine der Dimensionen genutzt. Auf dem iPad wird das auch gemacht, auf großen Tasten kann man das auch mit rechts-links machen, nach Anschlag zB. das könnte man ja einstellen.

ANSONSTEN könnte man natürlich sich auch von Tasten verabschieden, Haken und Co.. Roli.

Oder ganz anders.

Horn

*****

Ich finde die kreativen Ideen hier sehr interessant. Für mich selbst möchte ich allerdings sagen, dass ich mir eigentlich nur qualitativ hochwertigere und umfassendere Varianten dessen wünsche, was es schon gibt. Ein Synthesizer ist für mich ein Tasteninstrument mit Mod- und Pitchwheel und einer vernünftigen Fullsize-Tastatur mit Aftertouch. (Schon daran hapert es ja sehr oft.) Die grundsätzliche Klangerzeugung ist subtraktiv. Wavetables, FM und Samples können dieses Konzept sinnvoll ergänzen.

Ein guter Synth hat aus meiner Sicht eine WYSIWYG-Oberfläche mit mechanischen Bedienelementen und Manual Mode, aber auch Preset-Speicher und MIDI - sowie idealerweise auch noch CV-In- und Outputs.

Ich wüsste keinen Synthesizer, der wirklich konsequent alle diese Dinge vereint bisher.

Ein guter Synth hat aus meiner Sicht eine WYSIWYG-Oberfläche mit mechanischen Bedienelementen und Manual Mode, aber auch Preset-Speicher und MIDI - sowie idealerweise auch noch CV-In- und Outputs.

Ich wüsste keinen Synthesizer, der wirklich konsequent alle diese Dinge vereint bisher.

Tja, nicht? Die sind selber schuld, wenn sie meinen, jeder wolle nur ihre Show-Software. Anstatt dass sie einen Simulator und ein API für ihre Hardware öffentlich machen, wiederholen sie bloß aufm iPad dieselbe Show, die eh keiner mehr sehen mag.Moogulator schrieb:Klingt komisch, aber sowas wie Reaktable ist für mich eher eine Show und bessere Musikbox, aber kein Instrument, dafür fehlen einige Möglichkeiten, die es dazu machen. Das ist übrigens nicht "gegen" das Ding, aber es ist bestimmt genau deshalb noch nicht so richtig überall im Einsatz.

ItsTheSoftwareStupid™ ;)

Geht nicht. Das wird wohl öfters missverstanden. Solche Ideen, die hier gepostet wurden, sind in dem Moment veröffentlicht und damit "bekannt", gemäß Gesetz sind sie damit nicht mehr patentierbar. Wenn einer es doch anzumelden versucht: kleiner Tipp ans Patentamt, und die lehnen den Antrag ab, garantiert! (Nur ne Info, deinen Smiley hab ich gesehen)Mork from Ork schrieb:Wohin will der liebe Moogulator,mit all dem Input,doch nicht etwa zum Patentamt!

... ich übersetz mal für die anderen: man muss die Klangkomponenten trennen, also perkussive und tonale, ...Moogulator schrieb:Das hier wäre so eine Idee, die man als Hersteller angehen könnte. Nicht leicht, aber machbar, man muss andere Sachen ausrechnen (Hihats oder sowas und Stimmen)blumenhofen schrieb:[...] nicht das Sample verwendet sondert es wird ein richtiger Synthsound errechnet. [...]

Moogulator schrieb:und dann den Klang verstehen und neu synthetisieren.

Nächster Schritt dann: Diesen Sound mehr noch so zu machen wie er ist, also zu übertreiben und dann Anfasser zu machen, die den entsprechend formen. Auch und gerade mit Samples [...]

Jep, so war das "noch differenzierter" gemeint. Geht aber über meinen Gedanken von vorhin noch hinaus. Es würde voraussetzen, dass der Lern-Algo auch "hört". (War das überhaupt aufgefallen, dass der KEINEN Audio-Eingang braucht? Einzig der Hörer hätte einen.) Der Knackpunkt ist also bei deiner Idee das "den Klang verstehen". Sehr schwierig.Moogulator schrieb:Der Lernmechanismus von oben könnte dann den Sound so übersetzen, dass jemand der sagt - DER Sound ist doch nicht aggressiv, DAS ist aggressiv - rüberreich..

Wenn diese Systeme wissen was für wen "aggressiv" ist könnte der dieses ggf. optimieren für diese Person.

MrAdmiral

|||

Re: ?

Ja, fällt leider nicht unter "vergiss alles, was es gibt". ;) Mit Bidule kannst du VST's / VSTi's als Module für eigene Verschaltungen hernehmen. Uferlos, das.MrAdmiral schrieb:Gibts eigentlich ... ein Synth wo man VSt´s reinladen kann?

Moogulator

Admin

Für mich ist das ein schönes Show-Ding für eine Show und danach nicht mehr, weil es zu einem Album oder so als Konzept passt. Danach wieder "richtig" ;)Jens Groh schrieb:Tja, nicht? Die sind selber schuld, wenn sie meinen, jeder wolle nur ihre Show-Software. Anstatt dass sie einen Simulator und ein API für ihre Hardware öffentlich machen, wiederholen sie bloß aufm iPad dieselbe Show, die eh keiner mehr sehen mag.Moogulator schrieb:Klingt komisch, aber sowas wie Reaktable ist für mich eher eine Show und bessere Musikbox, aber kein Instrument, dafür fehlen einige Möglichkeiten, die es dazu machen. Das ist übrigens nicht "gegen" das Ding, aber es ist bestimmt genau deshalb noch nicht so richtig überall im Einsatz.

ItsTheSoftwareStupid™ ;)

Das ist für mich auch kein Instrument - nicht wirklich - denn es verbessert nichts - es ist nur ein optisches Ding für etwas, was man viel viel kompakter haben kann. Und ich bin keiner, der Neues ablehnt, eher im Gegenteil. Also naja..

Gleich weiter zum anderen Thema:

Lernmechanismus und Sounds synthetisieren aus Musik: So ein Projekt ist nicht leicht zu machen und der Gewinn dabei ist was den Output angeht relativ niedrig. Aber - es ist eine nette Idee die so einen großen Packen "social" mit drin hat.

Ja - den Klang verstehen ist das neue Ding, was diese Superengine können müsste. Mal rein semantisch, mal durch anhören aus einem Stück - zB "der Bass aus Abbas "Dancing Queen" bitte und die Hihats von Marvin Gaye - und zack hast du das - Shaaaazzzammm für Musiker. Das wäre natürlich "klauen" auf einem hohen Niveau. Das ist natürlich nicht meine Arbeitsweise.

Eine andere wäre - da aufhören wo Wavetables und Samples sowie Granular-Technik aufhören - man kann ein Sample beliebig durchfahren und freezen aber braucht weniger Daten, in Werbesprech heißt das - das Sample ist kein Sample sondern eine Reihe Algorithmen, die "das Klavier" aus machen und wissen wie das klingen muss - wenn man diese also spielt, kann der Synth das Klavier was du da geklaut hast oder aufgenommen hast verstehen und in allen Formen die das Ding drauf hat wiedergeben, die einfachste ist die das 1:1 zu erzeugen. Die komplexere ist das mit irgendwas zu mischen oder mit "aggressivität" von Paul Bein aus Köln zu interpretieren und dann für Gumbo Pfrobisch noch einmal, der hört nur Noise und Metal, weshalb sein Klavier auch weit rabiater ist und für Supernerds klingt es halt wie ein PPG, weil der das so will.

Das ist so wie wenn du 2 Sounds hast - Die Erde und den Mond. Wenn der Algo Mond und Erde wiedergeben kann und alle Morphs dazwischen ist das ok und "normal" aber wenn er auch mehr nach Mond klingen kann als der Mond selbst klingt - dann kann der was.

Wir hatten ja mal das Beispiel "Klospülung" als musikalischen Klang und dessen Anfasser beim Neuron. Da haben wir sowas wie einen Salat. Sag ich mal.

Ich hätte gern was ganz anderes. Wirklich nicht so sample-style.

Und auch eher wirklich Synthese und neu.

Aber - ich weiss nicht mal ob ich mir das vorstellen kann, wie das ist, da ich die Synthese die ich gern hätte nicht erfunden habe.

Psychotronic

||||||||||

Moogulator schrieb:"aggressivität" von Paul Bein aus Köln zu interpretieren und dann für Gumbo Pfrobisch noch einmal, der hört nur Noise und Metal, weshalb sein Klavier auch weit rabiater ist und für Supernerds klingt es halt wie ein PPG, weil der das so will.

Blutmond Massaker!

play:

Moogulator

Admin

Psychotronic

||||||||||

Moogulator schrieb:Nettes Klavier.

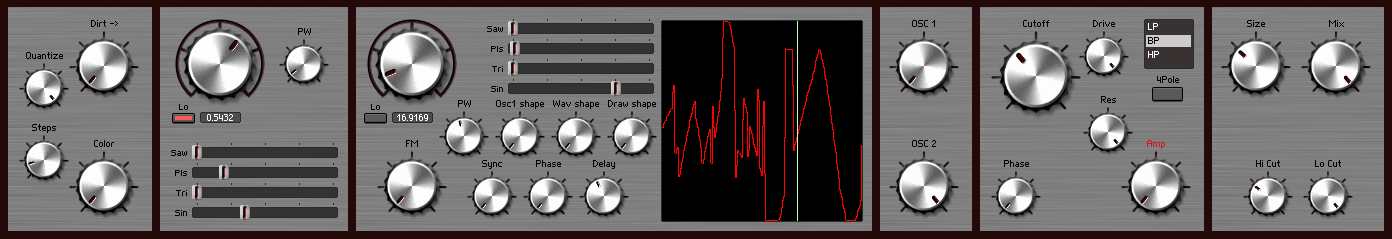

Noch isses keins. Das sind momentan nur 2 frei laufende miteinander verschaltbare OSCs(FM, Waveshaping), ne Filter Sektion und ein Reverb. Steuerung und Modulatoren muss ich noch dranbauen.

Cyborg

||

Jens Groh schrieb:Das Coole daran war: Auch wenn mit dem "Trick" jeder Dödel Baumrinde malen kann, beschränkt es doch nicht die Ausdrucksmöglichkeiten des erfahrenen Künstlers. Im Gegenteil, das nasse Papier und die Farbe haben ein "Eigenleben" und liefern Überraschungen, daraus entfalten sich jede Menge neue Gestaltungsideen. Wo der Pinsel hingesetzt wird, bleibt die individuelle Entscheidung, nur scheitert nicht mehr alles an mangelnder Körperbeherrschung.

umgesetzt auf "unsere" Instrumente bedeutet das in etwa: Das Instrumente ist kreativer als der Musiker, der drückt dann "AnyKey" nach freier Wahl, den Rest macht die Software.

Z

Zotterl

Guest

Halten wir fest: Hände, die sowieso zum Einsatz kommen = wirr (?)Moogulator schrieb:Das wäre mir zu wirr, ich stehe total auf...

oder doch eher sowas:

Der genannte Dödel, der "bloß noch einen Knopf drückt", macht nur demjenigen "Musiker" Konkurrenz, der sich bloß für seine Fingerfertigkeit bewundern lässt. Das fände ich in Ordnung, denn eine schöpferische Leistung bieten sowieso beide nicht.Cyborg schrieb:umgesetzt auf "unsere" Instrumente bedeutet das in etwa: Das Instrumente ist kreativer als der Musiker, der drückt dann "AnyKey" nach freier Wahl, den Rest macht die Software.

Ja, warum sollte nicht ein Instrument die Bewunderung verdienen? Oder sein Erbauer?

Letztlich denke ich, Musik braucht nicht Musiker, bloß weil sie immer von Musikern gemacht wurde. Und vielleicht kann man mit jenem lernenden System zeigen, dass sie auch nicht zwingend einen Komponisten braucht. Ohne einen Hörer aber geht es nicht. Und zwar einen musikalischen!

Kritik wird nicht ausbleiben, denn das stellt natürlich Herrschaftsverhältnisse auf den Kopf.

khz

||𝝞|𝝞||𝝞|𝝞|𝝞||

Ich hab lieber eine Maschine die ehrliche Musik komponiert,als "Milli Vanilli",die uns alle verarscht haben,Frank Farian mit eingeschlossen!

Und da wir ja die Maschine,gedanklich zumindest,hergestellt haben,ist ja das Menschliche in der Maschine erhalten geblieben,sie setzt nur um,was wir vorgesehen haben!

C-3PO als Mozart der Zukunf sozusagen!

Und da wir ja die Maschine,gedanklich zumindest,hergestellt haben,ist ja das Menschliche in der Maschine erhalten geblieben,sie setzt nur um,was wir vorgesehen haben!

C-3PO als Mozart der Zukunf sozusagen!

Ähnliche Themen

- Antworten

- 144

- Aufrufe

- 5K

- Antworten

- 47

- Aufrufe

- 2K

- Antworten

- 114

- Aufrufe

- 11K

- Antworten

- 2

- Aufrufe

- 2K

News

-

News Nativer Schrecken! - SequencerTalk 267 - Was nach der großen Flut passiert

- Gestartet von Moogulator

- Antworten: 2

-

News Morbid - 32 Tracks mit dem Ziel maximal morbid zu klingen…

- Gestartet von Moogulator

- Antworten: 0

-

2026-01-31 Düsseldorf Die Vierte Kränkung / Willi Sauter (Klangbau Köln)

- Gestartet von Moogulator

- Antworten: 0

-

-

News ASM Leviasynth - Neuer FM Synth mit 8 Operatoren, 2 Filtern, Bitimbral, hybrid

- Gestartet von Moogulator

- Antworten: 7

-

2026-01-17 Düsseldorf - Salon des Amateurs - Schulverweis / Event: Praes

- Gestartet von Moogulator

- Antworten: 0

-

App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.