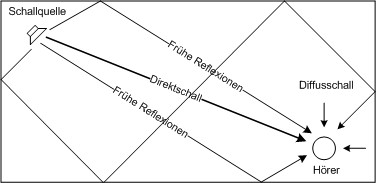

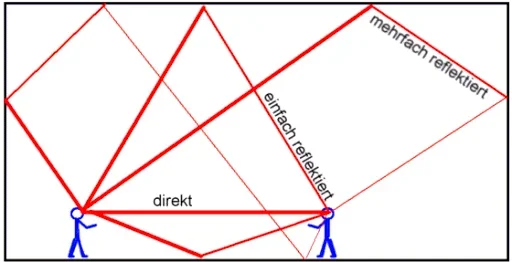

Die vollen Laufzeiten von Direktsignal und Early Reflections sind irrelevant fürs Ohr.

deine meinung dzau in allen ehren.

aber einige andere leute hingegen meinen, dass die erstreflektionen am relevantesten für den raumeindruck sind.

Das hat nichts mit Meinungen zu tun

Ich seh schon, du verwechselst hier massiv etwas.

Natürlich sind die ER ausschlaggebend, aber eben nur die

Differenz aus DS Laufzeit minus ER Laufzeit.

Ich kann mich da nur wiederholen - für den Hörer beginnt das Schallereignis erst, nachdem das Direktsignal bei ihm ankommt und nicht schon wenn es der Quelle entfleucht.

Alles was ab Eintreffen des DS zählt, ist dann noch die

restliche Laufzeit der ER aber die Laufzeit davor ist für den Höreindruck irrelevant, weil du die gar nicht wahrnehmen kannst.

(Wie auch, der Schall ist ja noch gar nicht angekommen.)

Das Schlüsselwort ist und bleibt hier

Laufzeit Differenz.

Wenn ein Hallgerät so wie du dir das vorstellst mit den vollen Laufzeiten rechnen würde, dann könntest du ein solches Effektgerät nur als Insert nutzen, weil die Verzögerung ja auch auf das trockene Signal mit aufgerechnet werden müsste.

Ein solcher Halleffekt ist mir bisher allerdings noch nicht begegnet. Kennst du denn einen Hall der so ausgelegt ist?

Wir nehmen da nur den zeitlichen Abstand zwischen Direktsignal und ER wahr.

zuzüglich der absorbtion der wände und der luft.

Für den Gesamteindruck magst du recht haben, aber für eine isolierte Betrachtung der Laufzeit ist das erstmal untergeordnet.

Ich gehe soweit mit dir konform, daß die Dämpfung durch die die Luft natürlich mit dem Moment beginnt, an dem das Signal die Quelle verlässt.

Auch möchte ich anmerken, daß die Dämpfung der hohen Frequenzen durch Luft und die Abnahme des Schalldruckpegel durch Entfernung zwei Paar unterschiedliche Schuhe sind.

Die Dämpfung durch die Wände wäre davon auch nochmal getrennt zu betrachten.

Das entscheidende Element ist hier das Direktsignal, bei dessen Eintreffen die Wahrnehmung erst beginnt.

ich denke du übersiehst, dass ein direktsignal nicht zwangläufig vorhanden sein muss.

Hä?

Wovon redst du denn jetzt?

Davon daß man den Direktsschall soweit dämpfen kann, bis man nur noch den Raumschall übrig hat?

Das machst mit dem Dry/Wet im Hall bei Einsatz als Insert FX.

Beim Einsatz als Send FX erreichst du das indem der Send Pre-Fader abgegiffen wird. Da ziehst du dann einfach den Kanalfader runter.

Aber was hat das bitte jetzt mit unserer Betrachtung der Laufzeiten zu tun?

Ja vielleicht eine Sache, nämlich daß dir dann die Referenz durch das Direktsignal fehlt und damit das DS inclusive dem Predelay für die Wahrnehmung bedeutungslos wird.

Genaugenommen fungiert dann die ER als neues Direktsignal, aber das sind schon wieder Nebenkriegsschauplätze die du hier aufmachst.

Du hast ja nicht unrecht, aber Gegenstand der Betrachtung war hier doch die Laufzeit des DS, was danach passiert ist ja nochmal eine andere Geschichte.

ich habe mich nur lustig darüber gemacht, dass flowdy die zeitliche verschiebung einer reflektion durch "dämpfung" erreichen wollte. wenn du das auch so siehst wie er, dann haben wir da ein problem und müssen das jetzt unbedingt ausdiskutieren.

Ja wiegesagt, ich weiß auch nicht wirklich, was er da so richtig will.

Bei wiederholtem Lesen der Posts von

@flowdy beschleicht mich nun aber der Eindruck, daß er sich da so ne Art Eimerketten Hall zusammenschraubt.

Wenn man jetzt also die Aussage leicht abwandelt, nämlich zu:

"...daß flowdy das Siganl nach jeder zeitlichen Verschiebung in den einzelnen Delaystufen seiner Eimerkette mit einer Dämpfung des Pegels versieht.",

dann macht die Aussage plötzlich wieder Sinn.

Aber solang er da nicht weiter ins Detail geht, ist das nur Scrabble spielen oder "Rate mal mit Rosenthal", was wir hier machen.

Fakt ist, wenn du einen Hall im Mixer einschleiftst, dann wird das Dry bzw Direktsignal nicht verzögert ausgegeben, das marschiert normalerweise schnurstracks hindurch.

ich weiß nicht ob das fakt ist. es fängt bei digitalen geräten schon mit der wandlung an, die da zwangsläufig latenzen erzeugt

Och menno, bitte nicht noch einen Nebenkriegsschauplatz eröffnen, noch dazu einen der überhaupt nichts zur Sache tut.

Evtl. Gerätelatenzen blenden wir hier mal aus, nimm einfach an wir nutzen den Latenzausgleich in der DAW und alles ist fein.

Bitte nicht alles in einen Topf werfen.

Die Verzögerungen gibts erst für die ER (in Form des Predelays) und danach dann in Form des jeweilige Hall Algos für die Late Reflections, also insgesamt nur für das Wet Signal.

es geht mir um was anderes, wenn ich das so sage.

du meintest ja man könne doch - so wie in den sechziger jahren mal - "tiefenstaffelung durch shelving filter" herstellen, und dann das gefilterte signal verhallen.

Das machte man nicht nur in den 50ern, heute funktioniert der Trick noch genauso.

Klar gibts dafür mittlerweile auch Plugins die das komplett übernehmen und in ihrer Funktionalität weit über einen Highshelf hinausgehen.

Beispielsweise Proximity von Tokyo Dawn Labs

A distance pan pot offering intuitive access to psychoacoustic models. Finalist of the KVR Developer Contest '12.

www.tokyodawn.net

Aber soweit will

@flowdy doch gar nicht gehen.

Er schreibt ja recht eindeutig, daß er auf eine spektrale Auswertung verzichten will, was mich zu der Erkenntniss gebracht hat, daß sein Modell im Grunde nur eine Art Eimerketten Hall darstellen kann.

Spektral orientierte Dämpfungen sind wie weiter oben gesagt nicht drin, sorry an wen auch immer. Wenn es nach bestem Bemühen immer noch sch... nach Toilette klingt, nach Kachelwänden, kann ich es also noch immer darauf schieben, in die Berge fahren und den Mond anheulen (echter Nachhall, krass!).

Seine Version einer "Implulsantwort" wenn man das so nennen möchte, wäre dann nix weiter als die Aneinanderreihung der jeweilgen Delayzeit + der jeweiligen Dämpfungsstärke für jeden Schritt seiner Eimerkette in Form einer Tabelle.

Das wäre dann eher das Equivalent zu nem steinzeitlichen Donnerkeil, was er da machen will.

@flowdy: interpretiere ich das richtig so, oder liege ich daneben?

es macht aber eigentlich keinen sinn, da du jetzt gar keine genaue kontrolle darüber hast, wie der absorbtionsfilter aussieht.

nimm an du wärst der allertollste und würdest auf zuruf hin sofort mit deinem mischpult eine distanz einer schallquelle von 200 metern herstellen können. und dann verhallst du das mit dem "drumroom" preset.

macht das sinn? ergibt das jetzt einen nachbildung eines natürlichen raumes? natürlich nicht.

deswegen ist es naheliegend, das gleich in den hallalgorithmus mit einzubauen bzw. das wenigstens zu beachten, dass das eine und das andere zusammenpassen müssen, wenn man mit modellen experimentiert.

Und wieder alles in einen Topf und umrühren...

Ich glaub das ist hier tatsächlich das Problem, du wirfst alles in einen Topf, ohne dir die einzelnen Bestandteile richtig anzuschauen.

ob man den frequenzfilter der luft absorbtion bei 14 metern schon für die reflektionen braucht wenn nachher ein vinylmaster draus wird ist eine andere frage.

aber die absenkung der amplitude insgesamt ist essentiell.

Soweit so richtig.

Ich zitiere hier erklärend mal Sengpiel:

Dämpfung der Luft bei hohen Frequenzen (Dissipation) ist eine andere Tatsache.

Bitte nicht mit der normalen Dämpfung (Abnahme) des Schalls mit der Entfernung verwechseln.

denk mal, wenn eine snaredrum aus 1 meter ausfgenommen wird und 80 db hatte, dann hat die reflektion dieses ereignisses von der virtuellen rückwand in 50 meter entfernung 72 db weniger. diese größenordnung musst du schon irgendwo auch beachten, wenn du einen raum nachbildest.

Wie kommst du denn bitte auf 72dB Absenkung?

Erläutere mir mal bitte deinen Rechenweg, der dich zu diesem Ergebnis geführt hat?

Ok, sei es drum - nehmen wir mal dein Beispiel.

Die Hörposition liegt in 1m Entfernung von der Quelle und wird Billard-mäßig über eine 50 m entfernte Bande gespielt.

Das ergibt nach Pythagoras einen Weg von 100,02m (gerundet 100m)

Jetzt berechnen wir die Pegeldifferenz zwischen Direktschall und reflektiertem Schall.

Wir messen an der Hörposition in 1m Entfernung von der Quelle 80dB für den Direktschall.

Das ist unsere Ausgangsbasis und jetzt kommt das reziproke 1/r Abstandsgesetz ins Spiel.

Man kann dank des 1/r Gesetzes feststellen, daß eine Verdopplung des Abstands einer Pegelsenkung (Dämpfung) um -6dB entspricht.

Haben wir bei 1m also 80dB, dann sinds bei 2m nur noch 74dB, bei 4m noch 68dB, bei 8m noch 62dB, bei 16m noch 56dB, bei 32m noch 50dB, bei 64m noch 44dB, bei 128m noch 36dB etc, etc, etc.

So sieht das dann aus, wenn man das berechnen will:

20log(r1/r2)

r1=1m, r2=100m

20log(1/100)=-40

Wir reden hier also nicht von 72dB Absenkung, sondern von einer Absenkung um 40dB für das reflektierte Signal.

Wo hast du die 72dB her?

Ausgewürfelt?