LUTs wurden viel genutzt in den 70er/80er und auch noch teilweise 90er, für alles mögliche, also immer da wo man Multiplikationen(auch Sinus usw) vermeiden wollte/musste, da diese sehr viele Taktzyklen fraßen. Diese Technik war eigentlich auch schon Assembler Programmieranfänger recht schnell geläufig. Früher war der Speicher im Verhältnis zur CPU noch sehr schnell, heute ist das RAM extrem langsam, weswegen unter anderem eine Multiplikation in der CPU schneller ist, als in den LookUpTables im Speicher rumzuschrubben, wenn dieser nicht gerade gecached wurden. Dann kommen heute auch noch Erweiterungen der CPU zum Einsatz wo man z.B. mehrere Multiplikationen in einem Rutsch erledigen kann usw.

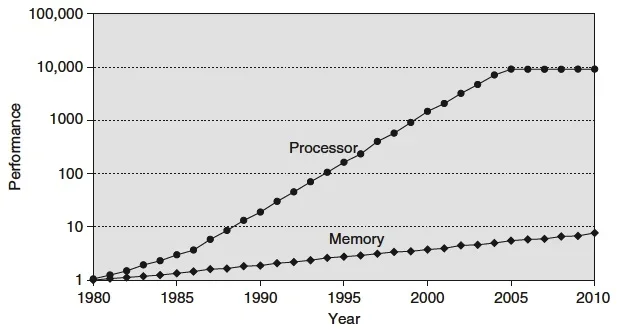

Hier mal eine Tabelle was das Verhältnis der Geschwindigkeit von Speicher und Prozessor im Laufe der Jahre zeigt.

Anhang anzeigen 125415

Da fällt mir noch ein - Synths nutzen heute oft kleine Arm Prozessoren der mitteleren Art, also Cortex A4 - mal etwas mehr, aber selten annähernd so wie zB irgendwelche iPhones neuerer Generation.

Auch Raspberry Pi und Microcontroller sind nicht selten heute - dh - Yamaha hat damals Custom machen KÖNNEN und sie konnten HiTech machen - beides findet nach meiner Beobachtung faktisch nicht mehr statt. Die Rechner sind also oft schnell genug, aber weit hinter dem wie ein Mac oder Pc das könnten.

Das ist ein echter Nachteil für HW Angebote heute - allerdings muss man auch sagen, dass sehr viele Syntheseverfahren nur in den 70/80ern zu wenig Power hatten, heute aber oft genug Rechenpower bekommen.

Nicht mal mehr Korg würde heute einfallen die Resonanz wegzulassen, weil die HW das nicht packt (haben sie mit der Wavestation gemacht). Man lässt heute Aftertouch und MIDI Thru weg - kostet 7€ bzw 1-2€. Scheint sich für ne Serie zu lohnen.

Das aber nur nebenbei als Abgleich - Yamaha war auch schon eine der wenigen Firmen, die echte eigene sehr leistungsstarke Baugruppen selbst herstellten. Custom Knöpfe, Displays und so hingegen waren nicht so selten.

Deine Aufstellung hat einen Knick bei 2004/2005 - was etwa stimmen könnte - wenn man allein Apples M1 und ARM Verlauf auch vor dem M1 mit nimmt wären das Welten drüber. Würde dann noch dazu nehmen, dass Mehrkern für Audio noch immer nicht jeder hinbekommt - deshalb sind das meist heute 1-Kern Teile.

alles weit weit kleiner als das was technisch "machbar" ist - selbst wenn man direkt Kunde bei einem ARM Outlet wäre oder vergleichbar.

So gesehen haben wir alle eine mehrfache Cray in der Tasche.