Theoretisch nicht, praktisch sehr wohl, denn ob Du ein Verfahren/Alg in matlab oder C oder Lisp oder Modellsprache oder mathematisch formulierst, ist für den Aufwand einer eigenen Implementation oder Analyse von (meiner Meinung nach) großer Bedeutung.

Vieles daran ist ganz anders zu machen, aber der Kern der Sache ist doch mehr oder weniger überall der Gleiche. In Max muss ich auch ein und den selben code von MAX nach MSP nach jit.expr nach gen~ nach RNBO übersetzen und überall läuft das Hasilein wieder ein bischen anders, trotzdem ist es eigentlich der immer gleiche Prozess wenn man irgendeinen Generator oder Effekt machen will.

Du brauchst einen Biquad für data Rate? Kein Problem, bau dir einen, der genauso funktioniert wie der, den Du für signal rate bereits hast, dann kannst Du ihn auch ohne groß nachzudenken genauso benutzen.

Du musst ja nicht einen Delay Effekt in max oversamplen und in java plötzlich nicht und in flowstone geht es nur wenn ein game console treiber geladen ist oder sowas - Das Verfahren ist immer gleich.

Die Nicht-Hochsprachen/Nicht-Assembler haben nur einfach ein paar kleine Sachen, die man dort nicht so ohne weiteres selbst machen kann und im Falle von Max und CSound ist da auch ein bischen zuviel Fertigfutter dabei für meinen Geschmack (eine bereits existierende Raumhall Klasse in Max oder den mitgelieferten Moog Filter bei JUCE zu benutzen fühlt sich nicht mehr wirklich wie "selbst machen" an :) )

Für mich als jemand, der mathematikwissenschaftliche Notation und Erklärungen oft nicht lesen und verstehen kann (und daher schon mit matlab, dspreleated oder stackexchange Probleme hat) sind andere User aus der eher kreativen Ecke (oder ein KI chatbot) relativ wichtig zum Austausch, ich brauche das alles metaphorisch bzw. in linearem pseudo code.

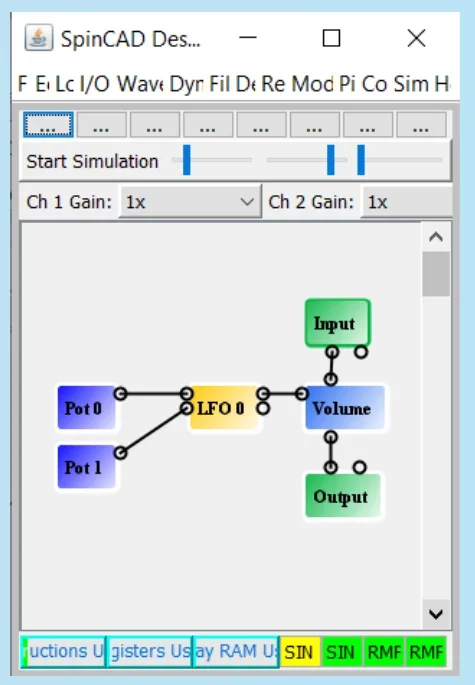

DSP mit grafischer Programmierumgebung wzB beim FV-1 wäre super. Dann brauch man sich nicht mit der programmierung rumschalgen.

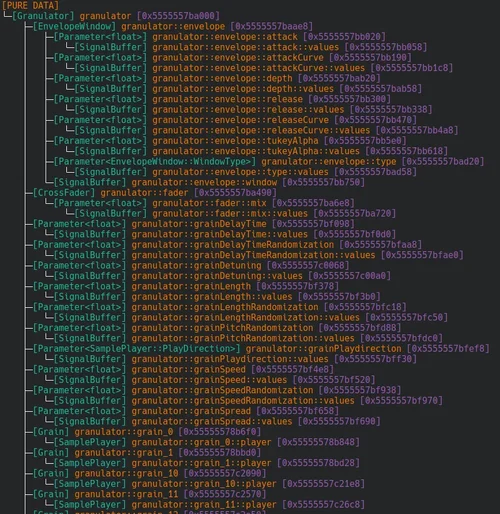

Anhang anzeigen 273777

Also ich habe nicht mal einen Schulabschluss und mir ist eine Umgebung, in der ich selbst entscheiden kann welche Auflösung und welches Zahlensystem ein Poti GUI hat und wie ich das dann mit einer 30 Centimer langen

expr gleichzeitig verzerren, skalieren und auf 2 empfänger aufteilen kann immer noch lieber wie so ein Baukasten, bei dem selbst "*" plötzlich "Volume" heißt, obwohl man genauso gut noch was anderes damit multiplizieren könnte wie eine Musiksignal-Amplitude.

Es muss ja nicht gleich C++ sein.

Das ist so ein bischen, was ich oben zu thomas sagte; Das schöne an expr, den Grundrechenarten, pow, Trigonometrie und Logik ist ja, dass das Zeug erst mal in allen Sprachen gleich ist.

Bei FFT sitzt man dann natürlich mit max und pure data in einem goldenen Käfig, aber + und - sind universell, und somit lässt sich vieles einfach in deutsch oder englisch erklären und sich darüber austauschen.

Wenn ich Dich jetzt frage, welches Signal bei bei linearer FM wie skalieren muss, könntest Du mir das nur in C++ "beantworten"? Falls ja, dann hättest Du es nicht vollumfänglich verstanden und Deine Antwort würde jemanden, der etwas anderes benutzt ggf. nicht helfen. Das muss also auch mit Sprache möglich sein.

Außer Du bis Mathematikprofessor. Dann liegt es in meinem Fall am Empfänger, dass nicht mehr alles ankommen wird, egal wie generisch es präsentiert wird.