einseinsnull

[nur noch PN]

ja, genau - aber bei Festkommazahlen (fixed-point numbers) hat man doch an jeder Stelle eine gleich feine Auflösung

ich denke er hat einfach nur gesagt, dass das bei flaot kein "problem" ist sondern dass das design begründet ist.

der artikel macht nämlich ein problem daraus.

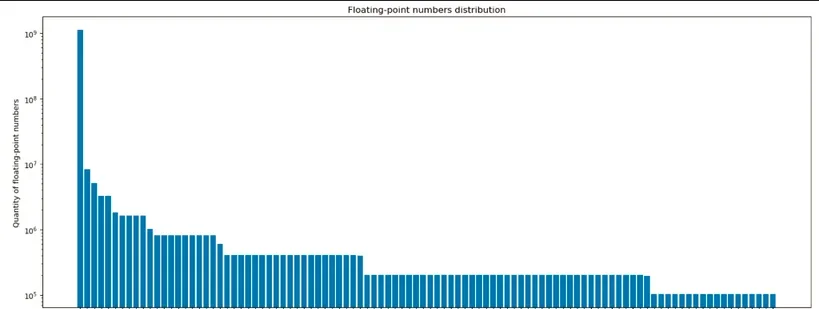

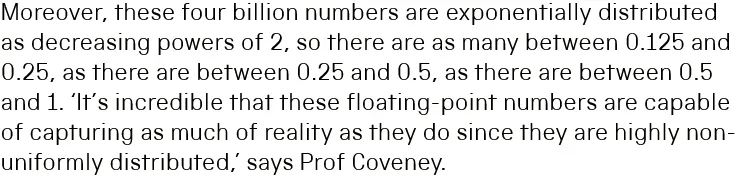

außerdem erscheint die erklärung im arikel auch unvollständig. dort wird nömlich behauptet, die verteilung von float wäre exponentiell.

lustigerweise zitiert er hinterher dem mathematiker, der es dann korrekt darstellt, indem er von non uniform spricht.

die veteilung von float werten sieht so aus:

ok, das ist dann aber schon ein ziemlich arger "Spezialfall"...

der uns hier als vergleich zum papier dienen soll: denn mit einem sehr großen wert zu multiplizieren ist in etwa eine analogie zu rekursion/iterationen: ein vorher bestehende kleiner fehler wird plötzlich riesengroß.

wenn du diese rechnung in 64 bit floating point durchführst, scheitert dies schon an 1/80.

denn 1/80 ergibt dort 0.1250000000000000069388939072283776476697925567627, weil es zwar 1 und 80 gibt, aber 0.0125 nicht existiert.

vor der multiplikation mit 5 ultrafantastilliraden euro ist das kein problem, danach schon.

ob 110 binär oder dezimal ist, darfst du raten.