serge

*****

Ist das…Da ich aber anders als Du keine Quellen benennen kann außer meiner Erinnerung, hast Du Recht.

…nicht das Entscheidende (und was am meisten Spaß macht)?Wieder was gelernt.

Nachfolgend die Erinnerung von jemand, der dabei gewesen ist: Kees A. Schouhamer Immink, einem der Miterfinder der Compact Disc (sowie der DVD und Blue-Ray):

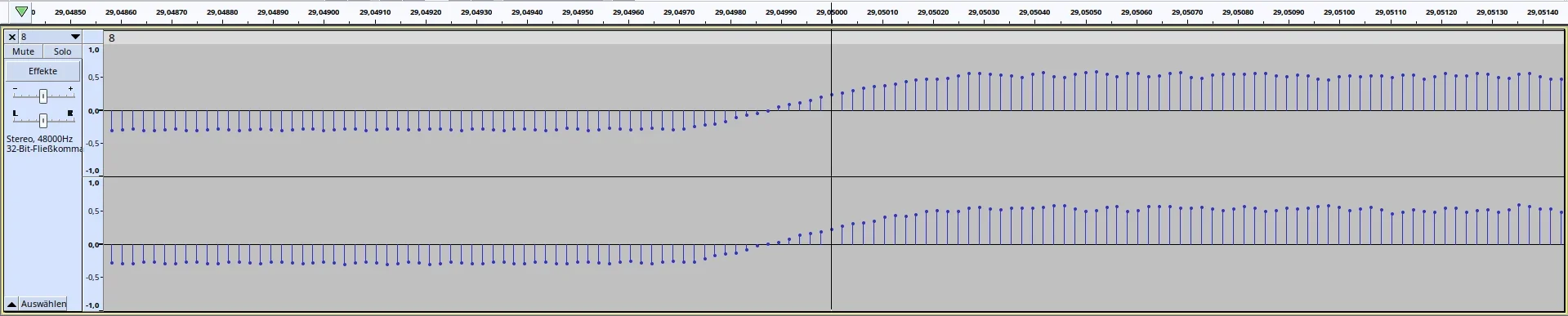

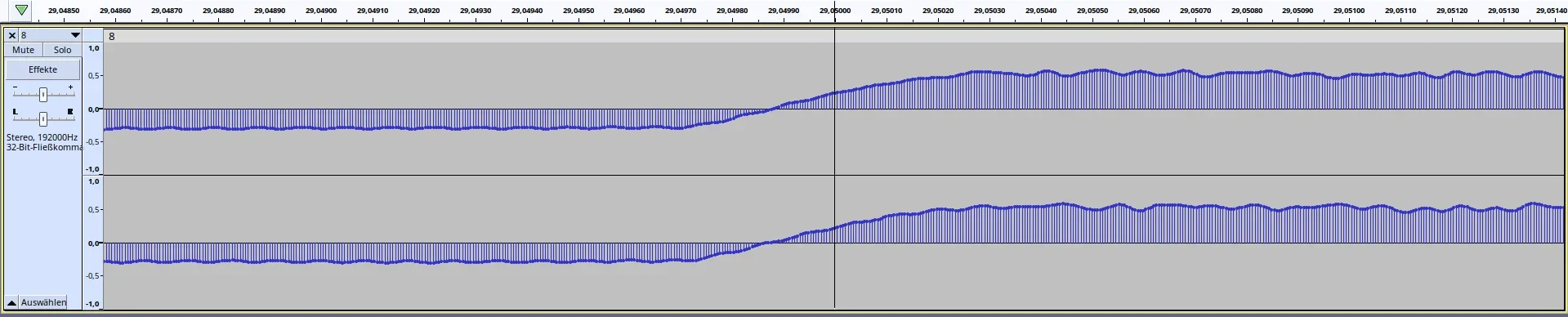

"Towards the end of the 1970s, ‘PCM adapters’ were developed in Japan, which used ordinary analog video tape recorders as a means of storing digital audio data, since these were the only widely available recording devices with sufficient bandwidth. The best commonly-available video recording format at the time was the 3/4" U-Matic.

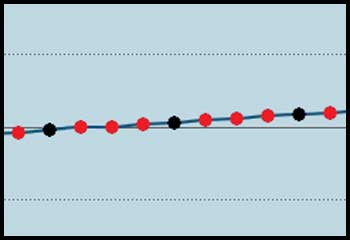

The presence of the PCM video-based adaptors explains the choice of sampling frequency for the CD, as the number of video lines, frame rate, and bits per line end up dictating the sampling frequency one can achieve for storing stereo audio. The sampling frequencies of 44.1 and 44.056 kHz were the direct result of a need for compatibility with the NTSC and PAL video formats. Essentially, since there were no other reliable recording products available at that time that offered other options in sampling rates, the Sony/Philips task force could only choose between 44.1 or 44.056 KHz and 16 bits resolution (or less).

During the fourth meeting held in Tokyo from March 18-19, 1980, Philips accepted (and thus followed Sony’s original proposal) the 16-bit resolution and the 44.1 kHz sampling rate. 44.1 kHz as opposed to 44.056 kHz was chosen for the simple reason that it was easier to remember."

(K. Schouhamer Immink: "Shannon, Beethoven, and the Compact Disc". IEEE Information Theory Society Newsletter (December 2007). 57: 42–46. Link zum Download)

Zuletzt bearbeitet: