S

spacerunner

..

Hallo liebe Musiker / PC - Freundinnen - und Freunde

Macht eine zusätzliche (anstelle der internen) Grafikkarte in einem DAW - Rechner Sinn?

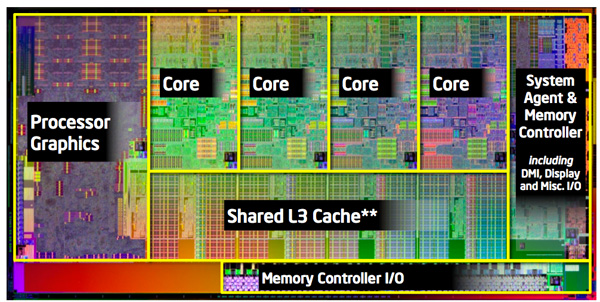

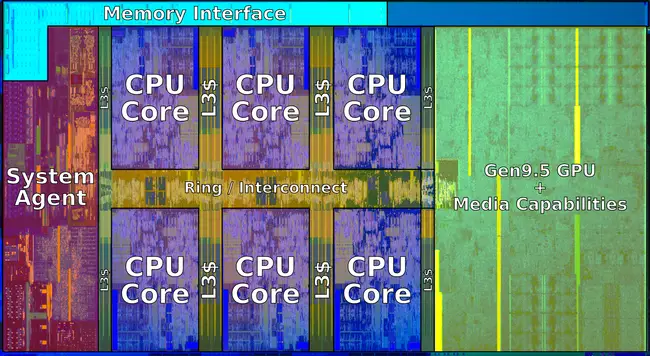

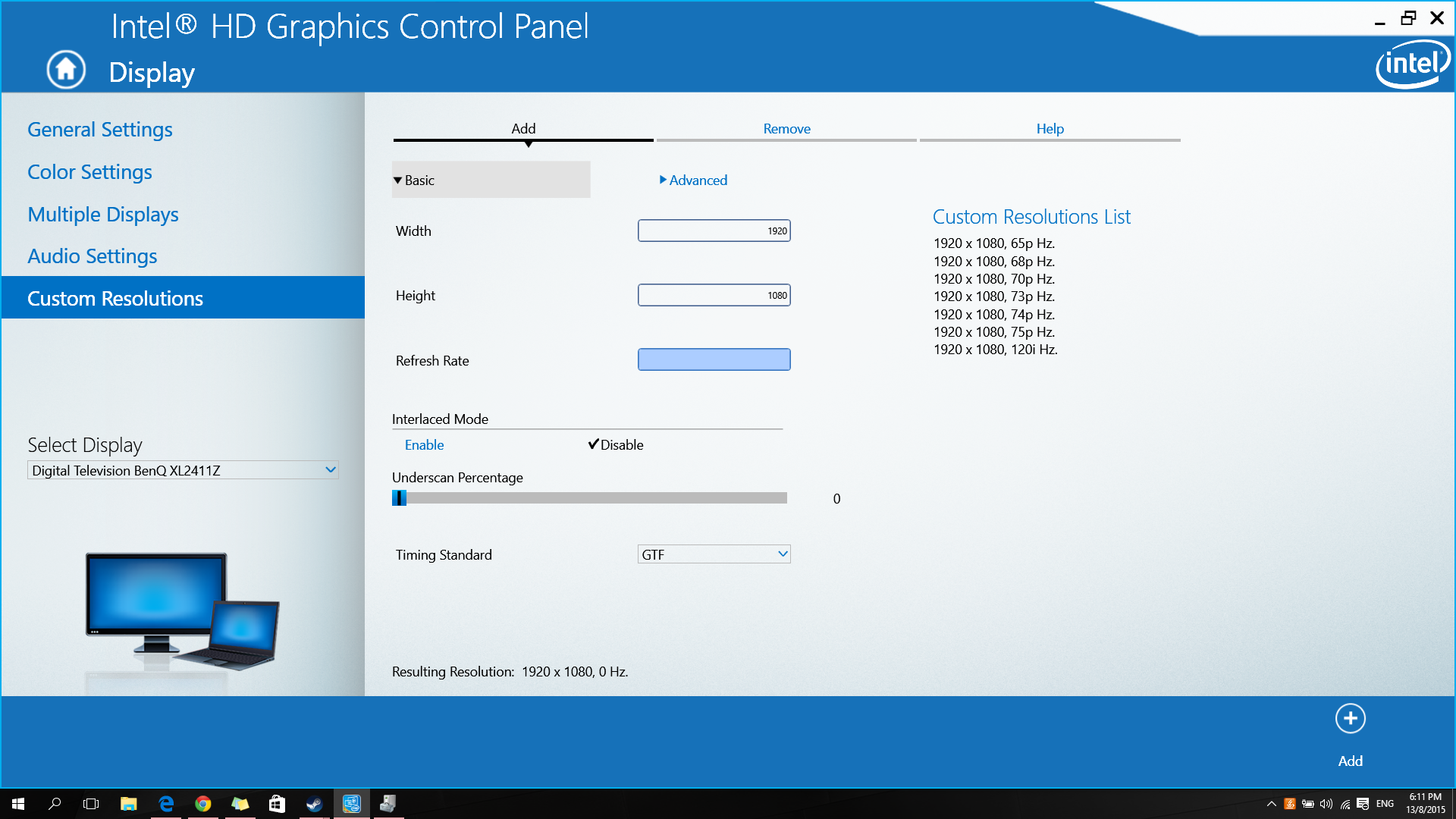

Hier geht es um einen Win10 PC mit dem 8700K Prozessor, 32GB 3200MHZ RAM, Samsung 512GB NVMe SSD und 1TB Samsung SATA SSD. Gearbeitet wird mit einem hochauflösenden 40 Zoll Monitor. Dieser PC wird nicht für Gamen gebraucht, es ist ein reiner DAW - Rechner mit dauerndem Zugang ins Internet.

Falls eine Grafikkarte eine Performance - Steigerung bringen würde, welche wäre hier angebracht?

Vielen Dank für eure Argumente und bis bald,

Rolf aus Zürich

Macht eine zusätzliche (anstelle der internen) Grafikkarte in einem DAW - Rechner Sinn?

Hier geht es um einen Win10 PC mit dem 8700K Prozessor, 32GB 3200MHZ RAM, Samsung 512GB NVMe SSD und 1TB Samsung SATA SSD. Gearbeitet wird mit einem hochauflösenden 40 Zoll Monitor. Dieser PC wird nicht für Gamen gebraucht, es ist ein reiner DAW - Rechner mit dauerndem Zugang ins Internet.

Falls eine Grafikkarte eine Performance - Steigerung bringen würde, welche wäre hier angebracht?

Vielen Dank für eure Argumente und bis bald,

Rolf aus Zürich

Zuletzt bearbeitet: