goorooj

Sproing Wamp Bizzt

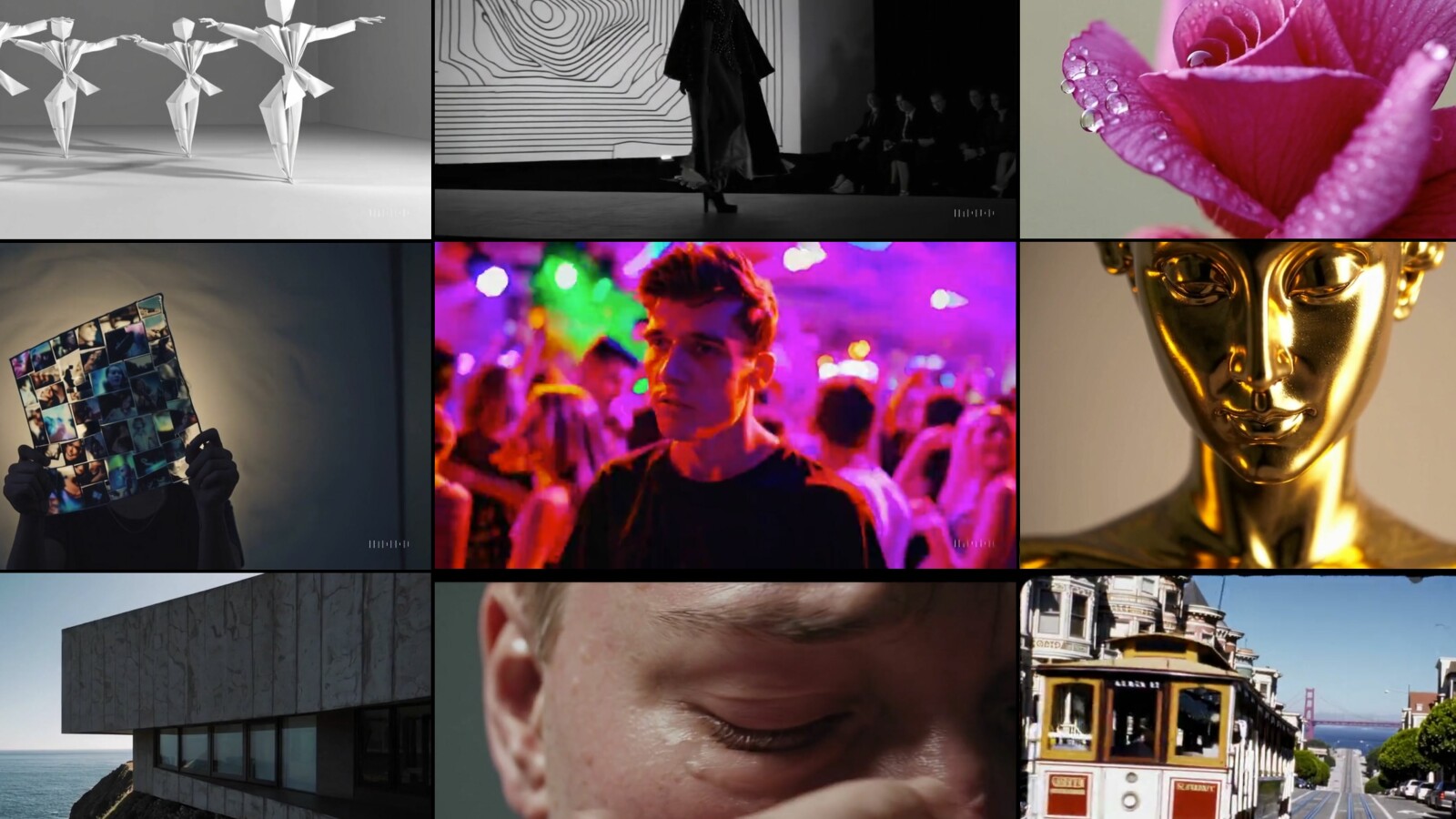

Trust Nothing - Introducing EMO: AI Making Anyone Say Anything

12:39 ist der blanke Hammer

Ich finde was er am Ende sagt ist wichtig... wie er das völlig zusammenhangslos aus der Videothematik herleitet ist jetzt fragwürdig, aber er hat recht.

Wenn ich heute aus einem alten System V Init script eine Systemd unit machen will weil ich auf ein neues System umziehe, kippe ich das einfach in chatGPT und bekomme in nicht mal 10 sekunden mein perfektes Ergebnis.

Da zerbreche ich mir doch nicht mehr den Kopf über das script selber oder ob ich irgendwo eine Klammer vergesse.

Und wenn mir die KI das abnimmt, habe ich den Kopf frei für die wichtigeren Dinge...