maak

||||||||||

Ich habe mich schon immer gefragt was das Oversampling bei Ableton's Compressor tut, und was Oversampling überhaupt ist.

Neben bei wird auch die Nyquist Frequency so erklärt dass man es versteht,

In this video tutorial, Dan Worrall explains when and why you should use higher samplerates for your recordings and mixing sessions, and more importantly... when you should NOT. Also, Dan goes in depth about oversampling vs. higher sample rates.

Disclaimer. Auch wenn das Video eigentlich eine Werbung für Fabfilter ist, der Content erklärt sehr viel.

https://www.youtube.com/watch?v=-jCwIsT0X8M

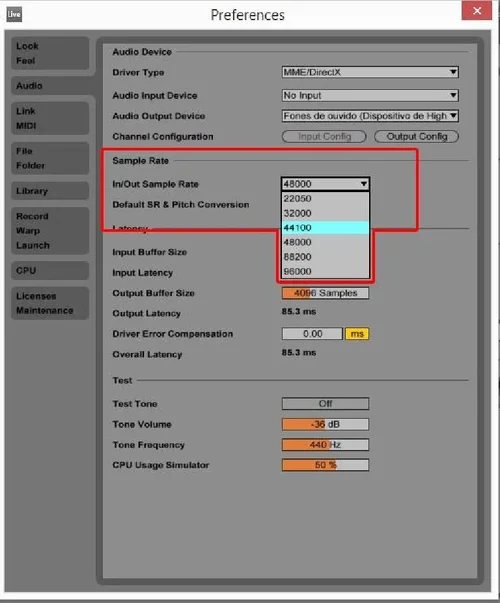

Hängt die interne sample rate der DAW direkt an der sample rate vom audio intarface?

Angenommen das AI kann nur 44.1 kHz kann zB Ableton intern mit 96kHz arbeiten und beim Export down samplen?

Neben bei wird auch die Nyquist Frequency so erklärt dass man es versteht,

In this video tutorial, Dan Worrall explains when and why you should use higher samplerates for your recordings and mixing sessions, and more importantly... when you should NOT. Also, Dan goes in depth about oversampling vs. higher sample rates.

Disclaimer. Auch wenn das Video eigentlich eine Werbung für Fabfilter ist, der Content erklärt sehr viel.

https://www.youtube.com/watch?v=-jCwIsT0X8M

Hängt die interne sample rate der DAW direkt an der sample rate vom audio intarface?

Angenommen das AI kann nur 44.1 kHz kann zB Ableton intern mit 96kHz arbeiten und beim Export down samplen?