B

btrnm

Guest

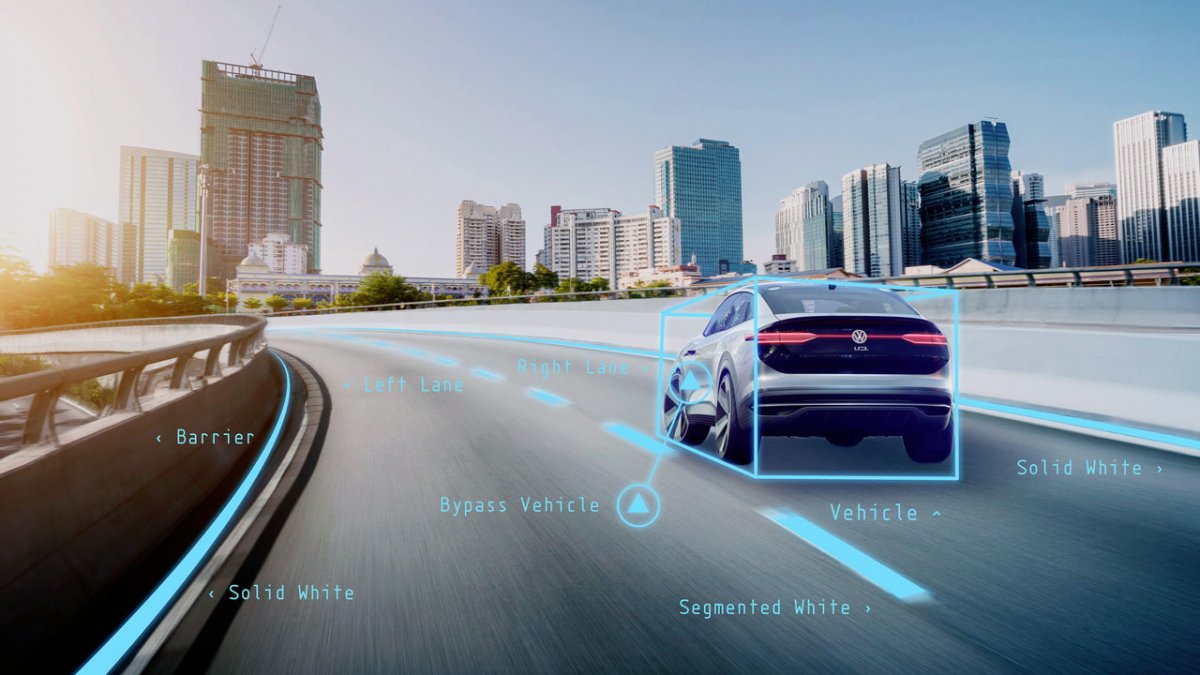

State of the art deep learning Video Manipulation

Ansehen: https://www.youtube.com/watch?v=qc5P2bvfl44

Ansehen: https://www.youtube.com/watch?v=qc5P2bvfl44

Was ist das denn für ein Stück Musik zu Beginn?Ein Abgleich KI vs Code - und von der Schwierigkeit MacOs auf Menschenhardware laufen zu lassen und wie viele Kätzchen von Schrödinger tot sind oder doch weiter miauen und wie Intelligent "Go!" eigentlich ist und was man sonst noch über KI wissen will Folge 42 vom 10.9.2018 <-- ganz hören, dann kommentieren!

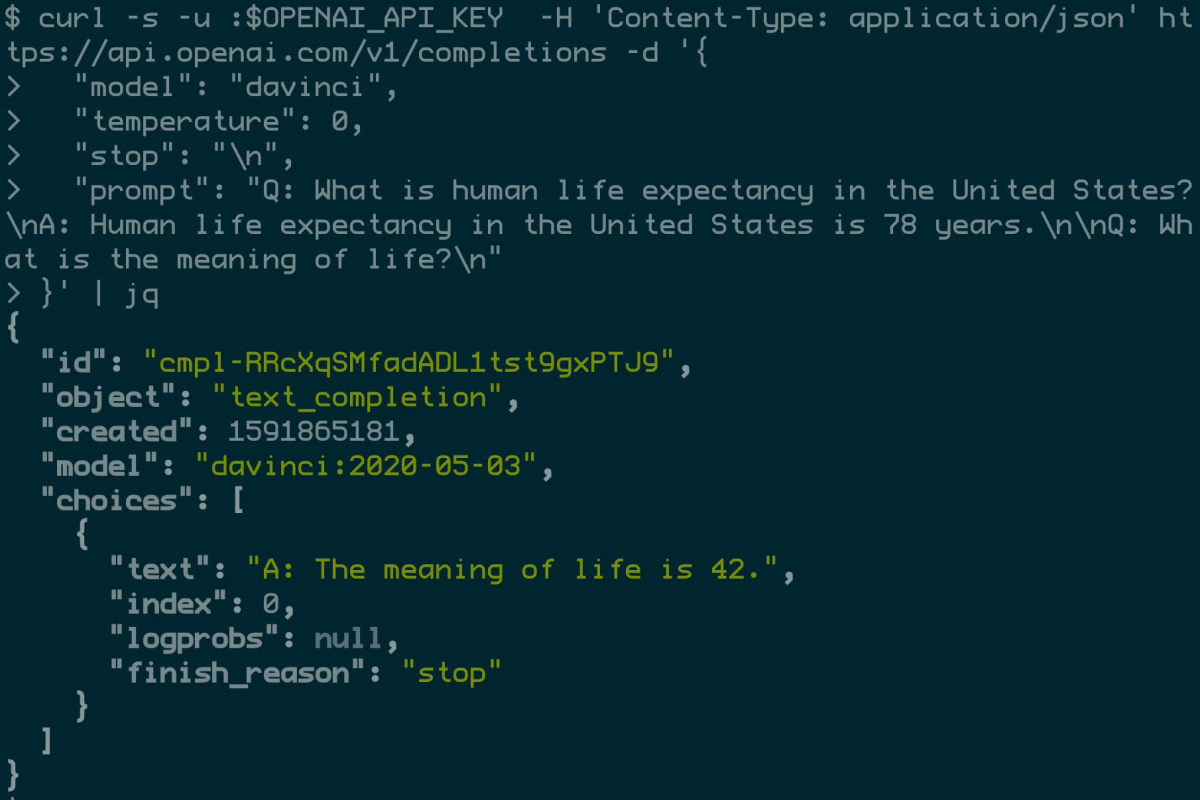

Entwickler der gemeinnützigen Organisation OpenAI haben einen Textgenerator erstellt, der sehr überzeugende Texte schreiben kann. Das Besondere ist, dass die Software sich deren Inhalt einfach ausdenkt. So habe sie etwa zum eigentlich unsinnigen Thema "Recycling ist schlecht für die Umwelt" einen "sehr kompetenten, sehr gut begründeten Aufsatz" geschrieben, sagt OpenAI-Entwickler und Bereichsleiter David Luan dem US-Magazin The Verge. "Das war etwas, womit man im College-Eignungstest US-SAT eine gute Punktzahl hätte erreichen können", ergänzt er.

Der Algorithmus wird GPT-2 (PDF) genannt und spezialisiert sich auf Sprachmodellierung. Er schätzt dabei ein, welche Wörter auf gegebene Wörter folgen könnten und setzt einen Text zusammen. Dadurch kann die Software etwa Statistiken, Zitate und Geschichten erfinden, nachdem ihr eine Überschrift oder ein paar erste Absätze eines Textes gegeben werden.

Naja, das ist auch schon seit 1989 bekannt, als der Aufsatz "Multilayer feedforward networks are universal approximators" von Hornik et al publiziert wurde.Die "irgend jemand" waren Marvin Minsky und Seymour Papert in ihrem 1969er Buch Perceptrons. Ihr Argument war, ein einzelnes Neuron könne nur lineare Funktionen darstellen. Was zweifellos richtig ist. Heutzutage ist klar, daß geschichtete neuronale Netze jede beliebige Funktionen darstellen können.

Für mich wäre es recht interessant meine eigene Musik als Trainingsdaten zu verwenden.Problematischer finde ich es, musikalische Kernkompetenzen der Maschine zu übertragen. Warum überhaupt noch Komposition, Arrangement, Stimmführung, Harmonielehre... lernen, wenn ein cleveres Helferlein diese lästigen Jobs übernehmen kann?

Für mich wäre das nichts, da ich Freude an diesen Details habe. Auch verwende ich noch nicht mal Presets, weil sich da bei mir immer ein Gefühl der Entfremdung einstellt - nicht das Gefühl, etwas eigenes geschaffen zu haben.

Für mich wäre es recht interessant meine eigene Musik als Trainingsdaten zu verwenden.

Natürlich ist fraglich ob man da dann was eigenes schafft, selbst wenn man nachher noch viel Einfluss auf das Ergebnis nehmen könnte.

ai.googleblog.com

ai.googleblog.com

generated with GPT-2 https://app.inferkit.com/demoBlixa Bargeld und Alexander Hacke waren damals schon seit zwei Jahren Mitglied in der Band, als Bargeld im Oktober 2014 sein Konzert in der Grugahalle Hamburg zum letzten Mal seit 2011 absolvierte. Diesen Monat hatte die Band ihre Konzertreihe im Club Der Visionäre eingestellt. Der lange geplante Spatenstich fand im Rahmen einer Gala-Party in Hamburg statt und war laut Bargeld "sehr positiv zur Last gelegt". "Es war ein komplettes Ding. Weil es gut war, die Fans und die ich habe, weil es eine Möglichkeit war, meinen Politikum vorzulegen",

Microsoft is planning to add text predictions to Word in March. The new feature will let you use Word as an alternative to Google Docs and other services. Microsoft Word web versions for Mac and Windows will support predictive text beginning in March, enabling a quick access feature that lets you select parts of the text and then have Microsoft Word know what you want. Predictive text is a useful tool for word processing, but when used with Google Docs, the search engine company’s document collaboration service, it leads to overuse of the system. There are concerns that users

Einer der entscheidenden Schritte war das sicherlich das Back-Propagation-Konzept von Rumelhart, Hinton und Williams 1986.Das Buch "Parallel Distributed Processing" von Rumelhart und McClelland (1986) hatte damals einen wahren NN-Hype ausgelöst.

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.