S

sdvkaeälkjb848

Guest

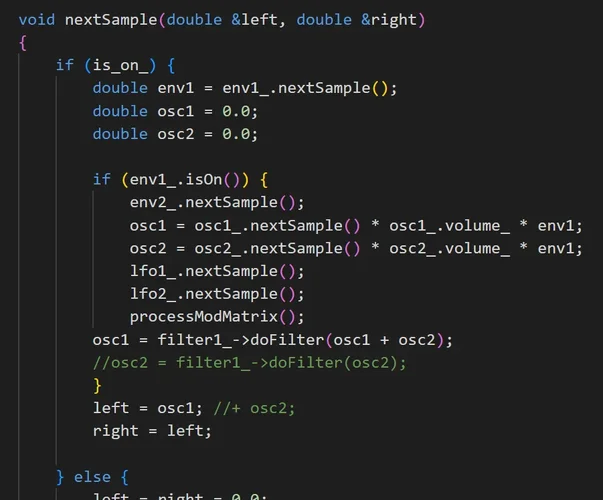

Ist echt viel Stoff. Ich hatte ja den Synth mit Portaudio und Qt für die GUI gemacht und viele Sachen sind mir erst während des Machens aufgefallen, wie z.B. dass man nicht einfach 0-100% von einem Knob auf Parameter mappen sollte, da dies oft unmusikalisch usw. Oder wie man mit Polyphonie arbeitet, wann werden Noten gestohlen usw. Alles Sachen an die ich vorher gar nicht gedacht habe.

Waren echt viele Aha Effekte dabei. Ich denke, da werden dann noch ne Menge Sachen dazukommen. Ich hatte aufgehört als es dann mit Presetspeicherung usw. losging. Die Modmatrix war so das letzte was ich an dem Synth gemacht hatte. Naja und geklungen hat mein Synth halt auch nicht wirklich gut. Ab da an wusste ich aber auch so einige Pluginherrsteller zu schätzen und habe begriffen was für Arbeit dahintersteckt.

Bei DSP, inbesondere Filter, habe ich auch noch einiges nachzuholen. Selbst Filter Koeffizienten erstellen usw. wäre sicher auch mal lehrreich. Ist aber dann nochmal ein Thema für sich. Bis jetzt habe ich nur fertige Filter verwendet, schame on me.

Seit neustem habe ich für mich auch die ADC(Audio Developer Conference) entdeckt, besonders spannend finde ich ja die "neue" Art von Schaltungssimulation. Aber um da was zu machen braucht man sicher die Kennlienen der alten Bauteile und zwar nicht die aus dem Datenblatt, sondern dann real gemessen, damit man auch die ganzen Eigenheiten mit drin hat. Das ist dann natürlich eine Hausnummer zu hoch für mich und eher was für die Profis von Softube, u-he usw.

Auch sehr spannend dürfte Maschine Learning werden, nicht um Musik zu komponieren, sondern z.B. zur Synthese usw. oder vielleicht auch Filterdesign, so unter dem Motto: Hier hast du Impulse Responses vom Filter eines Vintage Gerätes, bau mir ein Modell was genauso klingt. Da sind sicher auch noch ganz andere verrückte Sachen mit ML drin an die man noch gar nicht denkt. Vielleicht neue Syntheseformen. Ach, die Zukunft ist sooo spannend.

www.youtube.com

www.youtube.com

Auf jeden Fall ein spannendes Thema seinen eigenen Synth zu bauen, auch wenn ich da bis jetzt nur an der Oberfläche gekratzt habe.

Waren echt viele Aha Effekte dabei. Ich denke, da werden dann noch ne Menge Sachen dazukommen. Ich hatte aufgehört als es dann mit Presetspeicherung usw. losging. Die Modmatrix war so das letzte was ich an dem Synth gemacht hatte. Naja und geklungen hat mein Synth halt auch nicht wirklich gut. Ab da an wusste ich aber auch so einige Pluginherrsteller zu schätzen und habe begriffen was für Arbeit dahintersteckt.

Bei DSP, inbesondere Filter, habe ich auch noch einiges nachzuholen. Selbst Filter Koeffizienten erstellen usw. wäre sicher auch mal lehrreich. Ist aber dann nochmal ein Thema für sich. Bis jetzt habe ich nur fertige Filter verwendet, schame on me.

Seit neustem habe ich für mich auch die ADC(Audio Developer Conference) entdeckt, besonders spannend finde ich ja die "neue" Art von Schaltungssimulation. Aber um da was zu machen braucht man sicher die Kennlienen der alten Bauteile und zwar nicht die aus dem Datenblatt, sondern dann real gemessen, damit man auch die ganzen Eigenheiten mit drin hat. Das ist dann natürlich eine Hausnummer zu hoch für mich und eher was für die Profis von Softube, u-he usw.

Auch sehr spannend dürfte Maschine Learning werden, nicht um Musik zu komponieren, sondern z.B. zur Synthese usw. oder vielleicht auch Filterdesign, so unter dem Motto: Hier hast du Impulse Responses vom Filter eines Vintage Gerätes, bau mir ein Modell was genauso klingt. Da sind sicher auch noch ganz andere verrückte Sachen mit ML drin an die man noch gar nicht denkt. Vielleicht neue Syntheseformen. Ach, die Zukunft ist sooo spannend.

ADC - Audio Developer Conference

ADC is an annual event celebrating all audio development technologies, from music applications and game audio to audio processing and embedded systems. ADC’s mission is to help attendees acquire and develop new skills, and build a network that will support their career development. It is also...

Auf jeden Fall ein spannendes Thema seinen eigenen Synth zu bauen, auch wenn ich da bis jetzt nur an der Oberfläche gekratzt habe.

Zuletzt bearbeitet von einem Moderator: