Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Einsatz von AI zum Musik machen

- Ersteller Martin Kraken

- Erstellt am

einseinsnull

[nur noch PN]

@einseinsnull

Du postest genau das, was du für deine Argumentation brauchst und bist dir nicht mal zu schade, alles aus dem Kontext zu reißen...

der kontext lautete "KI zum musikmachen" - und du reduzierst das auf webspielereien der marke "sumo", ergänzt das thema dann um chatbots und setzt chatbots mit hitler gleich, aber ich reiße die dinge aus dem kontext?

Blabla, Unterhaltung auf Verschwörungstheoretiker-Niveau. Ich bin weder für noch gegen AI, darum ging es überhaupt nicht.

es ging darum, dass du ausgerechnet amodei bemüht hast - als beispiel für einen experten, der vor den gefahren warnt.

dass der mann damit sein geld verdient und ganze bücher vor allem vor allem auch über die chancen geschrieben hat, die in der technologie liegen, das weißt du entweder nicht oder ignorierst es sogar bewusst.

nur sind die gefahren, die von großkonzernen für die gesellschaft ausgehen für das schaffen von künstlern, musikern oder wissenschaftlern mithilfe von KI software vollkommen irrelevant.

wenn du vor den gefahren warnen willst, dann macht dir entweder mal eigene gedanken dazu oder such dir einen besseren prophetenstrohmann aus als ausgerechnet den.

der mann ist wissenschaftler, dass er sowohl die gefahren als auch die chancen sieht liegt in der natur der sache.

Der Mensch stellt nur die Input-Daten mehr nicht und diese sind und können im Prinzip kaum noch handselektiert sein.

das ist einfach sachlich falsch. praktisch jeder, der professionell KI systeme einsetzt trainiert seine systeme auch selbst.

das ist der punkt, den du genauso wenig zu kapieren scheinst wie kevinside auch.

wenn ich eiweißverbindungen erforsche, tierstimmen interpretrieren oder die echtheit eines gemäldes überprüfen will, dann geht das nicht mit GPT oder sumo, sondern dann muss ich die dazu notwendigen daten selbst eingeben.

der output eines solches systems wirkt dann quasi nur wie nicht-deterministisch, ist es im kern aber.

Zuletzt bearbeitet:

Martin Kraken

Anfänger

der kontext lautete "KI zum musikmachen" - und du reduzierst das auf webspielereien der marke "sumo", ergänzt das thema dann um chatbots und setzt chatbots mit hitler gleich, aber ich reiße die dinge aus dem kontext?

es ging darum, dass du ausgerechnet amodei bemüht hast - als beispiel für einen experten, der vor den gefahren warnt.

dass der mann damit sein geld verdient und ganze bücher vor allem vor allem auch über die chancen geschrieben hat, die in der technologie liegen, das weißt du entweder nicht oder ignorierst es sogar bewusst.

nur sind die gefahren, die von großkonzernen für die gesellschaft ausgehen für das schaffen von künstlern, musikern oder wissenschaftlern mithilfe von KI software vollkommen irrelevant.

wenn du vor den gefahren warnen willst, dann macht dir entweder mal eigene gedanken dazu oder such dir einen besseren prophetenstrohmann aus als ausgerechnet den.

der mann ist wissenschaftler, dass er sowohl die gefahren als auch die chancen sieht liegt in der natur der sache.

das ist einfach sachlich falsch. praktisch jeder, der professionell KI systeme einsetzt trainiert seine systeme auch selbst.

das ist der punkt, den du genauso wenig zu kapieren scheinst wie kevinside auch.

wenn ich eiweißverbindungen erforsche, tierstimmen interpretrieren oder die echtheit eines gemäldes überprüfen will, dann geht das nicht mit GPT oder sumo, sondern dann muss ich die dazu notwendigen daten selbst eingeben.

der output eines solches systems wirkt dann quasi nur wie nicht-deterministisch, ist es im kern aber.

Hä? Es ging einzig und alleine darum, dass das Netz ne Blackbox ist, weil @Summa das bis jetzt nicht versteht und das sagt dir jeder der halbwegs Ahnung von LLMs hat.

Was meinst du mit -trainiert seine KI-Systeme „selbst“?- Von Hand oder was? Natürlich kann man das Netz mit bestimmten Input/Output-Paaren manipulieren, ändert aber nichts an der Blackbox.

Sei mir nicht böse wenn ich mich an dieser Stelle ausklinke, irgendwelche Javascript Seiten auf meinem Rechner öffnen fällt mir nicht im Traum ein und eine Katze frisst nicht nur Fisch.

Verstehe schon, du willst es gar nicht verstehen

Summa

hate is always foolish…and love, is always wise...

Wir drehen uns im Kreis, den Bereich hatten wir doch bereits diskutiert (ich hatte den Vergleich mit einem VA gebracht) und ich riskiere nicht die Sicherheit meines PCs.Verstehe schon, du willst es gar nicht verstehen

Zuletzt bearbeitet:

Solar Chrome

Electro Synth Maniac

Nutze sowas schon und beobachte das sehr gespannt.

Gerade der Bereich Stem Separation hat gute Fortschritte gemacht, erfüllt aber noch nicht meine Erwartungen.

Ich muss mich auch mal bezüglich AI Vocals informieren. Das wäre endlich mal die Möglichkeit Gesang zu bekommen, ohne auf die Befindlichkeiten von irgendwelchen Leuten Rücksicht zu nehmen. Natürlich arbeite ich super gern im Team, aber bisher hat das nicht gut funktioniert. Mein letzter Sänger ist kurz nachdem wir einen richtig guten Song am Start hatten flügge geworden und dann stand wieder alles bei Null.

Gerade der Bereich Stem Separation hat gute Fortschritte gemacht, erfüllt aber noch nicht meine Erwartungen.

Ich muss mich auch mal bezüglich AI Vocals informieren. Das wäre endlich mal die Möglichkeit Gesang zu bekommen, ohne auf die Befindlichkeiten von irgendwelchen Leuten Rücksicht zu nehmen. Natürlich arbeite ich super gern im Team, aber bisher hat das nicht gut funktioniert. Mein letzter Sänger ist kurz nachdem wir einen richtig guten Song am Start hatten flügge geworden und dann stand wieder alles bei Null.

Martin Kraken

Anfänger

Nutze sowas schon und beobachte das sehr gespannt.

Gerade der Bereich Stem Separation hat gute Fortschritte gemacht, erfüllt aber noch nicht meine Erwartungen.

Ich muss mich auch mal bezüglich AI Vocals informieren. Das wäre endlich mal die Möglichkeit Gesang zu bekommen, ohne auf die Befindlichkeiten von irgendwelchen Leuten Rücksicht zu nehmen. Natürlich arbeite ich super gern im Team, aber bisher hat das nicht gut funktioniert. Mein letzter Sänger ist kurz nachdem wir einen richtig guten Song am Start hatten flügge geworden und dann stand wieder alles bei Null.

Es gibt meines Wissens im Moment 2 Optionen um an AI-Vocals zu kommen. Einmal mit Suno, jedoch generiert Suno dir eine beliebige Melodie für die Vocals und du kannst das nicht steuern. Du kannst in gewissen Rahmen Tonart und BPM versuchen einzuschränken. Es ist also sinnvoller sich einen Song mit Suno generieren zu lassen, die Stems der Vocals zu nehmen und darum einen eigenen Backtrack zu bauen. Eine andere Option ist die Vocals selbst einzusingen mit Melodyne oder ähnlichem auf die richtige Tonhöhe zu bringen und auf Seiten wie Kits.ai oder audimee in professionelle Vocals konvertieren zu lassen.

einseinsnull

[nur noch PN]

Hä? Es ging einzig und alleine darum, dass das Netz ne Blackbox ist, weil @Summa das bis jetzt nicht versteht und das sagt dir jeder der halbwegs Ahnung von LLMs hat.

man erklärt martin, dass KI mehr als sprachmodelle ist - und martin erklärt dir, dass es doch nur sprachmodelle sind.

einseinsnull

[nur noch PN]

Das wäre endlich mal die Möglichkeit Gesang zu bekommen, ohne auf die Befindlichkeiten von irgendwelchen Leuten Rücksicht zu nehmen.

wie ein kollege von mir mal sagte: ein guter sänger erklärt dir, wie du aufzunehmen und zu mischen hast und ob der take wiederholt werden muss. :)

Martin Kraken

Anfänger

Wir drehen uns im Kreis, den Bereich hatten wir doch bereits diskutiert (ich hatte den Vergleich mit einem VA gebracht) und ich riskiere nicht die Sicherheit meines PCs.

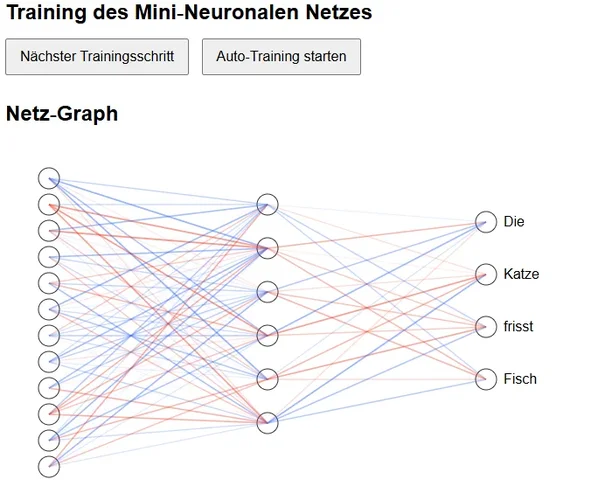

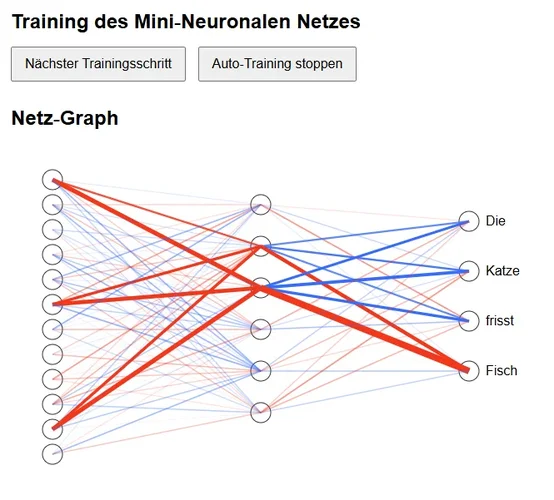

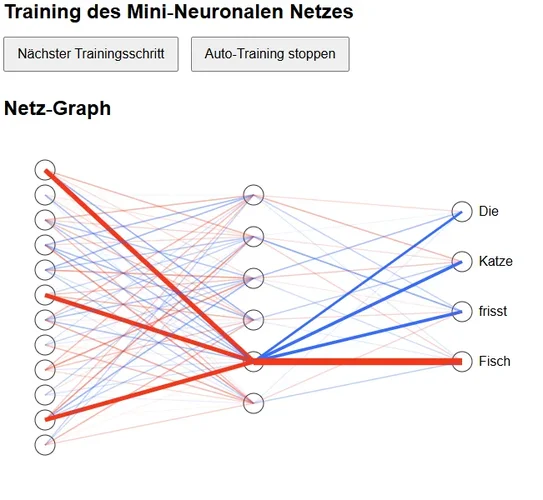

Der Vergleich mit dem VA zeigt, dass du das Prinzip eines neuronalen Netzes noch nicht verstanden hast. Es ist schon etwas billig zu sagen, dass du dir keine Videos anschaust und kein Javascript html im Browser öffnen möchtest. Klingt mir eher so als, ob du lieber nicht verstehen willst. Aber hier mal das wesentliche in Bildern

Vor dem Training mit zufälligen Startwerten.

Nach einem kompletten Training (erster Versuch)

Nach einem Reset und Neustart: Nach einem kompletten Training (zweiter Versuch)

Du siehst, das entstandene Netz ist beide Male komplett anders führt aber zum selben Ergebnis. Es ist also nicht wie dein VA-Beispiel, wo der Output immer anders ist. Nach unzählbaren Sätzen und Texten mit denen das System gefüttert wird kann keiner mehr entschlüsseln welche Nodes was bedeuten, denn jeder Node wurde von Billionen Texten variiert. In einem Node stecken also Milliarden an Informationen die aber nur in Kombination mit den anderen Billionen Nodes einen Sinn ergeben. Ab einer gewissen Menge an Informationen scheint so ein Netz völlig automatisch so etwas wie Intelligenz zu entwickeln und ihm unbekannte Aufgaben zu lösen. Das könnte bedeuten, dass das was wir Intelligenz nennen auch nichts weiter ist als der Abgleich unseres neuronalen Netzes mit dem in ihm enthaltenen Informationen und das es gar kein "Verstehen" gibt. "Verstehen" ist nur eine Illusion. Ein LLM predicted immer nur das best mögliche nächste Wort in einem Text/Code, es versteht gar nix. Vielleicht verstehen wir auch gar nix und haben nur furchtbar viele Informationen gesammelt die uns erlauben eine intelligente nächste Handlung durchzuführen?

Was auch immer, jedenfalls ist es nicht möglich vollständig zu sagen was in einem solchen Netz schlummert und welche Antwort wir bekommen wenn wir ihm eine bestimmte Frage stellen.

man erklärt martin, dass KI mehr als sprachmodelle ist - und martin erklärt dir, dass es doch nur sprachmodelle sind.

Du bist verwirrt oder willst irgendwelchen blöden Derails betreiben. Habe ich keine Lust drauf. Erzähl was du damit meinst die KI "selbst" zu trainieren, dann können wir darüber reden, aber immer irgendwelche Strohmänner aufbauen und random irgendwas einzuwerfen ist irgendwie auf Verschwörungstheoretiker-Niveau.

Kevinside

Mein Sehen schwindet, so auch mein Leben...

@einseinsnull

Interessant...Ich habe Chatbots nie mit Hitler gleichgesetzt...Das. was ich meinte, war der Chatbot von Elon Musk, der eben Hitler verherrlicht hat und sonst auch nur irgendeine Musk konforme Antwort gegeben hat...

Elon Musk´s Chatbot Grok war nicht nur antisemitisch, sondern sogar rechtsradikal...

Naja diese blöde KI hat leider falsche Parameter von uns bekommen, laut Entwickler...

Tja; Wie intelligent ist eine Ki wirklich, wenn einige wenige Parameter reichen, um einen Massenmörder hochleben zu lassen.... Das ist KI? Wunderbar

Ich denke; Wir werden bei dieser Thematik keinen Konsens finden...

Aber das ist ok...

Ich werde dir nicht mehr antworten, denn dieses passiv aggresive Getue finde ich nicht nur kindisch, sondern geradezu pubertär...

Sry... Jetzt kannst du gerne dein gesamtes Arsenal auf mich abfeuern... Es ist so unwichtig, uninteressant und egal... Und das ist das Gute daran... :)

Interessant...Ich habe Chatbots nie mit Hitler gleichgesetzt...Das. was ich meinte, war der Chatbot von Elon Musk, der eben Hitler verherrlicht hat und sonst auch nur irgendeine Musk konforme Antwort gegeben hat...

Elon Musk´s Chatbot Grok war nicht nur antisemitisch, sondern sogar rechtsradikal...

Naja diese blöde KI hat leider falsche Parameter von uns bekommen, laut Entwickler...

Tja; Wie intelligent ist eine Ki wirklich, wenn einige wenige Parameter reichen, um einen Massenmörder hochleben zu lassen.... Das ist KI? Wunderbar

Ich denke; Wir werden bei dieser Thematik keinen Konsens finden...

Aber das ist ok...

Ich werde dir nicht mehr antworten, denn dieses passiv aggresive Getue finde ich nicht nur kindisch, sondern geradezu pubertär...

Sry... Jetzt kannst du gerne dein gesamtes Arsenal auf mich abfeuern... Es ist so unwichtig, uninteressant und egal... Und das ist das Gute daran... :)

Zuletzt bearbeitet:

Summa

hate is always foolish…and love, is always wise...

Du hast afair weiter vorne von etwas gesprochen dass auf den selben Input jeweils einen anderen Output reagiert, jetzt erklärst du mir was das auf unterschiedlichen Wegen zum selben Output kommt.Der Vergleich mit dem VA zeigt, dass du das Prinzip eines neuronalen Netzes noch nicht verstanden hast.

Natürlich kommt man auf ganz unterschiedlichen Wegen Problemlos zum selben Ergebnis, was genau soll das beweisen? Wie dein Neuronale Netz die jeweiligen Daten/Zustände bewertet kann ich Anhand deiner Bilder und Beschreibungen nicht erkennen, es entstehen Daten beim Lernprozess und müssen ja irgendwo gespeichert werden.Du siehst, das entstandene Netz ist beide Male komplett anders führt aber zum selben Ergebnis.

Es ist ja jetzt keine neue Erkenntnis dass man auf unterschiedlichen Wegen zum selben Ziel kommen kann. Ich bringe mal wieder ein Beispiel aus dem Sound Bereich, ich kann den selben Sound auf ganz unterschiedliche Arten erzeugen und trotzdem analysieren wie der Sound gebaut wurde.

Zumindest nicht ohne die Daten die du entweder nicht kennst oder verschweigst.Was auch immer, jedenfalls ist es nicht möglich vollständig zu sagen was in einem solchen Netz schlummert und welche Antwort wir bekommen wenn wir ihm eine bestimmte Frage stellen.

Zuletzt bearbeitet:

Kevinside

Mein Sehen schwindet, so auch mein Leben...

@Martin Kraken

Aber wir haben eben einen Vorteil, der so massiv ist...

Die emotionale Komponente... Daraus ergibt sich ein Gewissem...

Eine jetzige KI kann ich trainieren wie ich will, sie wird immer eine Variatiom kreieren aus dem Fundus meines "Trainings"...

Deswegen ist es ja so einfach, Chatbots zu überlisten, weil diese eben nicht selber denken sondern nur mit dem trainierten Wissen agieren...Das gilt auch für die ganzen Musik AI Tools...

Die Ki hat keinen freien Willen... Wenn ich ein Modell nur mit rechtradikalen Websites,Texten usw. trainiere, ist sie der perfekte Nazi... Die KI hinterfragt nicht, reflektiert nicht...

Und das ist aber ein fundemantaler Punkt in unserer gesamten Entwicklung...oder nicht?

Aber wir haben eben einen Vorteil, der so massiv ist...

Die emotionale Komponente... Daraus ergibt sich ein Gewissem...

Eine jetzige KI kann ich trainieren wie ich will, sie wird immer eine Variatiom kreieren aus dem Fundus meines "Trainings"...

Deswegen ist es ja so einfach, Chatbots zu überlisten, weil diese eben nicht selber denken sondern nur mit dem trainierten Wissen agieren...Das gilt auch für die ganzen Musik AI Tools...

Die Ki hat keinen freien Willen... Wenn ich ein Modell nur mit rechtradikalen Websites,Texten usw. trainiere, ist sie der perfekte Nazi... Die KI hinterfragt nicht, reflektiert nicht...

Und das ist aber ein fundemantaler Punkt in unserer gesamten Entwicklung...oder nicht?

Kevinside

Mein Sehen schwindet, so auch mein Leben...

Summa

hate is always foolish…and love, is always wise...

Ich halte meine Augen und Ohren offen, aber der Soundbau ist bei mir Teil des kreativen Prozesses beim Musik machen, von daher bin ich vielleicht eher als Trainer und weniger als User einer solchen Software interessant.@Summa

Gibt es eigentlich schon KI Modelle für Sounddesign...

Aus den FAQs der Software: ILLUGEN is designed to keep things fresh. Even if you use the exact same prompt, the results will always be slightly different. You might get something similar, but never an identical sound.Ich hab mal diese Waves Geschichte Illugen ausprobiert...

Trotz gleichen "Prompt" Beschreibung, waren die Ergebnisse immer unterschiedlich...Warum?

Cee

been there, done that

Du bist verwirrt oder willst irgendwelchen blöden Derails betreiben. Habe ich keine Lust drauf. Erzähl was du damit meinst die KI "selbst" zu trainieren, dann können wir darüber reden, aber immer irgendwelche Strohmänner aufbauen und random irgendwas einzuwerfen

Hmm, das scheint mir eine gute Beschreibung Deiner anekdotischen Einwürfe hier zu sein - von 'Intelligenz, Verstehen' bis zu Kindernetzwerken in HTML. Ganz zu schweigen von den persönlichen Beleidigungen, die Du immer häufiger einstreust, wenn jemand Deine (Dir so erscheinenden) Wahrheiten nicht teilt.

Dafür, dass sie die Energie einer mittleren Großstadt brauchen und mehr Transistoren enthalten als unser Hirn Neuronen, können die AI ganz schön wenig, halluzinieren zT grotesk (siehe mein obiges Beispiel) und versagen, wenn das Datenmaterial zu einer Aufgabe gering ist (dto.).

Also bitte etwas mehr Selbstbeherrschung; tut auch Fanboys gut.

---

Wieso glauben übrigens alle, dass Intelligenz beliebig nach oben skalierbar ist? Dass die derzeitigen Modelle diejenigen sind, die demnächst eine Strong AI (oder gar, für Fanboys, 'Singularität') werden?

Pete1

|||||||

Jede KI oder auch neuronales Netz hat einen zufällige Komponente. Da wird von vornherein festgelegt, dass berechneten Werten diese Komponente hinzugefügt wird. Das macht das Ganze dann am Ende in einem bestimmte Maße variabel.@Summa

Gibt es eigentlich schon KI Modelle für Sounddesign...Ich hab mal diese Waves Geschichte Illugen ausprobiert...

Trotz gleichen "Prompt" Beschreibung, waren die Ergebnisse immer unterschiedlich...Warum?

Und der Grund ist, dass die KI damit anpassungsfähiger wird. Wenn man diese Komponente nicht hätte, würde sie zwar für Trainingsdaten ideal passen. Sobald aber leicht andere Daten verwendet werden, sind die Ergebnisse nicht mehr so gut.

Mit der variablen Komponente hingegen erhält sie die Fähigkeit, auch bei unerwarteten Daten sinnvolle Ergebnisse auszugeben. Und das ist auch das Spannende: Warum das funktioniert.

Daneben ist das auch ein gewünschtes Verhalten. Der Zufall wirkt natürlicher. Menschen antworten auf dieselbe Frage auch nie 100% gleich. Aber inhaltlich ist es doch jedesmal sehr ähnlich.

Eigentlich ist das Thema total interessant, aber hier herrscht ein Ton, wie auf dem Schulhof. Verstehe nicht, warum diese Diskussion hier immer wieder so abdriften muss. Kann doch nicht so schwer sein, einen anderen Standpunkt anzuerkennen, ohne persönlich zu werden? Der andere Standpunkt hat ja irgendeinen Grund und der wurde nicht ausgewürfelt.

Nun ja, ich glaub ich klink mich dann aus.

Schade. Aber dennoch schon mal einen entspannten Sonntag!

Scenturio

au̶̫di̪̮͟at̢̗̀ur̻̱ ët ảltͬ͗er̖͐́a ̢͕̰pa͙̭rs

hast du mal synthesizer v studio probiert? ich finde das ganz gut, vor allem, weil man sehr genaue kontrolle hat (noten, intonation mit diversen parametern, automatisierbar).Ich muss mich auch mal bezüglich AI Vocals informieren.

Martin Kraken

Anfänger

Hmm, das scheint mir eine gute Beschreibung Deiner anekdotischen Einwürfe hier zu sein - von 'Intelligenz, Verstehen' bis zu Kindernetzwerken in HTML. Ganz zu schweigen von den persönlichen Beleidigungen, die Du immer häufiger einstreust, wenn jemand Deine (Dir so erscheinenden) Wahrheiten nicht teilt.

Dafür, dass sie die Energie einer mittleren Großstadt brauchen und mehr Transistoren enthalten als unser Hirn Neuronen, können die AI ganz schön wenig, halluzinieren zT grotesk (siehe mein obiges Beispiel) und versagen, wenn das Datenmaterial zu einer Aufgabe gering ist (dto.).

Also bitte etwas mehr Selbstbeherrschung; tut auch Fanboys gut.

---

Wieso glauben übrigens alle, dass Intelligenz beliebig nach oben skalierbar ist? Dass die derzeitigen Modelle diejenigen sind, die demnächst eine Strong AI (oder gar, für Fanboys, 'Singularität') werden?

Wow, das hatte jetzt mal Substanz. Applaus. Ein wahrer Informationsgewinn deinen Text, er zeugt von hoher Intelligenz und viel Datenmaterial.

Martin Kraken

Anfänger

Du hast afair weiter vorne von etwas gesprochen dass auf den selben Input jeweils einen anderen Output reagiert, jetzt erklärst du mir was das auf unterschiedlichen Wegen zum selben Output kommt.

Natürlich kommt man auf ganz unterschiedlichen Wegen Problemlos zum selben Ergebnis, was genau soll das beweisen? Wie dein Neuronale Netz die jeweiligen Daten/Zustände bewertet kann ich Anhand deiner Bilder und Beschreibungen nicht erkennen, es entstehen Daten beim Lernprozess und müssen ja irgendwo gespeichert werden.

Es ist ja jetzt keine neue Erkenntnis dass man auf unterschiedlichen Wegen zum selben Ziel kommen kann. Ich bringe mal wieder ein Beispiel aus dem Sound Bereich, ich kann den selben Sound auf ganz unterschiedliche Arten erzeugen und trotzdem analysieren wie der Sound gebaut wurde.

Zumindest nicht ohne die Daten die du entweder nicht kennst oder verschweigst.

Wenn du die Parameter/Variablen meinst dann habe ich die im HTML/Javascript für jeden Knoten ausgegeben, wollte hier nur nicht zig Bilder hochladen. Soweit ich das verstehe ist dein Argument, dass wir alle Parameter der Knoten kennen und somit auch verstehen und nachvollziehen können wie ein LLM denkt und warum auf Frage X Antwort Y folgt und das man mit der Software entscheiden kann was das LLM „denkt“. Man also gezielt bestimmte Parameter einstellen kann, so dass man Antwort Z erhält.

Ziemlich viele kluge Köpfe zerbrechen sich gerade die Köpfe wie wir das erreichen können was du dir vorstellst, bis jetzt hat es noch keiner geschafft.

Martin Kraken

Anfänger

@Martin Kraken

Aber wir haben eben einen Vorteil, der so massiv ist...

Die emotionale Komponente... Daraus ergibt sich ein Gewissem...

Eine jetzige KI kann ich trainieren wie ich will, sie wird immer eine Variatiom kreieren aus dem Fundus meines "Trainings"...

Deswegen ist es ja so einfach, Chatbots zu überlisten, weil diese eben nicht selber denken sondern nur mit dem trainierten Wissen agieren...Das gilt auch für die ganzen Musik AI Tools...

Die Ki hat keinen freien Willen... Wenn ich ein Modell nur mit rechtradikalen Websites,Texten usw. trainiere, ist sie der perfekte Nazi... Die KI hinterfragt nicht, reflektiert nicht...

Und das ist aber ein fundemantaler Punkt in unserer gesamten Entwicklung...oder nicht?

Wenn man in einem kleinen Dorf in Sachsen aufwächst ist die Wahrscheinlichkeit auch höher ein Nazi zu werden. Ob wir einen freien Willen haben ist auch stark umstritten. Ist halt auch die Frage, was ein freier Wille überhaupt ist. Wo vor die AI Kritiker Angst haben ist ja, dass die AI einen „freien Willen“ hat und Dinge macht die uns umbringen. Bei einer AI wissen wir mit Sicherheit, dass ihr „freier Wille“ nur ein Mix aus der Kombination aller Informationen und Zufall ist.

dubsetter

||||||||||

ist doch wirklich nix neues....gähn.Ganz zu schweigen von den persönlichen Beleidigungen, die Du immer häufiger einstreust, wenn jemand Deine (Dir so erscheinenden) Wahrheiten nicht teilt.

vielleicht sollte er seinen eigenen "ich" fred aufmachen mit ki als antwort bot...

Zuletzt bearbeitet:

Summa

hate is always foolish…and love, is always wise...

Prinzipbedingt läuft der Lernprozess der K.I. evolutionär ab, in der Natur bestimmt die Umgebung die Resultate während bei einer K.I. Software/Code bestimmt wie die Daten verarbeitet und gewichtet werden. Man hat also die Wahl an diesen beiden Stellschrauben (Code/Lerndaten) zu drehen um ein bestimmtes Ergebnis zu erreichen - beim LLM könnte das auch ein Bereich sein, vielleicht weil Sprache etwas sehr subjektives ist - wie man unter anderem bei unsere Diskussion merkt.Wenn du die Parameter/Variablen meinst dann habe ich die im HTML/Javascript für jeden Knoten ausgegeben, wollte hier nur nicht zig Bilder hochladen. Soweit ich das verstehe ist dein Argument, dass wir alle Parameter der Knoten kennen und somit auch verstehen und nachvollziehen können wie ein LLM denkt und warum auf Frage X Antwort Y folgt und das man mit der Software entscheiden kann was das LLM „denkt“. Man also gezielt bestimmte Parameter einstellen kann, so dass man Antwort Z erhält.

Ziemlich viele kluge Köpfe zerbrechen sich gerade die Köpfe wie wir das erreichen können was du dir vorstellst, bis jetzt hat es noch keiner geschafft.

Das es K.I. Modelle gibt bei der (laut Wikipedia Eintrag zu einer von dir in einem Zitat erwähnten K.I.) ein anderes Modell während des Lernprozess sowas wie eine Überwacher K.I. einsetzt um bei das Ergebnis zu kontrollieren hatte ich weiter vorne schon geschrieben.

Ich nehme an du nutzt Software die du selbst nicht geschrieben/codiert hast und wunderst dich über die Ergebnisse? ;)

Martin Kraken

Anfänger

ist doch wirklich nix neues....gähn.

vielleicht sollte er seinen eigenen "ich" fred aufmachen mit ki als antwort bot...

Na jetzt aber mit vereinten Kräften, hihi.

Prinzipbedingt läuft der Lernprozess der K.I. evolutionär ab, in der Natur bestimmt die Umgebung die Resultate während bei einer K.I. Software/Code bestimmt wie die Daten verarbeitet und gewichtet werden.

Bei beiden gibt es zwei Ebenen. Einmal den Bauplan nach dem gelernt wird (Gehirn/Software), das entscheidende für das Resultat ist aber die andere Ebene, das paar aus Input und Ziel. Beim Menschen ist der Input die Umwelt, die wir mit unseren Sinnen wahrnehmen und das Ziel ist intrinsisch codiert in unserer DNA (z.B. Schmerzrezeptoren etc.). Bei einem LLM ist Input UND Ziel in den Texten mit denen das LLM gefüttert wird codiert. Nicht in der Software! Die entscheidenden Faktoren für ein LLM sind also Input/Ziel/Zufall.

Für die Software ist das Netz auch eine Blackbox, deshalb kann man den Loss nach einem Epoch nicht sofort auf 0 setzen (ist jetzt sehr vereinfacht ausgedrückt)

. Man hat also die Wahl an diesen beiden Stellschrauben (Code/Lerndaten) zu drehen um ein bestimmtes Ergebnis zu erreichen -

Der Code selbst enthält keine Zielvorgaben. Das ist der Unterschied zu einem klassischen Programm, deshalb spricht man auch davon, dass ein LLM nicht programmiert ist.

Ich nehme an du nutzt Software die du selbst nicht geschrieben/codiert hast und wunderst dich über die Ergebnisse?

Was willst du damit zum Ausdruck bringen, dass die die LLMs programmiert haben wissen warum jeder Parameter im Netz einen bestimmten Wert hat, weil man ja einfach nur den Code analysieren muss? Ein neuronales Netz ist kein klassisches Programm. Nach dem Training kann man einfache Netze in klassische Programme umwandeln, verstehen kann man sie dann trotzdem nicht, denn das „Geheimnis“ steckt in der Kombinatorik der einzelnen Variablen. Es ist ja nicht so, dass ich das erfunden habe, dass das NN eine Art Blackbox ist, die man vielleicht theoretisch entschlüsseln könnte, dies aber praktisch nicht geht.

Summa

hate is always foolish…and love, is always wise...

Klar, die Umwelt ist für die Entwicklung nicht wichtig, man sieht das ganz deutlich in der NaturBei beiden gibt es zwei Ebenen. Einmal den Bauplan nach dem gelernt wird (Gehirn/Software), das entscheidende für das Resultat ist aber die andere Ebene, das paar aus Input und Ziel.

Bevor ich hier noch anfange dich zu beschimpfen möchte ich lieber - wie weiter vorne schon erwähnt - besser nicht weiter diskutieren, ist reine Zeitverschwendung weils stark Richtung Murmeltiertag geht. Deine Meinungsstabilität ist nicht zu knacken, Argumente aus der Informatik prallen an dir unverstanden oder ungelesen ab und scheinen von daher nicht auch nur die geringste Wirkung zu erzielen.

Martin Kraken

Anfänger

Klar, die Umwelt ist für die Entwicklung nicht wichtig, man sieht das ganz deutlich in der Naturund die Entwickler der Software bekommen nur aus Spaß dafür Geld ein entsprechendes Ökosystem für Neuronale Netze zu erschaffen

Hä? Es ist schwer für mich dir zu folgen. Wer hat gesagt die Umwelt ist für die Entwicklung nicht wichtig? Das ist alles so wirr. Schau unsere Diskussion ist folgende:

Ich: NN sind eine Blackbox (was so die vorherrschende Meinung unter KI-Wissenschaftlern ist).

Du: NN sind keine Blackbox, sondern nur gewöhnliche Programme, die die Leute verstehen die sie programmiert haben.

Ted-Talk von jemand der sich der damit seit Jahren beschäftigt:

Ach, ne alle dumm, das schaust du dir ja nicht an, alle dumm außer du.

Ach ne auch dumm.

Ach ne, Anthropic, denen darf man sowieso nicht glauben.

Ach nein Talks auf ner wissenschaftlichen Konferenz? Warum solltest du dir das anschauen? Du hast in den 90ern doch mal ne Vorlesung besucht zum Thema.

Vielleicht auf Deutsch? Hier ein Prof. für Informatik (Jouanne-Diedrich)

Ach ne. Alle dumm, außer dieses Forum.

Cee

been there, done that

Na jetzt aber mit vereinten Kräften, hihi.

vielleicht sollte er seinen eigenen "ich" fred aufmachen mit ki als antwort bot...

Der neue Bot, die Singularität Dunning-Kraken, hat Vids gepostet...

Martin Kraken

Anfänger

Der neue Bot, die Singularität Dunning-Kraken, hat Vids gepostet...

Haha, fühlst du dich stark in der Gruppe

Zuletzt bearbeitet:

Cee

been there, done that

Aber du musst mal etwas mehr Mühe investieren. Bei „ anekdotischen Einwürfe“ musste ich schmunzeln, das war ganz unfreiwillig komisch, weil es AI zu einer Person macht, über die ich Anekdoten erzähle.

Sollst nicht dumm sterben:

Wikip.:

„Anekdotisch" nennt man auch Sammlungen von Einzel-Beobachtungen ohne methodische Kontrolle und statistische Gewichtung.

Darüber hinaus wird ein Kenntnisstand als „anekdotisch“ bezeichnet, der auf unsystematisch gewonnenen einzelnen Berichten beruht.

Martin Kraken

Anfänger

Sollst nicht dumm sterben:

Wikip.:

„Anekdotisch" nennt man auch Sammlungen von Einzel-Beobachtungen ohne methodische Kontrolle und statistische Gewichtung.

Darüber hinaus wird ein Kenntnisstand als „anekdotisch“ bezeichnet, der auf unsystematisch gewonnenen einzelnen Berichten beruht.

Der Text bezieht sich auf „anekdotische Beobachtungen“, natürlich hast du das weggelassen sowie den ganzen Rest des Wikipedia-Artikels

Ein „anekdotischer Einwurf“(so wie du es geschrieben hast) hat nichts mit einer „anekdotischen Beobachtung“ zu tun.

Bei einer anekdotischen Beobachtung, beobachtet man etwas, kann es aber statistisch nicht belegen. Das große NNs eine Blackbox sind kann man aber statistisch belegen, denn bei keinem der LLMs kann man nachvollziehen wie sie zu einer bestimmten Antwort kommen (außer natürlich die Leute hier im Forum, die können das, hihi).

Meine Ausführungen über Intelligenz und Verstehen sind keine anekdotischen Beobachtungen. Dies sind Diskussions-Beiträge. Jeder gute wissenschaftliche Artikel endet mit einer Diskussion. Darin werden die Erkenntnisse die man in den Ergebnissen gewonnen hat diskutiert.

Schau

LLMs können wissenschaftlich und statistisch nachgewiesen komplexe Aufgaben lösen, die sie nie zuvor gehört haben, zum Beispiel sehr komplexe Matheaufgaben (z.B. die der Mathe-Olympiade). Aufgrund ihres Trainings haben sie aber nur gelernt immer das nächste Wort in einem Satz vorauszusagen. (Das ist der Fakt, das Ergebnis in einer Publikation).

Und jetzt kommt die Diskussion: Können LLMs intelligent sein? Warum funktioniert die Generalisierung? Vielleicht sagen wir auch nur aufgrund der von uns gespeicherten Informationen die nächste beste Handlung voraus? Vielleicht gibt es sowas wie Verstehen gar nicht?

Weißt du, ich habe kein Problem, wenn Leute in einer Diskussion mal über die Strenge schlagen, so lange sie die Diskussion voranbringen. Aber Leute wie du, sind wie Scheisse unterm Schuh. Das einzige was du hier gemacht hast ist versucht mich zu diskreditieren in dem du so Floskeln wie „anekdotische Einwürfe“ und „Kindernetzwerke“ machst. Keinen einzigen sinnvollen Beitrag zur Diskussion. Du kommst nur um zu zerstören, wähnst die Masse hinter dir und kloppst auf den Aussenseiter. So ein richtiger Widerling. So ein Fähnchen in den Wind-Typ.

Cee

been there, done that

Weißt du, ich habe kein Problem, wenn Leute in einer Diskussion mal über die Strenge schlagen, so lange sie die Diskussion voranbringen. Aber Leute wie du, sind wie Scheisse unterm Schuh. Das einzige was du hier gemacht hast ist versucht mich zu diskreditieren in dem du so Floskeln wie „anekdotische Einwürfe“ und „Kindernetzwerke“ machst. Keinen einzigen sinnvollen Beitrag zur Diskussion. Du kommst nur um zu zerstören, wähnst die Masse hinter dir und kloppst auf den Aussenseiter. So ein richtiger Widerling. So ein Fähnchen in den Wind-Typ.

Erzähl mehr von Dir.

Ähnliche Themen

- Antworten

- 8

- Aufrufe

- 2K

News

-

News Next-Generation MIDI Controller kommen - eine ganze Ladung

- Gestartet von Moogulator

- Antworten: 1

-

2026-01-18 Dortmund - Next Level Ausstellung - läuft noch.

- Gestartet von Moogulator

- Antworten: 2

-

-

News Konzertbericht - Assfalt + Tigerjunge - Düsseldorf, 5.12.2025

- Gestartet von Moogulator

- Antworten: 0

-

-

News Sounddesign und Auswahl - Studiomöbel und Aufstellung - 2 Themen im SequencerTalk 261 - live 20:30

- Gestartet von Moogulator

- Antworten: 1

-

News Waldorf Protein - Talk mit Rolf Wöhrmann über eine neue Synthesizer-Serie

- Gestartet von Moogulator

- Antworten: 0

App installieren

So wird die App in iOS installiert

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.